C’est le nouvel Eldorado à conquérir pour les concepteurs de puces, au delà des déjà très complexes fonctions intégrées dans les circuits graphiques, l’arrivée d’une solution capable d’épauler efficacement une Intelligence Artificielle logicielle devient un Must Have technique. Pour Imagination Technologies, cela passe par un nouveau circuit baptisé Neural Network Accelerator.

L’arrivée des nouveaux iPhone 8 signe également l’arrivée d’une nouvelle puce chez Apple. Le SoC A11 Bionic n’emploie plus de circuits PowerVR issu des laboratoires d’Imagination Technologies. Un coup dur pour la boîte qui, avec Apple, avait un client à la fois énorme et prestigieux. Depuis lors, on a parlé d’une vente possible d’IT, d’une faillite et d’autres déboires qui pourraient lui arriver. Si le concepteur de solutions graphiques a bien indiqué s’intéresser à une éventuelle reprise par un autre acteur, elle n’a pas licencié pour autant son personnel et ses ingénieurs travaillent toujours à la conception de nouveautés. Le calendrier de développement d’une puce graphique n’est pas le même que le calendrier financier et tandis que les comptables s’agitent mois par mois, il faut compter sur plusieurs années de développement entre la conception et la finalisation d’un nouveau chipset.

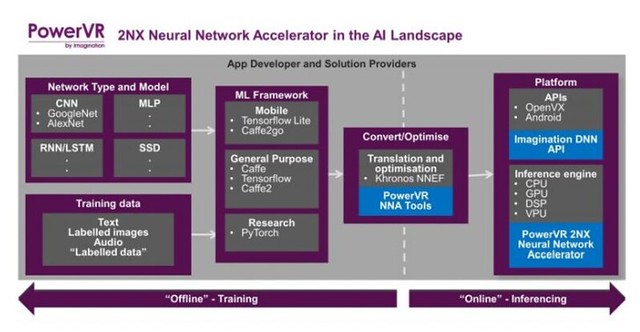

Imagination technologies annonce donc de nouvelles séries de circuits graphiques : Les PowerVR Series 9XE et Power Series 9XM. Des évolutions intéressantes qui sont accompagnées d’une vraie nouveauté, le Neural Network Accelerator qui n’est rien d’autre qu’un système pensé pour accélérer les capacités de calcul d’une Intelligence Artificielle embarquée.

Un exemple de ce que peut faire une « IA » sur une photo.

Cette nouvelle Architecture permet de calculer de manière matérielle des taches classiques mais gourmandes que l’on retrouve aujourd’hui dans beaucoup de dispositifs sans que l’on ne saisisse toujours très bien qu’il s’agit d’un véritable petit exploit de calcul technique : La reconnaissance faciale, la détection des sourires, le suivi des visages, des yeux, la reconnaissance d’objets, tous ces éléments intégrés comme des services aux cameras embarquées sur nos plateformes sont issues de calculs complexes souvent imposés à des soC qui ne les traitent pas forcément de manière efficace. Même chose pour la prédiction de mots lorsque vous commencez à les pianoter hors connexion. Les divers programmes de retouche automatique d’images sont également très gourmands en capacités d’analyses de celles-ci. J’ai déjà fait un petit billet sur le sujet à l’occasion de l’annonce des nouveaux SoC ARM. Le Machine Learning et l’Intelligence Artificielle ne sont plus des outils accessoires mais des éléments qui vont être demandés par les constructeurs dans tous leurs nouveaux appareils. Apple a intégré un circuit de ce type dans son nouveau SoC, ARM les prévoit pour ses Cortex-A78 et Cortex-A55, Huawei travaille là-dessus sur ses Kirin, Nvidia semble ne plus s’intéresser aux chipsets graphiques mobiles mais travaille sur l’IA des voitures autonomes et Intel a mis la main sur Movidius pour ce type de tâches expertes.

L’idée du Neural Network Accelerator d’IT est donc bien de décharger de ces tâches le SoC ARM ou le circuit graphique pour les orienter vers un nouveau circuit spécialisé. Cela permet de traiter ces éléments beaucoup plus rapidement et surtout de travailler de manière déconnectée. Avec une puce de ce type, vous pouvez vous passer d’une connexion pour vous aider à prédire vos mots et surtout vous pouvez entraîner efficacement votre logiciel à reconnaître vos mots les plus souvent utilisés. Plus besoin d’envoyer le début de votre mot dans les nuages et d’attendre un retour pour vous faire des propositions. Cela se passera en local et sera lié à vos mots les plus couramment employés.

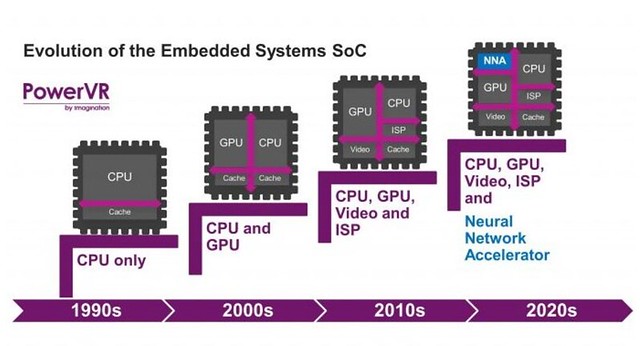

Pour beaucoup de structures plus petites que ces géants, ou ne disposant pas des ingénieurs spécialisés que ce genre de développements requiert, la solution Neural Network Accelerator pourrait bien être une voie de sortie. Si les appareils haut de gamme commencent à proposer une vraie reconnaissance faciale ou des solutions de retouche automatique avancées pour les images, il faudra que leur puce soit capable d’y répondre pour trouver de nouveaux marchés. Du moins en attendant de pouvoir acheter les licences des futurs SoC ARM ou pour proposer des solutions alternatives. Comme on a vu apparaître des fonctions spécialisés comme la prise en charge d’un traitement vidéo, l’intégration de fonctions de communication ou autres, la brique que représente l’aide à une IA embarquée va rapidement devenir une norme indispensable pour les concepteurs de SoC.

A lire :

ARM dévoile ses nouvelles architectures Cortex-A75, Cortex-A55 et Mali-G72

Source : imgtec

| 2,5€ par mois | 5€ par mois | 10€ par mois | Le montant de votre choix |

mouais, globalement personne en sais ce que sont ces systèmes hardware … juste une sortent de second GPU modifié ?

en que ce hardware va apporter a l’IA ? chaque algorithmes soft ayant sa propre méthode d’analyse ?

Je ne peut pas m’empêcher que cette mode du hardware dédié a l’IA n’est qu’un abus de langage commercial …

@karenax: Je suppose que cela va fonctionner comme les GPU oui. Au départ désordonné puis un algo va unifier (ou tenter de) comme les OpenGL / DirectX etc

j’aurais plus pensé à un type ASIC, genre de puce ultra-spécialisé pour faire une seul tache (mais très bien).

mais je suis d’accord avec Karenax, quand on lit les promotions de ces puces on à l’impression d’être face à des mini-cerveaux, des trucs de ouf pour l’IA… alors qu’en faite elles sont super limité (mais soulage fortement les GPU+CPU des taches lourdes).

je parle plus d’ASIC que de GPU_like, car les GPU nous pouvons leur faire faire autre chose que de l’affichage vidéo… dans les labo de recherches ils accélères nos calculs par exemple (et pas qu’un peu !!!).

@Augure: Oui il faut savoir garder la tête froide avec ces unités. C’est un peu comme des calculatrices : très bête. Ok on peu faire des calculs très complexes avec ces solutions mais il faut savoir dialoguer avec elles et pour le moment ce n’est pas encore le cas (a l’exception d’Apple).

A cette annonce, je ne peux m’empêcher de penser que le futur gros outil du big data, c’est ça. Directement en hard.