C’est en 2014 que Nvidia a lancé sa gamme de cartes de développement Jetson. Avec des solutions assez abordables dès le départ compte tenu de l’époque. On pouvait alors trouver un premier modèle à 199$ et des solutions qui grimpaient jusqu’à 1099$. Pas donné mais cela correspondait au marché et aux coûts de développement de l’époque.

En 2019, Nvidia annonçait le Jetson Nano, une solution plus grand public qui proposait pour 99$ une carte de base parfaite pour s’initier au développements autour de l’IA. Beaucoup plus abordable pour un particulier, un fablab ou un groupe de travail, elle a été la base de nombreux développements et projets tout au long de l’année.

Cette année, Nvidia annonce la Jetson Nano 2Go, une nouvelle carte de développement proposée à 59$. Un investissement qui va pousser les particuliers à s’intéresser aux développements de solutions exploitant l’Intelligence Artificielle. Avec un investissement aussi faible – même si il faut prendre en compte certains à-côtés comme pour les Raspberry Pi – la carte devient totalement accessible.

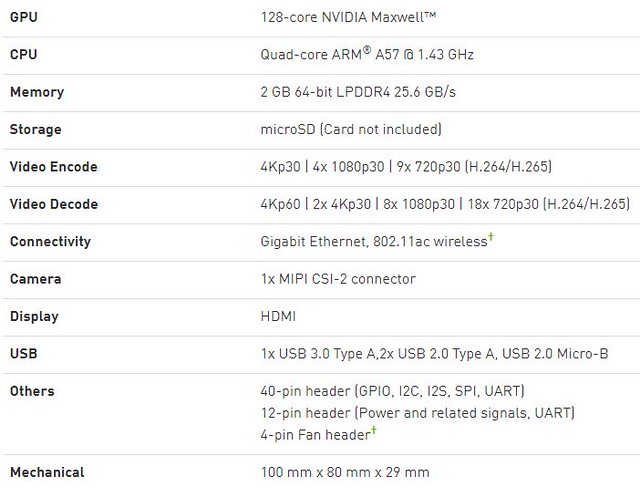

Quelle différence de moteur entre la Jetson Nano 2Go et le précédent modèle ? Un passage de 4 à 2 Go de mémoire vive. Le reste de la carte est absolument identique d’un point de vue performances. La solution embarque un SoC quadruple coeur ARM Cortex-A57 cadencé à 1.43 GHz associé à une solution graphique Nvidia Maxwell 128 coeurs qui pilotera les applications d’Intelligence Artificielle. Le pack de développement est le même, construit autour d’un SDK Nvidia Jetpack sous Linux.

La solution utilise un lecteur de cartes MicroSDXC comme stockage et propose à la fois un module Wifi5 et un port Ethernet Gigabit. La Jetson Nano 2Go est capable d’encoder en H.264 et H.265 en UltraHD à 30 images par seconde. La solution pourra également prendre en charge 4 flux FullHD à 30 images par seconde ou 9 flux en 720P toujours avec le même débit. L’idée étant de pouvoir suivre ce type de flux à des fins d’analyse.

En décodage, la puce Maxwell se montre encore plus performante avec la possibilité de décoder, en temps réel, un flux UltraHD à 60 images par seconde, deux flux UltraHD à 30 images par seconde, 8 flux fullHD à 30 images par seconde et pas moins de 18 flux en 720P30…

Un connecteur MIPI-CSI-2 permettra de brancher directement une camera sur la machine et une sortie HDMI de diffuser les signaux sur un écran. On retrouvera également un port USB 3.0, deux USB 2.0, un USB Type-C et un MicroUSB pour l’alimentation. Enfin, les 40 broches classiques sont disponibles sur la cartes avec GPIO, I2C, I2S, SPI et UART.

Un pack de 12 broches supplémentaires permettra de piloter l’alimentation et divers autres signaux. Enfin, si la carte est fournie avec un dissipateur passif sur son SoC, Nvidia propose un système de broches pour ajouter au besoin un petit ventilateur supplémentaire… En cas de besoin. Comprendre si vous effectuez des calculs d’IA intensifs sur de très longues périodes.

La carte change également quelques points techniques pour arriver à ce prix : Les quatre ports USB 3.0 du modèle à 99$ ont disparu au profit d’une combinaison mêlant 1 port USB 3.0 et 2 ports USB 2.0. Le DisplayPort disparait et le chargeur de l’engin n’est plus fourni par défaut. Des différences qui justifient la commercialisation des deux cartes en parrallèle par Nvidia.

Les usages sont vastes, très vastes. L’Intelligence Artificielle est encore en train de naitre et il y a tout à inventer à ce sujet. Pour tous les usages, tous les métiers, c’est un pan entier de l’informatique qui est en plein boom. La Jetson Nano 2Go est une base de travail et d’initiation d’autant plus intéressante que tout ce qui sera développé sur ces solutions abordables pourra être réutilisé dans des échelles plus vastes dans le futur. Si vous trouvez l’algorithme de demain, il sera possible de l’optimiser pour qu’il fonctionne sur les serveurs les plus puissants de Nvidia en adaptant juste votre code pour en prendre la charge.

C’est d’ailleurs là toute l’idée de Nvidia, lancer une carte accessible pour que les développeurs se fassent la main dessus et utilisent son Jetpack pour s’initier au développement de ce type d’outil. Espérer qu’ensuite ils transforment un essai en véritable fondation de développement de projets plus complexes en terme d’IA. La bonne vieille stratégie de l’utilisateur prix « au berceau » et orienté vers l’usage de ses produits. Nvidia proposera d’ailleurs des certifications et des formations en ligne via son site. Une stratégie payante à moyen et long terme quand on lance, comme Nvidia aujourd’hui, un Jetson Nano 2Go au prix aussi abordable. A 59$ pièce, il va être difficile de tourner le dos à la solution qui devrait rapidement entrer dans de nombreux nouveaux projets.

J’ai reçu un exemplaire aujourd’hui, je vais essayer de faire un petit quelque chose avec…

| 2,5€ par mois | 5€ par mois | 10€ par mois | Le montant de votre choix |

« Quelle différence entre la Jetson Nano 2Go et le précédent modèle ? Un passage de 4 à 2 Go de mémoire vive. Le reste de la carte est absolument identique. »

Euh… non, pas tout à fait (cf https://www.androidauthority.com/jetson-nano-2gb-1164788/) :

« To hit the $59 price point, there are a few other differences between the 4GB and 2GB variants of the Jetson Nano. Most noticeable is that the 2GB version only has one USB 3.0 port (compared to four on the 4GB model), but adds two USB 2.0 ports. The DisplayPort socket has been removed from the board, but the HDMI port remains. Also, the development board is now powered via USB-C and the power brick is not included. »

On peut utiliser le GPU pour du calcul (ecosystème Cuda, …). Cela ouvrirait à pas mal d’application hors de portée des raspi

@revodev: Yep j’ai corrigé, le cache devrait mettre ça à jour rapidement.

@calvin: oui

@Will: En l’occurrence cela permet de faire la même carte sur des carte support différente et devient donc plus économique que de tout souder.

Accessoirement cela permet de changer de solution si elle évolue sans avoir a démonter tout son projet. si demain Nvidia lance un nouveau système basé sur un nouveau duo Soc avec un nouveau GPU sur ce même format, on pourra en profiter en quelques minutes.

Quote Pierre : « L’Intelligence Artificielle est encore en train de naitre et il y a tout à inventer à ce sujet. »

@Pierre : non, c’est pas toi qui sort une telle banalité, pas possible ?! ;-)

Dire que tout reste à inventer sur l’AI est un peu abusif, je trouve.

Je dirais même que c’est plutôt le contraire, mais je parle sous le contrôle d’experts qui auront lu ton billet.

Par contre, tout reste à vendre oui !

Par ailleurs, je suis 100% d’accord avec @calvin : un GPU pour ce prix exploitable pour du calcul, c’est vraiment pas mal.

@eeegr: Tout reste a inventer, je persiste. Il y a j’en suis sûr des milliers d’idées et de scénarios a développer. Chaque métier, chaque hobby, énormément de problèmes peuvent en tirer parti.

Après oui, les grandes lignes de la reconnaissance d’objet ou d’analyse d’image sont déjà là, mais je pense qu’il y a encore tout à en faire. Et je reste persuadé que plein d’autres choses sont encore enfouies dans de jeunes cerveaux ;)

@Pierre Lecourt:

Personnellement, je manque de base théoriques pour juger du véritable potentiel de l’IA… même s’il y a 25/30 ans elles étaient déjà posées mais pas vraiment enseignées faute d’usage alors visible.

Par contre, gare à ne pas traiter sous cet angle des problèmes qui pourraient l’être plus classiquement, mais pas vraiment les mêmes ressources à mettre en face!

@yann: La grosse différence entre il y a 25 ans et aujourd’hui, ce sont les outils. Les smartphones suffisent à des tâches d’IA basiques. Tout le monde en a un dans sa poche. Mais demain avec des outils comme celui-ci ce sont des éléments beaucoup plus concrets qui peuvent apparaitre.

Benedict Evans fait un parallele intéressant entre l’IA et les bases de données il y a 30 ans. Un outil puissant mais compliqué, qui peut etre utilisé bien ou mal, besoin de standardisation, de materiel et outils logiciels appropriés mais normalisés… pour sortir des labos/verticaux pointus.

Hello ! Je me demande si 2GB c’est suffisant pour du calcul IA, c’est pas pour critiquer, c’est une vraie question. Par exemple, si je dois analyser une vidéo lourde ou un fichier csv de plusieurs GB, est-ce ce serait possible ?

Pour la remarque du « berceau », je suis tout à fait d’accord, ça rappelle les formations Microsoft ou Amazon AWS. Ceci dit, ça permer de toucher concrètement à un projet IA sur GPU, et ça c’est cool.

Moi l’ia ça me fait peur

Pas le syndrome Terminator ou alien

Mais j’ai l’impression que l’humain a atteint ses limites d’évolution

L’ia comble ce manque

Mais l’ia ne deviendra t’elle pas un jour trop évoluée pour l’humain lui même ?

Nous sommes tous en trains de devenir des assistés, écran , déplacement service, livraison ,

Nous passons tous notre vie derrière des écrans des le plus jeune âge

Nous mangeons de la merde

En 120 ans d’évolution industriel la planète à pris plus chère qu’en 65000 ans

Le monde dans lequel je vis me faire peur

Et si une ia devenait si puissante qu’elle que soit sa forme, anéantissant l’humanité pour sauver la vie ?

Aller pour revenir au sujet, oui c’est cool ce petit truc, du dev ia accessible, jean Michel du 38 pourra créer un outils pilotant son robot qui lui rapportera son coca de son frigo connecté

@Pierre Lecourt:

Entre nous, les modules IA sur les soc des smartphones sont surtout de bêtes co-processeurs logarithmiques programmables qui permettent des fonctions un peu avancées et surtout rapides par rapport à un processeur tout en un.

Typiquement, la reconnaissance faciale (la fonction IA la plus exposée) n’est qu’un bête processus de codification des visages et une comparaison qui font que deux visages matchs. Ce sont des algorithmes de plus en plus fins et des processeurs algorithmiques de plus en plus rapides qui rendent ces fonctions « magiques ».

C’est meilleur que les TV-BOX à base de S905/912 ou ce n’est pas du tout comparable ?

Si demain, je veux un armbian le + performant possible, que choisir ?

Merci !

@Dliryc:

Ca n’a aucun intérêt en terme de performance CPU, uniquement si tu as des modèles à faire tourner.

@prog-amateur : Ca dépend de ce que tu appelles calcul IA, si c’est pour de l’entrainement c’est clairement insuffisant, si c’est pour de la prédiction simple, ça va (les modèles doivent être transformés pour tourner, ils deviennent beaucoup plus petits). Lorsque tu fais tourner un modèle, tu lui fournis en entrée un stream qu’il va catégoriser, donc pas besoin de tant de RAM que ça.

@Pierre Lecourt

N’est-il pas plus intéressant d’utiliser la carte IA en clé USB d’Intel (déjà présentée sur ce site) ?

On peut alors programmer avec tous les outils de l’écosystème d’un vrai PC.

@Bernard: Et bien le Movidius n’est pas autosuffisant. Cela veut dire qu’il faut laisser un vrai PC en route en plus de la carte pour chaque projet. Et ce n’est pas portable non plus.

La Jetson Nano c’est 472 GFlops pour 59$

La Movidius est à 100 GFlops pour 79$

Et il faut ajouter une RPI ou un PC pour faire tourner le Movidius… le choix est assez vite fait.

D’autant que le SDK de Nvidia peut également se programmer avec tous les outils d’un vrai PC et qu’il est scalable, le programme mis en place peut se transporter en quelques clics sur une interface Nvidia Jetson TX2 et avec 1.33 TFlops ou un Jetson Xavier pour… 21 TOPs.

Excellente idée de la part de Nvidia, qui va voir apparaître d’ici qq années une génération d’informaticien IA formatés sur SES outils.

Question bête, mais je la pose quand même, est-ce qu’on peut utiliser ce type de carte pour faire du minage de crypto-monnaie ? Car vu le prix, à la place d’une carte graphique haut de gamme pour miner on peut s’offrir un petit parc de Jetson Nano 2Go…

[…] plus classiques pour un particulier. Que ce soit du côté des cartes type Raspberry Pi ou de la Nvidia Jetson Nano 2Go qui propose beaucoup d’éléments pour moins cher mais qui nécessite la réalisation […]