Depuis toujours chez Intel, on utilise les coeurs de ses processeurs pour tous ses calculs. C’est la règle intangible qui explique en bonne partie la philosophie des puces du fondeur. Le fait que la marque annonce recourir au processeur secondaire qu’est son circuit graphique est un énorme changement.

Intel annonce donc deux nouveautés spécifiques à ses processeurs en terme de sécurité logicielle pour détecter d’éventuelles menaces sur votre machine. La première est appelée Advanced Platform Telemetry et utilise un algorithme de machine Learning pour détecter et identifier les risques potentiels de votre machine.

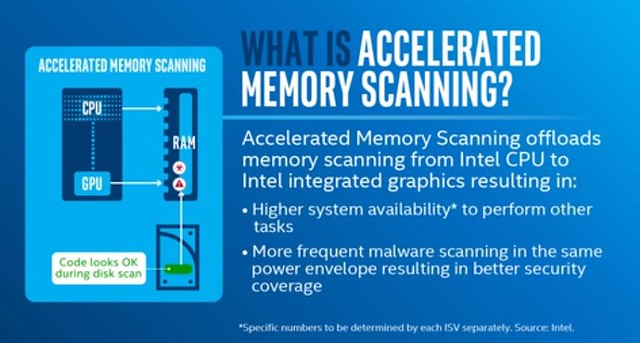

La seconde, baptisée Accelerated Memory Scanning crée cet énorme changement puisqu’il s’agit pour Intel de profiter des capacités de calcul de ses puces graphiques pour effectuer des calculs de détection plus rapides en cas d’attaques sur la mémoire embarquée. L’idée de cette solution est de libérer le processeur pour des tâches plus complexes et ainsi économiser de l’énergie.

Aujourd’hui, l’analyse nécessaire à la détection de logiciels malveillant utilise environ 20% des capacités de calcul d’un processeur Intel Core. Pendant ce temps, le circuit graphique embarqué est très souvent fort peu sollicité. Avec l’Accelerated Memory Scanning, les ressources utilisées passent à 2% seulement. Un gros gain de performances donc en libérant 18% des ressources du processeur pour d’autre tâches.

Les développeurs de solutions de défense informatique pourront s’appuyer sur les données publiées par Intel pour mettre en place ce type de stratégie. Pour le moment, seul Microsoft semble se pencher sur ce nouveau joujou : cette approche ne sera pas disponible pour le moment pour les particuliers mais plutôt intégrée aux versions « Advanced » de Windows Defender. Celles vendues aux entreprises et non pas celles intégrées directement dans Windows. Et cela pour toutes les machines Core depuis la 6e génération.

On imagine que depuis Spectre et Meltdown, Intel a remis la sécurité au niveau des priorités les plus importantes de son développement. Cela a sûrement poussé à trouver de nouvelles voies de développement et à sortir des sentiers battus. Les prochaines générations de processeurs devront non seulement proposer une étanchéité complète à ces failles catastrophiques mais également montrer une évolution importante dans la stratégie de protection de ce type d’attaques. Si un processeur peut permettre de lutter efficacement et activement pour la sécurité d’un poste, il aura sans doute la préférence des investisseurs.

On sait qu’un des gros challenges d’Intel pour les années qui viennent va être de faire face aux architectures serveurs basées sur des circuits graphiques tels que les proposent Nvidia. Evidemment, l’échelle n’est pas la même mais recourir à un GPU pour effectuer des calculs pour libérer le CPU revient un peu au même d’un point de vue fonctionnement. Intel prend désormais en compte le GPU comme une entité capable de faire des choses différentes qu’un simple affichage graphique. Une tournure d’esprit qui indique peut être de profonds bouleversements au sein de la marque. Intel serait en train de travailler sur un circuit graphique à part entière, cette nouvelle approche pourrait avoir beaucoup de sens dans le futur.

Mais c’est surtout le changement de perspective d’Intel qui est intéressant ici. Si, à l’avenir, la marque se met à produire ses propres GPU externes, et cela semble être le cas, peut être épaulera t-elle cette nouvelle solution dans plus de domaines. On le voit régulièrement au quotidien pour peu que l’on travaille l’image ou la vidéo, l’usage des capacités de calcul d’un GPU évolué fait des merveilles. C’est la stratégie de Nvidia avec ses coeurs CUDA. Si Intel dirige ses futurs circuits graphiques dans cette même optique, le résultat peut être très intéressant à observer. En imaginant que cette stratégie se marie un jour avec l’implantation au coeur des puces de la marque d’un système de Machine Learning de type Movidius, les possibilités d’un cocktail de ce type risquent d’être surprenantes.

| 2,5€ par mois | 5€ par mois | 10€ par mois | Le montant de votre choix |

Pas idiot… dans 90% des cas nos machines à processeur Intel (de l’i3 à l’i7) sont épaulées par des cartes graphiques dédiées (de chez NVidia ou AMD), laissant ainsi la partie GPU de nos CPU dormante voir presque inutile (le presque c’est que si la CG vient à rendre l’âme, le GPU intégré peut nous sauver les miches… c’est du vécu!).

Alors pourquoi pas se servir de cette ressources pour faire les taches non lancées par l’utilisateur (scan de sécurité, mise à jour, etc..)…. et même pour le grand public cela pourrait être intéressant…

Bonjour Pierre,

je suis le blog depuis un moment et il y a une question qui me taraude depuis toujours. Concrètement, quelle est la différence entre un CPU et un GPU ? Qu’est-ce qui fait que l’un est bon pour les tâches courantes et l’autre est bon pour la vidéo, le jeu, les rendus 3D… ?

Si tu as un lien d’explication ou une explication simple, ça serait top !

Merci

Cette possibilité ressemble à un « cavalier » : on profite d’une opportunité ( la carte graphique n’est pas un composant optionnel: elle s’impose à toutes les fonctions déjà existantes d’un PC: l’OS, l’alim, la connexion, la priorité de fonctionnement… jusqu’au prix que l’utilisateur est prêt à y mettre) pour y ajouter des fonctions accessoires.

Il était logique que NVIDIA développe son offre, quasiment en prenant la part graphique comme un prétexte à concurrencer le CPU…

Le GPU permet d’effectuer le même traitement sur plus de données en même temps grâce à une structure hautement parallèle. Mais il y est moins polyvalent que le CPU.

https://fr.wikipedia.org/wiki/Processeur_graphique

https://fr.wikipedia.org/wiki/Processeur

@Etienne: « Prend un livre et un logiciel programmé pour compter le nombre de fois qu’un mot est utilisé dans ce livre. Lance ce logiciel sur un CPU, il commencera à la page une du livre, le lira entièrement mot par mot et te donnera par la suite une réponse. Donne le même problème à un GPU et il divisera le même livre en des centaines de partie, pour toutes les lires simultanément. »

Le CPU a une conception monotâche et pensé pour la force brute. Bien qu’aujourd’hui multi-core et hyperthreadé, en multitâche, le CPU est loin d’égaler l’architecture massivement parallèle du GPU. Par contre en monotâche, le CPU l’emporte haut la main. Il n’y a qu’a regarder les fréquences de fonctionnements.

Un GPU possède beaucoup plus de cores qu’un CPU (des milliers pour les plus gros) mais le fonctionnement est assez différent d’un CPU car tous les core d’un même cluster d’un GPU font exactement la même chose au même moment. Ils éxécutent tous la même instruction mais sur des données différentes (c’est qu’on appelle le modèle SIMT, Single Instruction Multiple Threads). Cette contrainte impose que le code soit simple au sens où il doit être très faiblement conditionnel (pour faire simple dans le cas d’un if tout le monde va payer le coût du if et du else). Il doit aussi y avoir très peu de dépendances mémoires et un modèle d’accès très simple. Le GPU se prête bien à tâches qui se découpent bien en morceaux indépendants sur lesquelles on fait exactement la même chose.

Un CPU lui est a moins a beaucoup moins de cœurs mais aussi beaucoup de contraintes sur les types de processing à appliquer, en particulier sur les CPUs modernes qui sont out of order, ont des pipelines très large (plusieurs instructions éxécutées en parallèles), qui ont des prédictions de branches avancées, des mécanismes de “synchronisation” mémoire… Ils sont conçus pour assez rapide même pour des codes compliqués avec beaucoup de dépendances et de conditions.

[…] processeurs de la marque mais également des développements de circuits indépendants et même, si l’on suit les derniers développements d’Intel, un appui de calcul du GPU pour aider le processeur a effectuer des tâches […]