Pour arriver à convaincre les fabricants de smartphones de s’intéresser au Nvidia Tegra 4i, il y a plusieurs voies possibles : Il y a tout d’abord la guerre des prix, ensuite l’ensemble des performances proposées et enfin la facilité d’intégration de sa puce. La meilleure solution pour être sur de vendre son processeur n’est pas d’être le meilleur dans un de ces domaines mais de proposer une solution qui englobe le maximum de point dans chaque catégorie.

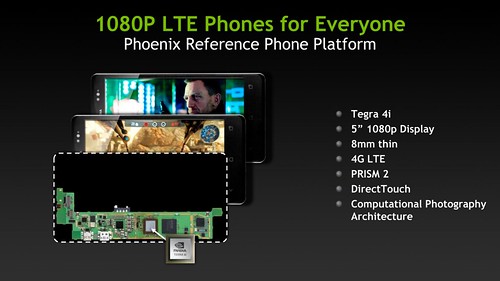

Nvidia Phoenix : Une version Smartphone du Nvidia Kai.

La plateforme de référence Nvidia Kai est apparue l’année dernière comme une solution sur mesure a destination des fabricants de tablettes pour proposer des engins sous Tegra 3. Nvidia réunissait dans des documents techniques complètes l’ensemble des éléments techniques nécessaires à l’intégration d’un de ses processeur au sein d’une tablette. Fort de cette recette, n’importe quel fabricant pouvait utiliser ce design de référence et l’adapter à ses besoins.

Nvidia pratique ce type d’intégration depuis fort longtemps dans le monde des cartes graphique : Les marques les plus connues s’emparent du design proposé pour le pousser à son maximum en lui offrant des fonctions avancées q. Les petites marques ne font que le reproduire à l’identique en proposant juste un logo différent de l’offre de base de Nvidia. Cela permet aux fabricants reconnus de vendre plus cher des cartes plus abouties et aux petits de proposer des « clones » à prix serré.

L’intérêt pour Nvidia est double puisque d’abord il décomplexe les fabricant rendant l’intégration Nvidia facile, ensuite la marque pose sur le marché des jalons clair sur les prix avec des prix de base qui obligent les grandes marques a ne pas s’envoler trop haut sur leur configuration. Un prix tenu qui permet à Nvidia d’espérer plus de ventes que si ses modèles étaient proposés à des tarifs prohibitifs.

Nvidia Kai a donc été le même mouvement l’année dernière sur les tablettes avec le Tegra 3. Le Tegra 4i présenté aujourd’hui reprend la recette en présentant un smartphone de référence baptisé Nvidia Phoenix qui embarque la puce et ses performances mais aussi de la 4G.

Ce smartphone de référence est un engin qui affiche du 1080p sur une dalle 5″. Les constructeurs partenaires de Nvidia pourront se baser dessus pour proposer leurs propres aménagements et la distribuer dans le commerce. Contrairement au cartes graphiques il ne sera pas possible de livrer un Nvidia Phoenix tel quel au public : Il faudra impérativement en changer le design. Cela ne veut pas dire que les composants devront bouger et on devrait donc voir une myriade de produits aux spécifications identiques envahir rapidement le marché.

Si la coque, la taille de la dalle, la définition de celle-ci ou les spécification de mémoire et de stockage vont probablement varier, les éléments de base seront les même : Un processeur Nvidia Tegra 4i qui embarque à la fois la puce de calcul logique, la puce graphique et un modem 4G/LTE.

Pour le constructeur le bénéfice est simple, une seule puce a intégrer, 3 composants déjà en place. Moins de travail et un vrai partenariat de développement avec des documentations techniques qui mâchent le boulot d’intégration au maximum. De nouveaux arrivants pourraient venir se positionner sur ce marché et des gros fabricants vont probablement être tentés de proposer un engin qui ne leur coûtera pas grand chose en recherche et développement et qui proposera à la fois de belles performances et la connectivité 4G.

Que propose le Nvidia Tegra 4i ?

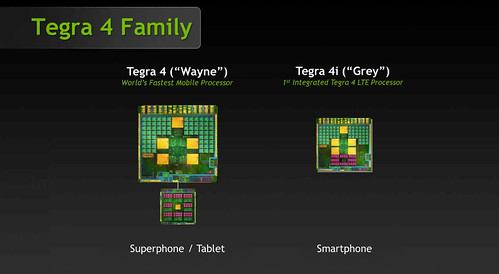

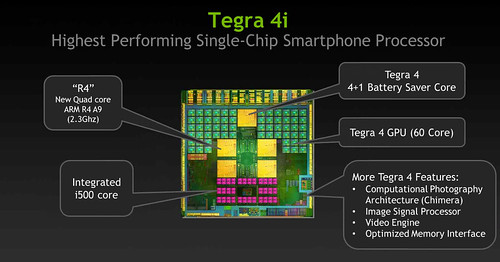

Il s’agit de base d’un Tegra 3 comme son nom ne l’indique pas. Enfin pas tout à fait un Tegra 3 d’origine mais bel et bien un ARM Cortex-A9 même si il s’agit d’une version raffinée de la proposition d’ARM. Nvidia parle d’un « R4 ARM Cortex-A9 » une sorte de mariage entre le Tegra 4 et le Tegra 3 avec des éléments de chaque puce.

On retrouve les 4 coeurs du Tegra 3 d’origine ainsi qu’un « Companion core » moins puissant destiné a prendre le relais de ces 4 gros coeurs pour des tâches ne nécessitant de grosses compétences de calcul. Les 4 puces travailleront désormais à une fréquence maximale de 2.3 GHz au lieu d’un 1.7 GHz max auparavant.

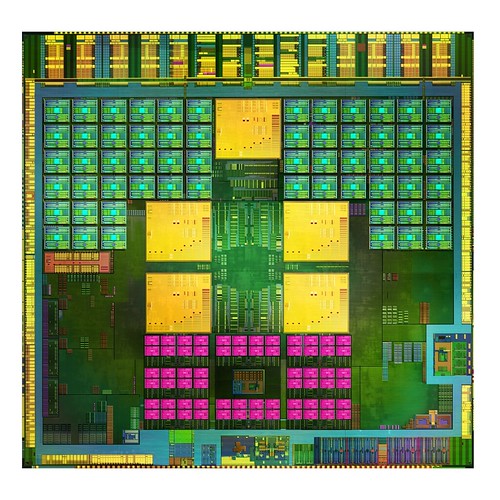

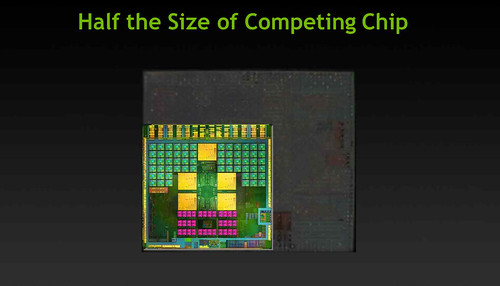

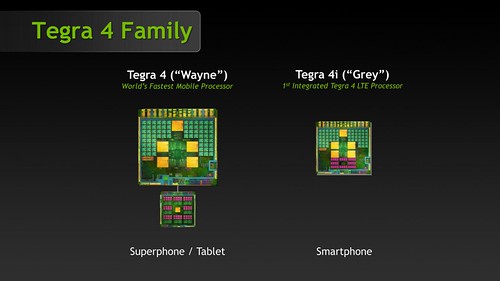

Cette performance est rendue possible par le changement de finesse de gravure de la puce : Plus efficiente car gravée en 28 nano elle en profite pour passer aux technologies de son fondeur , TSMC, et en particulier son « Low Power High-K Metal Gate » qui est un procédé de gestion des signaux électrique plus performant. résultat des courses la puce fond littéralement en taille en divisant quasiment par 2. Le carré de 23 mm de côté du Tegra 4 est ramené à 12 mm de côté pour le Tegra 4i : Une taille qui permet une intégration facile au sein d’un smartphone.

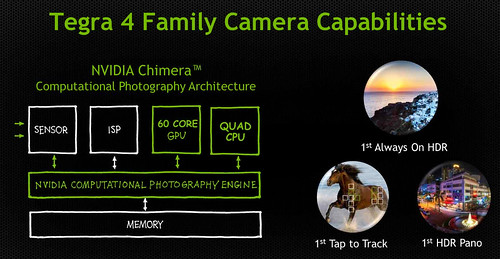

D’autres aménagements ont été fait par rapport aux puces annoncées précédemment : Le Tegra 4 affiche 72 coeurs graphiques tandis que cette nouvelle venue n’en arbore que 60. C’est déjà beaucoup et les fonctions avancées proposées par Nvidia sur le Tegra seront présentes.

La technologie Chimera par exemple pour gérer le rendu HDR d’une film en temps réel sera de la partie. La mémoire maximum que le processeur pourra gérer est de 2 Go et elle pourra afficher en 1920 x 1200.

La grosse nuance par rapport au Tegra 4 ou au Tegra 3 est bien dans l’apparition pour la première fois dans la puce d’un chipset 4G issu du rachat de la marque Icera par Nvidia. Ce modem baptisé i500 est intégré et ne demande non seulement aucune manipulation supplémentaire au fabricants mais il échange ses données en direct avec le processeur tout en profitant de la même finesse d’architecture que le reste de la puce . Il permettra de communiquer via des réseaux 4G/LTE jusqu’à 150 Mb/s ou 3G+ jusqu’à 42 Mb/s.

Et les tablettes dans tout ça ?

La grande question est de savoir si le Tegra 4i va intégrer les tablettes un jour ou l’autre. on sait qu’Asus et Intel vont proposer une tablette 7″ low-cost sous Atom Z2420 proposant à la fois de la 3G et de la voix avec la Asus ME371MG. Il se pourrait donc bien que des concurrents veuille offrir des solutions équivalentes en 4G. Le gros intérêt de la Nvidia Tegra 4i et surtout du Nvidia Phoenix est que l’objectif est de proposer des smartphones complets à un prix situé entre 100 et 300$. soit des smartphones 4G particulièrement abordables et cela avant abonnement.

L’intégration dans une tablette 7″ voir e plus grande est donc tout à fait possible même si pour le moment Nvidia France s’est refusée à tout commentaires à ce propos. On peut très bien imaginer des tablettes actuiellement sous Tegra 3 passer au Tegra 4i, y gagner en autonomie et en performances ainsi qu’en connectivité sans augmenter considérablement leurs tarifs. I ly a bein sur des aménagements a faire pour ajouter les composants nécessaires à la prise en compte dela 4G et de la voix mais sans pour autant être trés éloignés des composants actuels.

Chouette je vais attendre la prochaine fournée de tablettes !

Mais il n’est pas dit non plus que Nvidia n’impose pas un usage smartphone de sa puce et quand bien même le Nvidia Tegra 4i intégrerait un jour une tablette, les premiers smartphones équipés ne sont pas attendus avant al fin de l’année 2013 voire le début 2014 d’après le constructeur.

Il est donc tout à fait possible que se profile un jour une Nexus 7 4G par exemple mais pas avant quelques longs mois.

| 2,5€ par mois | 5€ par mois | 10€ par mois | Le montant de votre choix |

Il y a un long article intéressant chez SemiAccurate (un site de rumeurs un peu plus fiable que l’autre dont le nom m’echappe): http://semiaccurate.com/2013/02/18/nvidias-telegraphs-tegras-woes-at-ces/

En gros, ils expliquent que pour chacune des générations Tegra, nVidia aurait pipeauté sur les perfs, les fonctionnalités et la consommation de leur puce, et que les OEMs, qui concoivent les produits en parallèle avant même d’avoir les puces finales sous la main, se sont fait piéger, et au final se sont retrouvés avec des produits nettement moins bons que ne le promettait la com’ nVidia, mais plus le temps de changer de fournisseur. Du coup maintenant, plus personne ne voudrait bosser avec nVidia.

Pour étayer leurs propos, ils parlent des « design wins » annoncés (les constructeurs qui ont choisi les Tegra 4, en général on en parade une poignée a l’annonce officielle d’une puce, sauf que la, y’en a pas), et le fait que nVidia s’est fait jeter par BMW et Boxee.

Je ne fais que répéter betement en français ce que dit le site, et je n’ai aucune preuve ni info directe. Ceci dit ca parait plausible, et ca correspond aussi a mon experience perso avec un Xoom sous Tegra2 nettement moins bon en vidéo que mon Nook Color A8 monocoeur censé etre beaucoup moins bien.

A savoir si la 4eme version sera la bonne, et si ils vont trouver des OEMs crédibles pour bosser avec eux. En théorie la puce parait bien, après faut voir en pratique, visiblement :-p

Ahhh, je viens de voir que larticle de SemiAccurate est signé Charlie Demerjian, un type qui a pris nVidia en grippe a un degré tellement extrême que c’en est amusant. A prendre avec de grosses pincettes quand meme, donc.

Moi j’espere qu’ils vont nous refaire des pc en arm (en 13 pouces ce serait parfait !

En fait c’est un tegra 3.5 un peu plus puissant !!

Bon dsl du double post mais linux peut etre installé sur un processeur arm on est bien d’accord ?

@obarthelemy:

Oui, j’ai déjà lu des articles de Charlie, à prendre avec des pincettes effectivement ^^

Mais sur le fond je soupçonne qu’il n’ait pas tout à fait tort: NVidia semble prompt à annoncer ses puces comme les plus puissantes ET plus économes en énergie que celles de la concurrence, ce qui ne se vérifie pas dans les tests synthétiques.

Dans la pratique je ne me prononcerais pas, je n’ai au final rien jamais eu d’appareil sous Tegra.

@Pierre: « Cette performance est rendue possible par le changement de finesse de gravure de la puce : Plus efficiente car gravée en 28 nano elle en profite pour passer aux technologies de son fondeur , TSMC, et en particulier son »Low Power High-K Metal Gate » qui est un procédé de gestion des signaux électrique plus performant. »

Mouais, c’est pas ça l’explication, ça n’a rien à voir avec la gestion des signaux, donc je vais préciser car on retrouve de plus en plus ce genre d’information dans des communications grand public, alors que c’est impossible de savoir ce dont il s’agit si on n’a pas fait de la physique du composant.

Un transistor, c’est un interrupteur (en tout cas dans le monde du numérique), et un interrupteur ça doit basculer de l’état passant à l’état bloqué, si possible rapidement et en consommant le moins possible. Physiquement le transistor MOS à 4 terminaux: la grille, qui est en quelque sorte la commande qui va allumer et éteindre les transistors, le drain, qui comme son nom l’indique collecte les charges et est relié à la source par un canal de conduction, la source justement (des électrons ou des trous) et le substrat, qui est la partie dans laquelle on fait physiquement le drain et la source. Avant le 32nm (et pour certains avant), la grille était faite en silicium poly-cristallin dopé, mais avec la miniaturisation, ce matériau ne permettait plus de faire basculer le transistor dans les 2 états passants et bloqués avec de bonnes performances électriques. De même, l’isolant -ou bien diélectrique- qui séparait la grille et le canal de conduction du transistor devenait physiquement tellement fin qu’on faisait vraiment joujou avec quelques unités atomiques, ce qui a rendu le procédé classique inutilisable pour continuer à faire des circuits intégrés dont les performances continuent à augmenter. Du coup, il a fallu trouver quelque chose, et ce quelque chose c’est de faire la grille en métal (Metal gate), qui a de nombreux avantages électriquement parlant, et l’isolant plus épais, en utilisant un autre matériau que celui utilisé jusqu’alors (nouveau matériau dont la constante diélectrique est plus élevé -High-K dielectric-, et par conséquent, pour faire la même épaisseur électrique qu’avec l’ancien matériau, il faut plus d’atomes et donc on a plus de marge sur le procédé de fabrication). Ces changements sont donc purement technologiques, et pas du tout liés à la manière de gérer les signaux. Après pour le terme « low-power », c’est du bullshit marketing :)

@obarthelemy: ce gars ne fait que confirmer ce que tout le monde du semiconducteur sait déjà, c’est que ce sont des bourrins en conception de circuit, avec très peu d’innovation et une consommation de folie par rapport aux perfs de leur chip. Y a rien qu’à voir sur leurs cartes graphiques… De même, un excellent article d’Anandtech sur des mesures réelles de conso des chips pour tablette a montré que le Tegra3 était une daube en conso à comparer des Atom et des Snapdragons…

@obarthelemy: digitimes?

Avec la fameuse rubrique « Digitimes a dit… »

@Pierre: et en particulier son »Low Power High-K Metal Gate » qui est un procédé de gestion des signaux électrique plus performant

pas du tout, ce sont des innovations purement technologiques imposés par le passage à des technos en dessous du 40nm (passage du polysilicium dopé à un métal -ça peut varier mais principalement avec du Tantale- pour faire la grille des transistors, et passage du dioxyde de silicium à un empilement avec du dioxyde d’Hafnium pour l’oxyde de grille). Tout le monde fait ça, et c’est pas TSMC qui l’a inventé.

@Bertrand: Ecoute j’ai déjà fait des papiers très complets par le passé sur ces technos là, je synthétise au max car ce n’est pas le sujet. J’ai parlé Tri Gate d’Intel sur Blogeee et je vais pas refaire le monde ici ( http://www.cnetfrance.fr/news/intel-va-graver-ses-puces-en-3d-pour-economiser-en-espace-et-en-energie-39777530.htm ). Le truc de ces papiers c’est que personne ne les lit parce que personne ou presque ne les comprends. J’adorerais mettre un génie de la pédagogie en face d’une camera pour expliquer tout ça mais j’en ai pas sous la main donc je m’abstient.

TSMC n’a rien inventé et ce n’est pas ce que je dis, simplement TSMC s’est équipé pour pouvoir produire en 28 nano HKMG. En disant cela je parle déjà chinois pour 99% des gens et je n’ai plus envie de m’enfermer dans ce truc élitiste. Des sites spécialisés le font bien mieux que moi.

Maintenant si tu veux me contredire sur le fond, je pense que j’ai raison : C’est simpliste, c’est parfaitement réducteur mais le but du jeu c’est bien de gérer de manière plus performante les transistors avec moins de fuites et moins de watts perdus tout en étant plus rapide, c’est donc bien une gestion des signaux électriques plus performante. La manière dont cela est fait est évidemment plus complexe mais demande autour de toi comment fonctionne l’électricité et tu verras qu’un adulte sur 1000 est capable de te donner une réponse satisfaisante.

Ok si on s’en tient au fait que nvidia ment sur les performances energétiques de ses puces et de leur puissance, je crois qu’on est tous d’accord, beaucoup plus de marquetting et de com (il n’y a qu’a voir le renommage de gammes anciennes) que de réelles performances.

Ce que j’aimerais bien approfondir c’est qui fabrique les mali400 et +, qui les conçoit et quelle va être leur évolution, vu qu’on en parle sans arrêt et que ma foi ; ces gpu fonctionnent bien.

Ceci dit quand même pour être objctif, sur pc nvidia reste une des solutions de choix pour le jeu et pour les applications pro, seules les cartes nvidia sont réellement adaptées aux résolutions batardes et aux multi projections avec chevauchement et doublage de la résolution. On n’y est jamais parvenu avec des amd par exemple.

bon ca reste du cortex a9… alors que le a15 est déjà dans certain produit… et surement dans le prochain s4 et note 3…

En resumé, c est du tegra3 avec gravure mise à jour ( plus fine) qui permet d’augmenter la fréquence et une mémoire possible à 2 go comme la concurrence.

@Toys: Oui, et qui sera intégré dans des smartphones vendus entre 100 et 300$ sans abonnement… Et ptet un jour des tablettes 4G :)

@Pierre: donner une vision simpliste ne signifie pas raconter n’importe quoi. Je ne dis pas que c’est facile à vulgariser ce genre de chose, après moi je ne tiens pas un blog et je ne suis qu’un simple contributeur…

@Bertrand: Ok j’arrêterais de parler d’ARM dorénavant, je n’ai pas le niveau.

Disponible fin d’année …aie!

La concurrence sera déjà comme le s4 lowcost.

Je ne comprends pas nvidia.

Pourquoi ne se lancent ils pas comme une console ouya? Plutôt qu.une manette qui va coûter une fortune alors qu’on a tous des portables.

@Toys: un s4 low cost suffira à 99,99% des usagers mobiles

le « truc » de nvidia c’est le jeu (avec les boites de dev et le marketing derrière)

et là ils sont bon et écrasent pas mal la concurrence

elle est là leur carte à jouer

portable-tablette pas chere permettant la même chose « que les grandes »

(3G-4G multimédia, internet, taches basiques) avec le jeu en plus et dans les meilleures conditions arm possibles (même si c’est au détriment de l’autonomie, les joueurs sont habitués, les autres l’apprendrons, s’y ferrons et reviendront après avoir râler un temps et essayer « autre chose »… comme sur pc)

c’est très bien mais a t-on réellement besoin d’une telle puissance ? nvidia joue t-il dans la concurrence du bas de gamme pour smartphone et la je préférer qu’il R&D de la puce très très très faible consommation en tous cas ils vont au charbon au contraire d’ati qui se fait subventionner du volume de puce dépassé dans des consoles soit disant next gen dépassé dans son modèle économique.

@Bertrand:

J’adore les gars comme toi.

Tu défies à toi tout seul l’équipe d’ingénieurs (de génie) qui taf chez Nvidia en les traitant de « bourrins » incapables de concevoir un crcuit.

Rassure moi, t’as pas une pastèque de compète en place de ton encéphale? t’es sous champi ou t’as sniffé un rail de poudre?

C’est bien beau de se la péter naïvement en jouant les Zorro quand il s’agit de la tournure des mots sur un site généraliste, mais si tu pouvais rester un minimum sobre et objectif. De ton niveau extraplanétaire…on en embauche pas chez NV. Ne te demande pas pourquoi, des savants dans ton genre on en lit par centaines tous les jours sur le web. Des gars pas foutus d’imaginer sur 10000 transistors quand chez NV ça travaille sur plus de 7 milliards…et ça vient t’insulter majestueusement qui plus est.

Merci

@Marc Collin: c’est sûr la date de sortie est bien tardive et il y a déjà du monde, mais en soi si ca augmente encore la concurrence sur le creneau du téléphone/tablette suffisamment performant autonome et bien honorable en jeu avec 4G pour un prix je suppose de loin bien inferieur aux appareils sortis et a venir en A15/Big little et Cie c’est toujours bon a prendre (enfin avec 3 grands gamins moi ça m’intéresse ;) )

En fait j’ai dit ca juste pour souligner que le A15 etait pas forcement une super attente du public sur ces formfactors mais en fait j’en sais rien du prix de cette puce ni de ce que sera le marché dans quelques mois niveau tarifs et gammes, meme sans tenir compte de l’évolution des tarifs des operateurs sur les gros marches qui aura son importance aussi je suppose.

Y a que moi que ca interesse la perpective d’avoir un smartphone sous Tegra 3 à moins de 300 euros ? Oui c’est energivore mais on ne peut pas tout avoir et cette manie que nous avons (nous francais) a toujours tout critiquer et ne jamais etre content n’est pas tres positive. Non, je pense que nous ne pourrons jamais (en tout cas pas dans un avenir proche) avoir un smartphone à l’autonomie d’un Nokia 3210…

@Bertrand: c’est le « en profite pour utiliser » qui visiblement t’as posé problème, ainsi que peut-être le « plus performant » qui est un peu flou et ok peut-être que y avait une expression plus heureuse à trouver et c’est bien que ta remarque ait donné l’occasion à Pierre de repréciser les choses en commentaire mais bon y a pas de réel contre-sens et pas de quoi dire que c’est n’importe quoi il me semble, en tant que mi-noob à la lecture je n’avais pas compris que tsmc avait inventé la techno ni qu’ils étaient les seuls à utiliser ce même type de techno, mais par contre j’avais bien capté que c’était un procédé destiné à rendre le bouzin efficace comme Pierre l’a reprécisé en commentaire en tout cas.

Si je puis me permettre je comprends tes appréhensions, mais j’aurais trouvé nettement plus constructif que tu suggères gentiment une meilleure façon de tourner les choses en restant bref plutôt que tu balances un peu agressivement 20 lignes d’explications pas du tout vulgarisées et que je peux trouver sur wikipedia en un clic si le sujet m’intéresse en plus sans tenir compte de l’ensemble du papier ni de la démarche globale de Pierre.

Je suppose que ton intervention un peu maladroite n’avait nullement pour but d’étaler tes connaissances ou mettre Pierre dans l’embarras mais bien de prêcher pour une vulgarisation qui reste la plus rigoureuse possible, alors tout de même merci :)

Enfin, si ce que dit semiaccurate est vrai (et c’est un très long papier dont, en plus, seule la moitié est accessible aux non-adhérents), on est pas près d’en voir des Tegra 4 ou 4i dans les tablettes ou téléphones.

En plus, il y a 2/3 ans de recul sur les pratiques NVidia pour rendre leurs infos plus crédibles.

Par contre vu comme semiaccurate dézingue littéralement NVidia, si c’est faux ils vont perdre toute crédibilité et risque même des actions juridiques.

En tout cas, ce qui est vrai, c’est que le Tegra 4 n’est pas là et qu’il n’y a pas (de même qu’au CES) d’annonce de produit sous cette plateforme (pas de ‘design wins’).

Sans savoir du tout les rumeurs qui courraient à leur sujet, je trouvais bizarre qu’ils annoncent leur Project Shield et avait proposé comme explication que, justement, leur carnet de commandes ne devaient pas etre bien garni.

Enfin, on verra.

@Rototo91: Le proc n’est pas tant responsable de tant que ça de la conso, en moyenne (hors jeux, et encore). J’ai du mal a valider des chiffres, mais en gros c’est 20% le proc, 50% l’écran et 30% le reste (radios) en tout cas en 3G, en 4G les radios c’est plus.

La morale de la morale, c’est que meme quand le proc baisse de 50% en conso, on gagne 1h, ca double pas l’autonomie. C’est pour ca aussi que beaucoup de fabricants sont un peu chiches sur la luminosité max de l’écran: ils pensent qu’on leur reprochera moins un écran qu’il faut mettre a l’ombre, q’un telephone qui lache en milieu d’aprem.

Quand a l’allumé qui nous ressort la page sur les techs des fabs, effectivement il est hors sujet, et en plus il a du oublier de lire la deuxieme page, les process LP (low power) ne sont pas du tout du pipeau, mais des process optimisés pour basse tension = basse conso = basses perfs, par opposition aux autres. En plsu il part sur un malentendu: « leur tech HKMG » ne veut pas plus dire que seul TSMC l’a que « ma Twingo » ne veut dire que perosnne d’autre n’a de twingo. Je peux expliquer avec des pizzas aussi !

@A: J’ai failli sauter par la fenêtre (du premier, ca va encore) quand j’ai vu les 0 tablettes annoncées au CES. J’avais vendu ma Xoom juste avant Noel pour me ruer sur une nouveauté… Du coup j’ai du me rabattre sur un Note 10.1 qui est tres bien mais que je regrette deja un peu (c’est petit, 10″ ! et la reco d’ecriture, ca fait kikoo, mais c’est toujours moins bon que le clavier)

A mon avis il doit y avoir un probleme de dispo des nouveaux procs (mis en prio dans les téléphones qui sont plus rémunérateurs ?), peut-être de stocks existants (je ne sais pas si les ventes de tablettes Android de marque on été bonnes ou pas a Noel, j’ai l’impression que c’est surtout le no-name minable qui a fait un carton, parceque LES GENS N’ECOUTENT PAS ASSEZ PIERRE ^^), voire d’attentisme (Android 5.0 en juin, de tête) et de timing (autant sortir une tablette pour la rentrée ou pour Noel, parceque la sortir pour le ski, c’est pas porteur)

@Bertrand: J’adore tes explications/précisions, j’ai tout compris…ou pas !!

@minette: J’ai l’impression que les joujous informatiques ont pris la place des mobylettes de ma jeunesse pour servir aux jeunes adultes a prouver leur roxxitude: on mesure les perfs, on kitte le machin (pardon, on met des ROMs customs). En pratique effectivement, je n’ai pas aucun retour de personne (et j’ai distribué 7 tablettes) sur le thème « c’est lent ». Contrairement aux PC par exemple.

Les plaintes que j’ai c’est sur le son pas assez fort, le wifi qui accroche mal, et la batterie qui tient pas assez longtemps. Et en été sur l’écran inutilisable au bord de la piscine. Ah, et le wifi qui marche pas quand on est pas a la maison… Si un opérateur sort un bon forfait occasionnel pour tablette, et que le surcout pour les tablettes 3G baisse, ca devrait faire un carton.

@obarthelemy:

S’il y a peu de nouvelles tablettes Android c’est surtout car il n’y a pas de nouvelles puces (donc peu d’intéret de faire du réchauffé) et que les RT et W8, elles sont bien là.

Mais Acer, Asus, Samsung ont bien annoncé ou sont sur le point de le faire des nouvelles tablettes. HP a même dit qu’ils allaient entrer le marché Android.

Aussi, s’il s’avère qu’il y a moins d’OEMs sur le marché Android c’est, en tout cas pour l’instant et tant que les Nexus et Fire sont à ces prix, ce n’est pas très grave.

Et, encore une fois, la N7 aurait de toute manière vu le jour sous le nom Memo. Donc, ce n’est pas la faute à Google si certaines OEMs préfèrent ne pas se creuser la tête à sortir des machines qui sortent un peu de l’ordinaire.

De toute manière, à part Asus et ses Transformers, c’étaient toues les memes les tablettes et elles étaient 2 fois plus chères que maintenant pour moins bien.

Google n’y sera donc pour pas grand chose SI le marché des tablettes Android vient à stagner. La concurrence c’est bien quand elle apporte quelque chose comme une baisse des prix et/ou des innovations, autrement ça ne sert à rien si ce n’est innondé le marché avec des clones surfacturés.

@A:

LOL, désolé, mon com c’est quasimment du HS, je me pensais sur la thread de l’iWOW.

[…] pour 367 millions de dollars Rachat qui commence a porter ses fruits avec les annonces du type Tegra 4i d’hier qui embarque une puce de ce type. On sait que Nvidia a perdu des marchés en […]

petite faute de frappe ici Pierre tu a mis « d’une » au lieux de « d’un »dans cette phrase

» La technologie Chimera par exemple pour gérer le rendu HDR d’une film en temps réel sera de la partie. »

ps: Merci pour ce blog!!!

@Dadoo: Les Mali, 400 et +, sont fait par ARM qui ne vend que des licences pour que d’autres les fabrique ou les fasses fabriquer.

Juste au dessus du 400 (MP4 pour 4 coeurs) il y a les 450 et T604, 624, 628 et 678. Effectivement c’est pas mal puisque dans un test d’OnpenCL la Nexus10, qui a du T604, fait mieux que TOUS les Intel : http://clbenchmark.com/result.jsp?test=CLB40403 (décocher AMD et NVIDIA). Malgré que Pierre parle de potager à ce sujet, les tests montrent qu’ARM fait du boulot avec une conso minime.

[…] Aujourd’hui, sans un travail de recherche et développement autour des technologies d’Icera et, à terme, la volonté d’une revente, il semble improbable que la marque se déploie à […]