On en parlait en Décembre dernier, les GeForce MX250 sont désormais officiels avec, comme pour les MX150, deux versions différentes aux consommations et performances différentes.

Rien de vraiment révolutionnaire pour ces MX250 par rapport aux MX150. Il s’agit presque du même circuit lancé il y a maintenant 2 ans par Nvidia mais ici légèrement optimisé pour atteindre des fréquences un peu plus hautes.

Nvidia garanti des performances 3D jusqu’à 3.5 fois plus importantes qu’un circuit Intel UHD620 sur un Intel-8265U. La solution emploie de la GDDR5 dédiée1, prend en charge l’Optimus de la marque et assure une compatibilité DirectX 12. Vulcan 1.1, OpenGL 4.6 et OpenCL 1.2 sont également à son CV

On retrouve deux références distinctes :

- Le GeForce MX250 1D52 qui affiche 25 watts de TDP.

- Le GeForce MX250 1D13 qui affiche 10 watts de TDP.

Comme pour la première génération donc, on regrettera que Nvidia ait choisi des appellations identiques pour des puces différentes. Les MX250 1D52 seront plus rapides et plus gourmands en ressources que les MX250 1D13. Si les constructeurs ne font qu’indiquer MX250 le consommateur ne saura pas trop ce qu’il achètera. On imagine que les modèles 25 watts de TDP seront plutôt réservés aux machines de grandes taille. Cependant, rien ne semble avoir obligé les marques utilisant les MX150 à choisir un modèle plutôt qu’un autre par le passé. On peut donc imaginer des puces 25 watts dans des ultraportables très légers et des 10 watts dans des machines plus imposantes. La différence entre les deux puces n’est pourtant pas anecdotique. La MX250 25 watts de TDP sera 30% plus performante mais consommera également beaucoup plus. Il serait donc opportun d’indiquer clairement ces éléments d’une manière ou d’une autre. Nvidia aurait, par exemple, pu baptiser ses puces GeForce MX250 et GeForce MX255. L’acheteur final lui en aurait été fort reconnaissant. Le vendeur de PC peut être moins. Mais il faut savoir à qui on s’adresse.

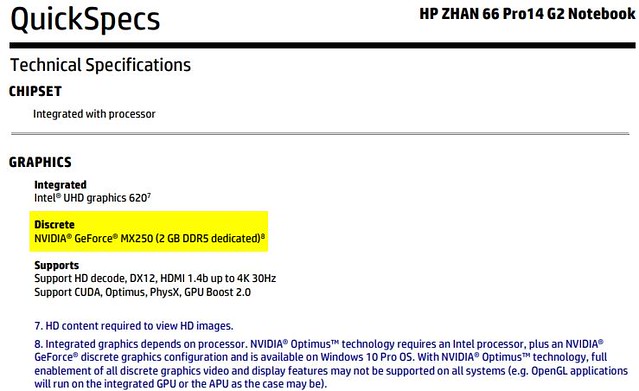

La fichetech d’une machine HP échappée en Décembre dernier

Le client aura donc tout intérêt à attendre des tests des engins pour savoir ce qu’il achète, à moins que, on peut toujours rêver, les fiches techniques aillent nous préciser qu’il s’agit d’une version 1D52 ou 1D13…

Les MX250 ne visent toujours pas, comme les MX150, un niveau de performances haut de gamme, il s’agit de booster un peu les capacités des solutions basiques en leur offrant des possibilités supplémentaires. L’ajout de cœurs CUDA aide, par exemple, à piloter certains programmes. Certains jeux peuvent également tirer profit de ces circuits même si ils resteront évidemment très légers. Il n’est pas question de tutoyer des titres récents en 3D avec de multiples effets graphiques et des hautes définitions avec ce type de puce.

De ce fait, le positionnement des MX250 est à considérer comme un bonus plus qu’un atout. Les usages classiques d’une solution graphique sont désormais pris en charge par les circuits graphiques Intel intégrés aux processeurs : Accélération 2D, prise en charge 3D légère et décompression vidéo UltraHD de qualité commencent à faire partie du package de base des solutions même les plus entrée de gamme chez Intel.

On peut d’ailleurs se demander si il y aura un MX350 un jour chez Nvidia ? L’arrivée des prochaines générations de puces Intel pourrait les rendre inutiles. Des produits comme les futurs processeur Elkhart Lake auront droit à un circuit graphique Intel Gen11 qui devrait rendre peu ou prou les mêmes services qu’un MX250 10 watts. Personne n’aura alors intérêt à intégrer la puce de Nvidia en doublon. A moins qu’un futur MX?50 gagne franchement en performances ou en services annexes.

Source : NotebookCheck

Notes :

| 2,5€ par mois | 5€ par mois | 10€ par mois | Le montant de votre choix |

Hello, question sur l’article, juste pour ma culture personnelle, dans le passage suivant :

« Ce qui est un vrai avantage par rapport aux solutions Intel intégrées qui aprtagent la mémoire vive embarquée dans l’engin »

je comprends que les puces Intel utilisent que la mémoire vive classique (les barrettes de RAM quoi) là où une solution MX250 n’utilise que sa propre mémoire dédiée en DDR5, est-ce correct ?

Merci beaucoup et bonne journée !

@prog-amateur: Tout à fait. Quand tu as un PC avec 4Go et un chipset graphique Intel, ce dernier bloque une partie de la mémoire vive pour son propre usage ce qui en fait moins pour le reste de la machine. Avec un chipset externe et sa mémoire dédiée, seule cette mémoire est prise en compte pour le chipset graphique. La mémoire générale du système reste pour le système. C’est un avantage certain.

25 W MX250 ‘1D13’

10 W MX250 ‘1D52’

;)

@Pierre Lecourt: Merci, c’est un argument très intéressant surtout que la DDR5 est annoncée comme bien plus rapide que la DDR4.

Concernant la remarque de@Prog-amateur:

Pensez-vous qu’un jour il puisse y avoir de la mémoire dédiée au GPU intégré au CPU? En externe ou en internere au CPU ?

Afin de profiter en plein de :

– toute la mémoire RAM, surtout quand il n’y a que 4Go de RAM

– La vitesse des GPU plus rapide

Merci

@Bzels: ça existe déjà avec la gamme Iris Pro chez intel avec 128 Mo ou 64 Mo (oui bien méga !) de mémoire avec un bus 512 bits.

Mais cela a un coût de graver ensemble sur le même die, le cpu, le gpu et la ram, d’où le peu de disponibilité et ces puces.

@Bzels: Oui tu as ça avec les Intel Kaby Lake G et les chipsets vidéo AMD via HBM : https://www.minimachines.net/actu/intel-kaby-lake-g-57973

Si ce genre de carte est inutile sur le marché mobile face aux solutions stoney ridge/zen g, elles le restent face à Intel en tout cas au moins jusqu’à l’arrivée des prochains iGPU Intel et c’est aux côtés de processeurs Intel qu’elles seront de toute manière.

C’est plus puissant que ce qu’on retrouvé dans la NVIDIA Shield ?

@Pierre: j’ai une question, est ce que ce genre de puce est là pour prendre des parts de marcher (ou ne pas trop en perdre) face au APU AMD qui vont se retrouver intégrés avec les CPU intel ainsi qu’aux nouveaux chipsets graphique intel? Car pour beaucoup de monde, une carte graph dédiée sera toujours plus puissante qu’un APU… même si en réalité pas forcement.

Et autre question: le gain de puissance face à la solution UHD620 d’intel, est de 30%. Mais quelle est la part qui vient uniquement de l’utilisation de la DDR5 pour ce gain, car les chipset intel se retrouvent « bloqués » le plus souvent avec de la DDR3 ou au mieux de la DDR4 ? Parce que 30% c’est pas négligeable (même si un pourcentage comme ça veut pas dire grand chose), mais compte tenu que ces GPU ont leur propre mémoire, bien plus efficace qui plus est, ça me parait absolument pas spectaculaire.

@Neuro: Il y a une demande à la fois du public et des constructeurs, Nvidia y répond.

Disons que c’est différent. Les avantages liés à Pascal et à CUDA sont intéressants. Il faut également comprendre quelles différences réelles il y a entre les puces et si ces 30% sont le fait d’un avantage unique sur quelques jeux par exemple.

En pratique je trouve le MX150 pas désagréable pour certains usages. Mais rien d’insurmontable pour le circuit Intel intégré non plus, ptet un peu plus de framerate dans les jeux 3D légers mais ça ne change pas grand chose au final.

@Pierre: Merci beaucoup pour ta réponse. Oui, j’ai manipulé une MX150, et j’ai été surpris de lancer un GTAV plutôt fluide et jouable (certes avec des settings bas et du 720p). C’est loins d’être un mauvais chipset, ou plutôt l’entrée de gamme a fait de gros progrès. Après, quand on est autour des 30 fps, les 5 frames en plus ont beaucoup plus d’impacte que quand on est autour de 60 ou 70. ;-)

« On peut donc imaginer des puces 25 watts dans des ultraportables très légers et des 10 watts dans des machines plus imposantes »

Inversion de chiffres ?

@Ptit_Philou: nope : faut lire la phrase du dessus :

« Cependant, rien ne semble avoir obligé les marques utilisant les MX150 à choisir un modèle plutôt qu’un autre par le passé. On peut donc imaginer des puces 25 watts dans des ultraportables très légers et des 10 watts dans des machines plus imposantes. »

Le constructeur peut très bien choisir une solution illogique et on a vu des 15.6″ premier prix avec des MX150 de base. Ce qui aurait du encourager Nvidia a choisir 2 dénominations différentes : MX250 et MX255 par exemple.

Exact… :-)

@Pierre Lecourt:

@Pierre: penses-tu que c’est les fabricants qui mettent la pression sur Nvidia pour ne pas être clair?

Car cette histoire dur depuis le MX150

Et à la même époque Nvidia choisissait de ne pas mettre un M aux GPU embarqués dans les PC de gamer ex:

Nvidia GTX 960M c’est transformé en

Nvidia GTX 1060 alors que clairement ce n’est pas au même niveau qu’un GPU de desktop…

Juste une économie de nom/model ? Flemme ? Ou entretenir le flou?

Effectivement Nvidia gagnerait à être plus transparent car cela induit une sensation de tromperie prompt a aller voir du côté d’AMD qui est beaucoup plus clair en terme de nommage

@Bzels: Je ne sais pas répondre à cette question malheureusement.