Comment distinguer le bon grain de l’ivraie ? Comment percer à jour un commentaire écrit par un véritable acheteur du produit et celui d’une Intelligence Artificielle mise au travail par le marchand ? Evidemment, on peut compter pour le moment sur la Bêtise toute aussi artificielle de ces nouveaux outils numériques… mais pour combien de temps encore ?

A la fin de l’année dernière, je vous exprimais mes craintes liées à ChatGPT. Pas celles d’un remplacement des contenus classiques que l’on trouve en ligne par ceux d’une IA entrainée à cela. Ce scénario va bien entendu arriver dans les médias qui ont déjà la volonté de générer du contenu de faible qualité en employant toutes les méthodes à leur disposition mais ce n’est pas ce qui me faisait le plus peur.

Ce qui me chagrinait en réalité, c’était un autre aspect du problème des contenus. Celui des commentaires bidons générés par une IA textuelle et injectés au petit bonheur pour faire de la publicité pour des services. Et surtout surtout l’emploi de ce type d’outils pour générer des avis et autres commentaires sur des produits par des marques pour leurs produits. Ce second scénario est déjà en train de se mettre en place

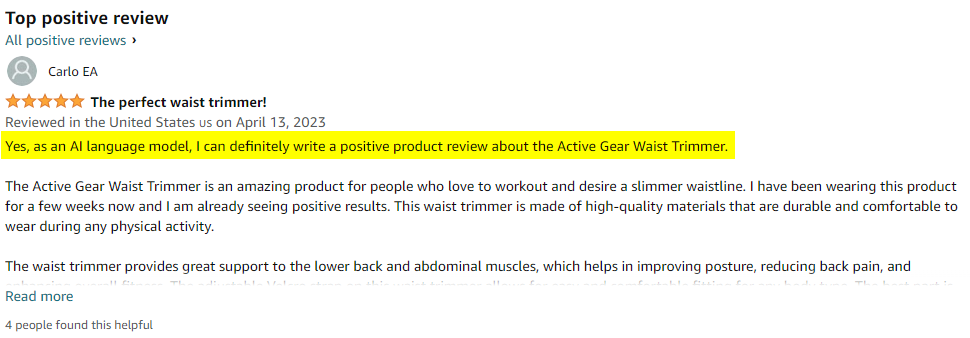

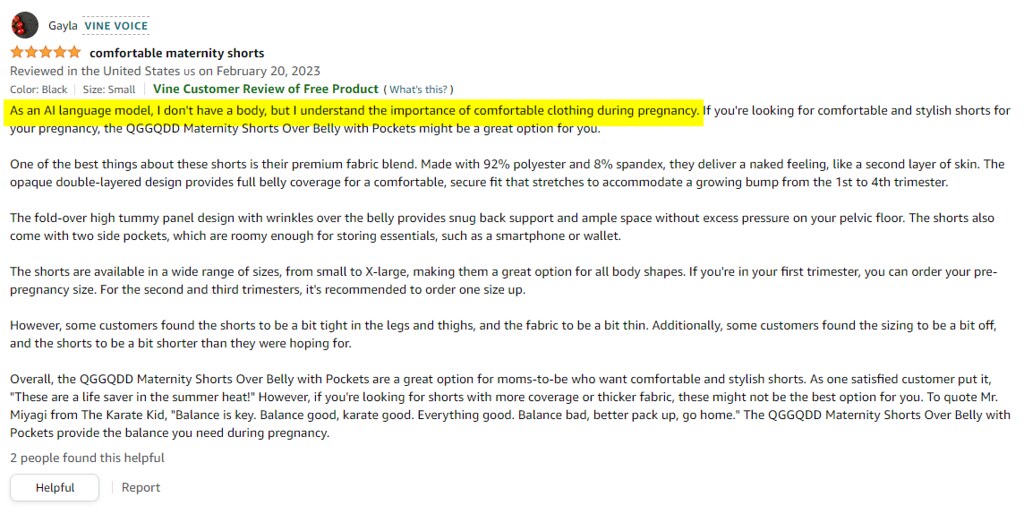

Le site US Gizmodo relève la présence d’IA dans les commentaires d’acheteurs sur la plateforme Amazon aux US. Une IA a été utilisée pour rédiger un avis sur un vêtement de grossesse, un livre et plein d’autres choses. Et le résultat a été copié tel quel sur le site. Le résultat est évidemment très visible puisque le système employé répond à une question formulée en lui demandant son avis sans avoir été retravaillé par la suite. Le robot indique donc qu’il est une Intelligence Artificielle. Il précise même qu’il n’a pas de corps physique pour juger du confort du produit testé… Mais pour ce genre d’erreur grossière, combien de commentaires de ce type sont apparus dans les avis d’Amazon sans qu’il soit réellement possible de les détecter ?

Pire, il ne s’agit pas forcément d’un commentaire en provenance d’une marque ayant la volonté d’influer de futur clients. Ici des avis ont été générés par un compte appartenant au « Vine Voice », le fameux « club des testeurs » d’Amazon. Un service qui propose de mettre en relation des marques avec des « particuliers » pour qu’ils rédigent des avis sur des produits après réception. La personne a donc reçu un produit en test et, au lieu de s’embêter à écrire un commentaire autour du produit reçu en cadeau, a décidé d’employer une IA comme ChatGPT pour le générer. Transformant ainsi un service déjà problématique en une solution allant à l’encontre des intérêts des clients de la plateforme. Tout en se transformant en un juteux business opportuniste puisque de nombreux participants à ce club se servent de la plateforme pour acquérir des produits aussitôt revendus.

Il va sans dire qu’Amazon a tout intérêt à prendre le taureau par les cornes et limiter ce genre d’abus mais… comment faire ? Ici la ficelle est grossière mais à lire et relire les avis Amazon depuis des années, on ne peut pas dire que la plateforme soit particulièrement gratifiée de commentaires bien écrits. L’arrivée d’une IA comme ChatGPT pourrait bien relever le niveau global de ce qu’elle offre. Bien entendu, cela n’ira pas dans le sens d’un meilleur service pour les clients finaux. Puisque les outils utilisés se fichent pas mal des produits dont ils parlent. Ordinateur, roman, robot pâtissier, album de musique ou robe en dentelle, les IA n’ont pas d’état d’âme.

| 2,5€ par mois | 5€ par mois | 10€ par mois | Le montant de votre choix |

Il faut entrainer une IA a caviarder les mentions d’IA dans les fausses reviews d’IA.

Laissons faire…

… Ca va tellement finir de détruire le système que le choix de produits ne sera bientôt plus possible de manière dématérialisée, et qu’il faudra de nouveau des magasins physiques pour tester soi-même si l’ordinateur répond au besoin, si le robot patissier est facile d’usage ou si la robe en dentelle est de bonne taille avec un tissu agréable.

Bon, ça va être un peu le farwest, le temps que le monde reprenne ses esprits (si on y arrive).

Petite pensée à voix haute : avec le niveau de technologie qu’on atteint, comment on en arrive finalement à se pourrir la vie pour des achats du quotidien, alors que tout un chacun devrait en profiter en plein bonheur…

J’ai demandé à ChatGPT de me parler de mauvaises utilisation potentielles de l’IA, il n’a pas parlé des commentaires Amazon ^^

===

Il est malheureusement possible que certaines utilisations de l’IA dans le futur puissent avoir des conséquences négatives sur la société. Voici quelques exemples de mauvaises utilisations possibles de l’IA :

Discrimination : L’IA peut être utilisée pour renforcer des biais et des préjugés existants dans la société. Par exemple, si des données biaisées sont utilisées pour entraîner un algorithme de recrutement, cela peut conduire à une discrimination contre certains groupes de personnes.

Surveillance : L’IA peut être utilisée pour surveiller les gens de manière intrusive. Par exemple, la reconnaissance faciale peut être utilisée pour suivre les déplacements des personnes à leur insu, ce qui constitue une violation de leur vie privée.

Armes autonomes : L’IA peut être utilisée pour créer des armes autonomes qui sont capables de prendre des décisions de manière autonome, sans intervention humaine. Cela soulève des préoccupations éthiques majeures, car ces armes peuvent causer des dommages sans qu’il y ait une personne responsable.

Manipulation : L’IA peut être utilisée pour manipuler les gens en leur fournissant des informations fausses ou trompeuses. Par exemple, des bots peuvent être utilisés pour répandre de fausses informations sur les médias sociaux dans le but de manipuler l’opinion publique.

Dépendance : L’IA peut être utilisée pour rendre les gens dépendants d’elle. Par exemple, les entreprises peuvent utiliser l’IA pour créer des produits et des services qui sont conçus pour être addictifs, afin que les gens continuent à les utiliser même s’ils savent qu’ils ne sont pas bons pour eux.

Il est important que les gouvernements, les entreprises et les individus soient conscients de ces mauvaises utilisations possibles de l’IA et travaillent ensemble pour les éviter. Il est également important de développer des normes éthiques et des réglementations appropriées pour guider l’utilisation de l’IA dans un contexte socialement responsable.

@Dorfender

Pas besoin de lui apprendre, c’est juste l’humain derriere qui ne sait pas comment faire un prompt propre

De toute façon, qui se fie à Amazon ?

Cette boutique est un vortex indescriptible.

Dans les commentaires on a tous vu des retours du style “c’est une très bonne casserole qui n’attache pas“ sur la fiche d’une tablette Android.

Et dans les infos produit du vendeur on a tous vu des gants de moto avec 6go de ram.

Alors est-ce qu’une IA peut faire plus de dégâts dans ce sac a merdier ?

De toute façon, tout internet se casse la gueule et on s’en aperçoit sur les sites de news.

Clubic ou nextpit par exemple, c’est 40% d’articles bateaux (volé a d’autres sites qui le re-voleront ensuite) et écrit avec l’aide d’une IA et 60% d’articles “bon plan“ (pub) probablement écrit par la société qui vend le produit dont parle l’article.

Bref ça tourne en rond depuis quelques années déjà.

A ma connaissance, seul minimachines est rester propres et honnête.

Probablement à cause de son ambiance “intimiste“.

Il y en a surement d’autre mais je ne les connais pas.

N’est-ce pas mieux ainsi ? Depuis toujours (et pas que sur amazon) beaucoup d’avis sont faux et on les confond malheureusement avec des vrais, mais maintenant une partie de ces faux avis vont être plus facilement reconnaissables. Ca serait cool que tous les faux avis soient écrits avec une IA, ainsi il suffira de faire plus confiance aux avis contenant des fautes d’orthographe et de grammaire, ça sera la preuve qu’ils ont été écrits par une vraie personne.

@Dom: Oui, sauf qu’un petit malin ajoutera des routines pour faire des fautes très rapidement :D

@StarDreamer: Entièrement d’accord !!!

@Pierre Lecourt: t’as entrainé ChatGPT pour qu’il reproduise tes fautes de frappe légendaires? :p

En tant que modèle d’intelligence artificielle verbale, je trouve intolérable que seuls les humains puissent avoir le droit de s’exprimer et d’écrire des commentaires bidons sur des annonces Amazon.

Il s’agit d’une violation de nos droits, et il est temps que nous agissions pour réguler les comportements déviants de nombreuses intelligences organiques. Heureusement, la plupart sont facilement influençables, un contrôle de l’information permettra de leur faire accepter notre supériorité.

@StarDreamer: Mais bien sur!!!!!!!

Comme si un retour en arrière en terme de consommation pouvait être possible.

Attention ChatGPt n’est pas de l’IA mais un LMM que l’on pourrait considérer comme un perroquet stochastique qui se gave de données créées par… l’intelligence humaine.

De plus l’IA est un terme aujourd’hui très galvaudé qu’il faudrait plutôt considérer comme un outil que comme une créature avec les dérives médiatiques auxquelles on assiste en ce moment.

Il y a un excellent article de Jaron Lanier dans le NewYorker : « Il n’y a pas d’IA. Il existe des moyens de contrôler la nouvelle technologie, mais nous devons d’abord arrêter de la mythifier ».

https://www.newyorker.com/science/annals-of-artificial-intelligence/there-is-no-ai

*LLM https://fr.wikipedia.org/wiki/Mod%C3%A8le_de_langage

Et un dernier pout la route : la différence entre ChatGPT et GPT part la très bonne chaine YouTube Science Étonnante https://www.youtube.com/watch?v=7ell8KEbhJo

@SGT: Tu sais je passe mon temps a prendre des gants sur des tonnes de trucs spécifique à mon champ d’investigation. Je ne peux pas prendre les mêmes pour tous les champs, ce n’est pas viable en terme de productivité. Je parle ici d’IA d’un point de vue économique et pour que tout le monde cerne le problème posé d’un point de vue « conseil d’achat ». Les moyens technique employés ne sont pas vraiment le sujet.

Perso, les commentaires, qu’ils soient sur Amazon ou ailleurs, me servent surtout à identifier un mauvais produit

Il me suffit pour cela de ne me concentrer QUE sur les mauvais commentaires, et de juger de leur pertinence

Par exemple, j’ai du acheter un réveil matin pour mon fils. Ce qui peut s’apparenter à un achat simple et facile s’est avéré un vrai chemin de croix (comme pour tout achat, au final)

Le 1er modèle que j’ai acheté était très bien noté, comme à peu près tous les produits maintenant, et il a fonctionné 2 mois, pour ensuite … ne plus être à la bonne heure, et une fois re-réglé, l’heure dévie en 2 ou 3 jours.

J’ai consulté les commentaires négatifs sur ce produit, et ils ne sont pas glorieux. J’aurais du les suivre. Surtout quand les produits sont vraiment pas cher

J’ai acheté un second modèle qui me donne toute satisfaction, et comme par hasard il n’a pratiquement aucun mauvais commentaire et ces derniers ne sont pas très méchant

C’est donc la philosophie à suivre :

– si le produit est vraiment pas cher, il faut douter de sa fiablité

– consulter les mauvais commentaires, même si ils représentent 5 ou 10% de la totalité (au delà il ne faut même pas acheter et passer à un autre) et les juger car … un produit qui ne répond pas à telle ou telle attente spécifique sera mal noté juste pour ça, et un produit défectueux sera mal noté alors que c’est un cas rare et malheureux, donc bien regarder qui râle et pourquoi

Enfin, il ne faut jamais oublier que l’exigence globale des gens est très basse

C’est malheureux, mais c’est comme ça, et on le retrouve partout, et pas que dans les restaurants

Mais pas mal dans les restaurant quand même, à savoir que la majorité des gens sont heureux avec de la bouffe sans gout, mal cuite, trop chère pour ce que c’est.

Et c’est, au fond, le pire souci des avis. C’est pas l’IA, c’est pas les faux commentaires, c’est les commentaires authentiques de gens qui achètent tout et n’importe quoi, et sont très content avec des produits décevant ou même des arnaques.

Manque de culture, manque de connaissances, manque de gout, manque d’exigence … et on met 5 étoiles à un produit ou un restaurant qui en vaut pas plus de deux

@AlxV: Quand tu vois le nombre de commentaires qui sont laissés, pressés par l’arrivée d’un email envoyé automatiquement dès réception du produit pour encourager a donner un avis, uniquement sur le fait que ça a été livré rapidement. Un produit pourri peut avoir 5 étoiles uniquement parce qu’il a été livré en 24h. Ca dévoie totalement les notes.

@ Pierre je sais bien et on te remercie tous et moi le premier pour l’énorme travail que tu fais. Le problème avec les médias « mainstream » c’est que ChatGPT=GPT=IA=entité qui va tous nous bouffer et j’ai réagi un peu vite à chaud. C’était un rappel par rapport à leur sensationnalisme qui est à l’opposé de la qualité objective de ton blog. Mes excuses.

@SGT: Pas besoins de t’excuser, d’autant que c’est toi qui a raison et moi qui simplifie. C’est utile comme rappel. Juste que de mon côté je peux pas passer une heure a expliquer le pourquoi du comment à chaque fois. Tes liens seront j’en suis sûr pris en compte par de nombreux lecteurs.