Il n’y a rien de plus simple que de lancer un benchmark. Vous savez, ces logiciels de test qui vont exécuter des actions spécifiques, calculer en combien de temps chaque machine les exécute et dans quelles conditions elle y parvient. Un savant et ésotérique calcul effectué avant de vous donner un résultat sous la forme d’un chiffre brut.

Rien de plus simple car sous la bonne excuse d’une méthode « impartiale », le benchmark permet de ne pas avoir a réfléchir sur les usages possibles d’une machine. On lance le programme, il sort un chiffre, on le glisse ensuite dans un tableau. Et on peut ainsi dire que sous tel protocole de test, cette machine s’avère plus ou moins performante que telle ou telle autre. C’est utile, je ne dis pas, mais cela cache souvent d’autres problématiques.

L »excellent travail de synthèse de NotebookCheck n’a pas besoin d’être répété à l’infini

La première est que le top du classement d’un benchmark l’année X peut apparaitre en queue de peloton deux ou trois ans plus tard. Non pas parce que le produit est devenu mauvais. Il remplit toujours parfaitement son rôle, mais parce que les nouvelles propositions sont simplement meilleures. Reléguant en arrière plan une machine toujours parfaitement efficace. Est-ce que cela changera l’usage de l’engin testé ? Pas du tout. Il remplira toujours aussi bien sa tâche. Mais en 2, 3 ou 5 ans, il sera parfois jugé comme obsolète par un outil qui n’a aucune perspective sur l’utilisation des engins qu’il analyse.

La seconde vient du fait que les benchmarks sont rarement mis en scène de manière censée. On teste des engins en vrac et on les assemble dans un panneau absolument pas fairplay pour les concurrents. Comparer un MiniPC entrée de gamme avec une station portable haut de gamme n’a aucun sens. Personne n’aurait l’idée de comparer une barque avec un yacht. C’est pourtant ce que proposent souvent les benchmarks les plus connus en se focalisant uniquement sur les performances brutes et en proposant pèle mêle des solutions sans aucun rapport entre elles dans un tableau. Ces outils prennent comme point de repère les meilleures solutions du marché sans penser au prix, à l’encombrement, au bruit ou à la consommation de celles-ci.

Car c’est ce que ne voient pas ces tests. Les acheteurs ne viennent pas choisir en fonction d’une note mais pour répondre à un besoin et un budget. Il y a bien entendu un intérêt à situer un ordinateur face à d’autres et à comparer des engins de même calibre. Cela peut avoir du sens. Mais c’est malheureusement souvent peu lisible. Mettre en scène au travers d’une série de benchmarks des engins de même stature n’a que peu d’intérêt. Si on teste des machines dans les mêmes plages de tarif et ayant le même objectif, on se rend vite compte que les équipements proposés et les prix sont les mêmes. Les constructeurs de PC piochent dans des catalogues de composants identiques et les résultats sont le reflet de cette gémellité technique. Un portable X avec une puce donnée, un certain montant de mémoire vive et un stockage rapide embarquant le même système d’exploitation aura le même niveau de note qu’un portable Y équipé de la même manière. Certaines fois, il peut y avoir une baisse sensible des performances à cause d’un défaut de la machine testée mais sans une explication technique détaillée, la note proposée par le Benchmark n’illustrera en rien le pourquoi de ce résultat. Un constructeur faisant un mauvais choix de ventilation par exemple ne sera pas compréhensible dans un tableau de résultats. Le pourquoi sera alors mis en avant dans le texte décrivant la machine.

Autrement dit : Soit le Benchmark comparera des engins quasiment équivalents en performances à budget égal, soit il faudra aller fouiller le texte pour comprendre pourquoi ce n’est pas le cas.

Comme cela n’est pas très spectaculaire dans un test de proposer un graphique où les notes sont finalement les mêmes à quelques points les une des autres, le test est souvent accompagné d’autres processeurs. Pour y voir « plus clair ». Car pour comparer des produits de même catégorie, les Benchmarks ne sont pas très parlants. Il faut comparer des machines incomparables pour que cela ait un impact visuel. Cela pousse à une vision assez fausse de ce que l’on teste. Car on peut très bien avoir en main un engin très capable techniquement parlant mais qui apparaitra tout en bas d’un tableau de résultats. De telle sorte que volontairement ou non, l’image que l’on présente du produit peut apparaitre comme floue, si on teste des produits identiques, ou fausse, si on teste des produits de catégories différentes.

Quelqu’un qui a un budget de 1000€ pour acheter un portable ne s’intéresse pas à ce que les machines à 2500€ peuvent faire. Toute personne qui cherche une machine pour faire du montage vidéo espérera plutôt voir si un PC est capable de couvrir 100% de ses besoins particuliers.

Les tests et Benchmarks sont utiles.

Bien sûr, des tests sont utiles, voire véritablement précieux. Connaitre les performances réelles de tel processeur, de telle puce graphique est utile. Comprendre pourquoi telle formule a absolument besoin d’une mémoire de tel type alors qu’une autre peut s’en passer est indispensable. Savoir si la solution réseau ou le stockage embarqué sont adaptés et efficaces est important. Lancer un test des capacités de refroidissement proposées à un processeur reste tout aussi pertinent. Mais ces tests ont du sens parce qu’ils se réfèrent uniquement à ce que propose chaque machine sans le comparer à des engins sans aucun rapport. Parce que noter la vitesse de stockage d’un engin à 150€ par rapport à un autre dix fois plus cher pour en souligner la faiblesse n’a finalement que peu d’intérêt. Par contre, indiquer pourquoi un portable propose une meilleure autonomie qu’un autre machine de même calibre, positionné sur le même segment tarifaire, peut être très intéressant à signaler. Tout comme il sera particulièrement intéressant de pousser l’examen particulier d’un poste par un test plus précis. Noter que telle machine ne fait pas de bruit par rapport à une ou plusieurs autre dotées du même processeur et assortir cela d’un test de performance pour montrer que cela est bien dû à un travail sur le refroidissement et non pas une baisse des performances. Cela reste un constat précieux.

Un méli mélo de puces incomparables

Le vrai souci pour moi avec ces Benchmarks, c’est qu’ils sont devenus l’Alpha et l’Omega des tests. C’est compréhensible car prendre en main un produit est devenu un investissement important. C’est paradoxalement aussi simple que chronophage. Passer par une série de tests permet de situer facilement la machine, surtout que l’on peut mener ces tests en batterie, sans être devant les ordinateurs testés, en lançant un ensemble programmé de procédures et en notant les résultats obtenus. C’est facile à mettre en place ou à déléguer à un indépendant ce qui est finalement assez rentable. Cela permet également de se donner un avis pétri d’une sorte de vernis « scientifique » grâce aux différents chiffres proposés. Des chiffres que l’on peut qualifier d’impartiaux même si on sait que cela n’est pas forcément vrai.

Mais au final, le constat de la note obtenue en agrégeant les tests est souvent vain. Parce qu’il ne renseigne pas réellement sur le meilleur choix. Est-ce qu’un portable avec 1000 points à un ensemble de tests mais vendu 1500€ sera plus intéressant qu’un portable qui n’aurait que 980 points mais vendu 1200€ ? Et si un troisième portable propose 950 points, qu’il est proposé à 1500€, mais qu’il fonctionne de manière absolument silencieuse ? Qui sera le plus pertinent ?

Le fait de n’établir une note qu’au travers d’un logiciel tiers dont on ne connait ni les méthodes réelles ni les rouages de calcul me parait finalement fort peu pertinent. J’ai de plus en plus l’impression de croiser des avis sur des machines qui sont forgés en aval d’une note établie par une session de Benchmarks. Comme si on écrivait l’histoire à partir de la note au lieu d’écrire les impressions laissées par la machine testée. Avec le défaut récurrent que lorsque la note s’éloigne trop du peloton de tête l’engin est alors classé comme peu pertinent ou pire, inefficace. Et cela sans considération de son usage, de son prix ou du reste de son équipement.

Quelle alternative aux Benchmarks ?

Je suis persuadé que dans la vie de tous les jours les benchmarks n’ont que peu d’intérêt. Savoir qu’une machine offre 50, 100 ou 150 points de plus ou de moins à un test lambda qui le mesure une note sur 20 000 ponts n’éclaire pas vraiment l’acheteur. Connaitre la réaction d’un ensemble de programmes précis pour un usage déterminé est autrement plus parlant. Si ce résultat sera moins précis d’un point de vue absolument technique, il pourra éclairer parfaitement l’utilisateur dans son choix. Parce qu’il parlera son langage et répondre à sa question principale concernant ses usages.

J’ai donc décidé de créer une alternative à ces Benchmarks pour mes futurs tests. Le plus logique pour moi est de déterminer non pas le nombre d’images par seconde atteint dans tel ou tel jeu, la vitesse de calcul de tel ou tel test mais plutôt de proposer la couverture d’usages possibles pour chaque machine. Une échelle de référence qualifiant chaque utilisation de l’incompétent à un « usage pro » de l’engin. Cela permettra de voir qu’un MiniPC entrée de gamme permet déjà un usage professionnel de programmes bureautique. Et qu’il n’y a pas besoin de s’orienter vers une machine dix fois plus cher pour « faire sa compta ».

Savoir que tel PC est capable de « sortir » 21000 points à un test ne me parle pas. Savoir qu’il est en bas d’un podium de 100 autres machines avec des budgets et des consommations sans rapport n’est pas éclairant non plus. Mais avoir idée qu’un engin couvre 100% des usages web confortablement ou qu’il saura piloter convenablement des jeux en 2D ou en 3D l’est beaucoup plus. Un utilisateur qui recherchera une minimachine couvrant l’essentiel des usages de retouche photo saura ainsi qu’il peut choisir aussi bien un MiniPC à quelques centaines d’euros qu’une station dédiée à cet usage coutant beaucoup plus cher. Le fait qu’un PC montre qu’il couvre les besoins de l’utilisateur, de manière claire et lisible, permet à celui-ci de comprendre qu’au delà d’une note délivrée par un logiciel, la machine qu’il possède n’a pas forcément besoin d’être remplacée ou mise à jour. Même si son processeur se retrouve au bas d’un nouveau classement de benchmark.

Cette approche est pour moi beaucoup plus parlante, elle pousse moins à la dépense et reflète de vrais usages et non pas une quête de points dont on perd souvent l’objectif de vue en cours de route. Cela me parait d’autant plus utile que beaucoup de benchmarks sont déjà disponibles sur le web. Et que si un utilisateur veut s’y référer, il trouvera sa réponse sans difficulté en quelques clics sur la toile.

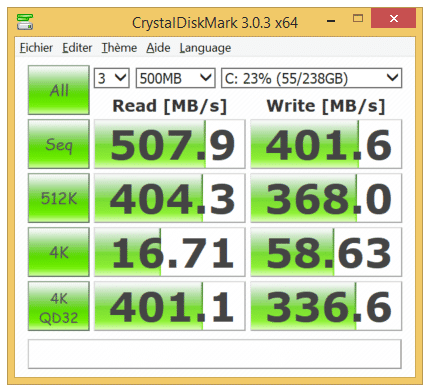

Je ne sais pas encore vraiment comment mettre en scène cette approche, j’essaye de trouver une solution très facilement lisible. Une manière graphique de voir d’un coup d’oeil si telle ou telle machine couvre les usages les plus fréquemment demandés. Cela ne m’empêchera pas parfois de lancer quelques tests pour être sûr de moi. Pour vérifier la validité de l’engin par rapport à des annonces du constructeur. Pour mesurer la validité de son refroidissement, la rapidité de son stockage ou de son module réseau par exemple. Mais pour moi il sera plus utile de traduire le résultat de ces tests en un graphique et quelques mots qu’en accumulant des dizaines de tableaux de notes illisibles ou difficilement interprétables sans contexte.

Des tests sur Minimachines ?

Oui, je sais, il n’y a pas beaucoup de tests sur le blog. Pour plein de bonnes et de mauvaises raisons. Mais cela va revenir très vite et c’est pour cela que je me devais de vous faire ce petit préambule. J’ai retrouvé un certain appétit pour tester des produits. J’ai certaines machines depuis des lustres qui attendent comme j’ai reçu des engins bien plus récents. Et j’ai bien envie de les passer au grill et de les présenter ici.

Je suis depuis toujours un peu gêné pour tester des produits qui ne m’enflamment pas. Je me suis longtemps demandé pourquoi un test comme celui du Transformer Book T100 semble couler de source pour moi, je l’écris quasiment d’une traite et sans peine. Alors que je me retrouve face à mille questions quand je dois tester un appareil qui me parle moins. Qui m’inspire moins. La réponse est finalement assez simple, ne sachant pas par quel bout le prendre, j’essaye de l’attraper avec des outils de test classiques. Et c’est souvent eux qui ne me parlent pas au final. Que raconter d’un MiniPC au travers de ces benchmarks ? Rien. Enfin, rien de plus que ce racontera le même Benchmark avec une autre minimachine équivalente. Le souci c’est que quand vous avez cinq ou dix engins avec exactement le même équipement, et parfois la même carte mère juste enrobée d’un boitier différent, comme sur le marché particulier des MiniPC, qu’avez vous encore à dire au bout du second PC ? Pour se focaliser sur les particularités de chaque machine et dépasser le stade du Benchmark, la solution d’une couverture des capacités globales de l’engin et de ses éventuels défauts me semble plus efficace que le détail précis apporté par des tests génériques.

A la rigueur il serait parfois plus utile de créer un suivi des capacités de certaines puces – comme l’Intel N100 ou le Ryzen 7 5700U massivement déployés sur de nombreux MiniPC. Dans des contenus indépendants des tests, régulièrement mis à jour et augmentés de nouvelles pratiques. Ce serait plus pertinent de vous indiquer ces prises en main généralistes sur des billets spécifiques plutôt que de ressasser encore et encore leurs capacités en boucle. Evidemment, cela n’empêchera pas de vérifier rigoureusement que les engins proposent bien ce qu’ils sont censés apporter. Mais pas forcément d’en faire la colonne vertébrale de ce qui vous sera proposé.

Des tests plus orientés usages, peut être moins complexes et plus lisibles, c’est ce que je vais essayer de proposer désormais.

| 2,5€ par mois | 5€ par mois | 10€ par mois | Le montant de votre choix |

Très bonne réflexion.

Les benchmarks, comme tout est à prendre avec du recul.

L’avantage de ceux que l’on connait c’est que c’est facile à réaliser et en série. Pour un protocole plus exotique vous allez le payer en temps, bon courage !

En fait les données qui sont généralement les plus intéressantes ne sont pas celle qui sont les plus mis en avant, en tout cas pour un portable :

– L’autonomie en fonction de différemment scénario

– Le bruit en fonction de ces scenarios

– Le prix/performance en fonction de ces différents scénarios

– La durée de vie la machine

Car effectivement avec de simple benchmark on peut se retrouver avec des résultats inutiles :

– Vaut-il mieux un pc portable capable d’avoir un énorme pic de puissance mais dont la puissance baisse très rapidement à cause de la surchauffe ou un pc totalement stable dans ses performances ?

– Vaut-il mieux un pc lent et économe ou rapide et gourmand ? Si l’objectif est de naviguer sur le web vaut il mieux un pc qui à 10h d’autonomie mais afffiche les pages web en 2 secondes ou un autre qui les affiches en 1 seconde et qui n’as que 5h ?

– Vaut-il mieux un pc qui embarque les toutes dernières technologies et pourra être mis à jour sous W12 ou au contraine un pc avec les drivers les plus universelles et tournera sous linux ?

Autant de question qui n’ont pas toujours de réponse dans les tests générés à la volée et écris par des IA

Pour ma part je suis passé chez framework PC pour ne plus me poser la question

Super initiative, je suis impatient d’avoir cet éclairage différent.

« une solution très facilement lisible »: avec un petit graphique de type araignée, ayant comme axe les différents usages (comme sur le labo fnac par ex: https://lab.fnac.com/compare/electricScooter ). Ce serait facile à lire pour nous :)

Concernant les « capacités de certaines puces – comme l’Intel N100 ou le Ryzen 7 5700U ». Il est déjà assez clair dans les articles qu’investir dans un N100 plus moderne et moins cher que l’ancienne génération vaut la peine. Mais c’est plus difficile de savoir s’il est utile pour un utilisateur existant d’un processeur de génération précédente (ex.

N5105/ J4125 ) si cela vaut la peine de sauter le pas, si la différence sera significative pour son usage, quel usage supplémentaire deviendrait disponible.

Et bien, hâte de voir ces tests!

Pour ma part, je pars souvent des benchmark pour trouver des machines d’occasions, gamme pro, équivalentes aux dernières machines entré/milieu de gamme, grand public.

Ensuite, je regarde, en détail, si elles peuvent répondre à mes usages, pour finir sur un achat souvent avantageux.

Dernier exemple, j’ai longtemps attendu la sortie d’une tablette x86 sous n100/n200, parfait pour mes usages (très peu de différences entre ces deux proc), il yen a eu mais les prix sont un peu excessifs, la surface go 4 étant a presque 800€…

J’ai fini par acquérir une tablette Dell latitude 5290 i5 8th pour moins de 180€, quasi idem en bench que peux l’être une go 4 mais surtout, mise a jour BIOS automatique sous Linux, ce qui a énormément d’importance pour moi, bien plus que les bench au final.

D’ailleurs, cela pourrait être intéressant, des test de machines pro d’occasion, non?

Bravo pour ton initiative, comme tout les anciens on sait que ce ne sont pas les chiffres qui sont le but des acheteurs et consommateurs mais uniquement ce que l’ont souhaite faire avec, et après le prix effectivement vient se greffer , c’est la philosophie minimachines que l’ont va retrouver avec tes tests merciiii pour ça ; par exemple jai put tester un pc noname portable a base de n100 et c’est vraiment impressionnant en terme de rapport qualité/ prix pour de la bureautique et du multimédia cela tourne vraiment bien sans consommer trop et pourtant on en trouve presque pas dans les grandes marques ..

Je les utilise souvent, uniquement car j’upgrade souvent mes machines petit à petit, et que c’est assez important de savoir si sa ram, son ssd, son gpu, son cpu… tourne comme prévu et s’il n’y a pas un pilote, un bios à maj ou un réglage, un réglage bios à faire.

C’est pour ça qu’on te lit depuis si longtemps Pierre.

Je pense a Jerry Pournelle, et peut-être de nos jours a Paul Thurott: ils ne font (faisaient) pas tant des tests que des retours d’expérience.. Un peu plus structuré, je trouve qu’Andrew Cunningham sur Ars Technica arrive a la fois à empathiser avec le produit, sa cible, et l’utilisateur lambda (alors que Ron Amadeo empathise avec son image dans le miroir).

Les tests quantifiés c’est bien, mais en pratique, j’en ai rien a fiche de +/-20% de perf, alors que j’ai été surpris par des batteries pas durables (sur du Xiaomi, tablettes et phone, j’imagine qu’un reviewer pro a les moyens de se renseigner sur les fournisseurs et leurs gammes, comme on le faisait a l’époque pour les condensateurs solides+japonais sur les CM), des HP vraiment pourris (Lenovo Pad série M, les P sont bien), et dans le sens positif par « Moto Ready For » (téléphone virtuel sur PC), Lenovo Battery Protect (maintient la batterie à 20-60%). Mentions de ses 4 trucs dans le 10aines de review que je lis chaque année ? 0 ! (bon, Ready For, parfois).

Encore plus basiquement, sur Youtube Chris de Techtablets qui est super honnête et compétent teste les perfs de smartphone, et leur throttling, sans coque, donc ca ne vaut… rien. De meme, évaluer la lisibilité d’un écran a ses nits sans mesurer la réflectance… c’est bon pour Londres, pas pour mon Marseille (il est a Gibraltar ^^).

Ca me rappelle un peu mes cours de management: on mesure ce qu’on sait mesurer, donc on passe a coté du 80% d’intangible ou de trop compliqué a mesurer bien.

@Katarn: Ca ne m’a jamais posé de problème de passer du temps là dessus.

@JBLG: Oui, voilà. Personnellement un engin moins performant mais que l’o pourra mettre à jour ou franchement plus silencieux aura sans doutes ma préférence. Et cela ne veut pas dire que je ne vais pas apprécier la puissance développée par un autre. Il faut juste expliciter ces problématiques du mieux possible.

@Gilles: Oui j’ai pensé à un Spider Chart pour avoir une vue immédiatement complète des capacités d’un engin.

@Madwill: Je ne dis pas que les benchs ne sont pas pertinents hein. Juste que cela ne me parle pas à moi par rapport à mon média. Je veux dire que quand on se rend compte que 5 ou 6 MiniPC utilisent la même carte mère avec le même processeur, la même mémoire vive et le même stockage pilotés par le même BIOS cela parait un poil superflu de faire le même test. Les résultats sot identiques à la virgule près. Après cela n’empêche pas de lancer un outil de test pour voir si la ventilation est aussi efficace sur chaque machine.

@Bug: Oui, il y a quelque chose que j’essaye d’expliquer assez souvent c’est qu’une gamme de produit, avec un tarif assez proche, sera intrinsèquement liée à des usages identiques. Si deux machines si situent dans les mêmes eaux tarifaires, on aura grosso modo la même amplitude de capacités techniques. Il n’y a pas de miracles techniques. Les concurrents proposent des produits qui se ressemblent en terme de performances, de prix, de consommation. Un MiniPC à 300 – 450€ rendra la même amplitude de services quel qu’il soit. Je veux dire par là que ces machines n’auront aps les mêmes performances mais ne pourront pas prétendre a devenir des engins de jeu 3D ou de rendu vidéo. L’usage global sera toujours dans la même enveloppe.

@Madwill: Pourquoi pas mais personne m’en enverra pour test des machines pro d’occase !

@Bug: Oui le N100 est boudé par les grandes marques.. On en trouve dans des Chromebooks mais quasiment pas dans les portables plus traditionnels. Je suppose parce que c’est difficile de faire une marge correcte avec un portable sous N100 sans investir pas mal en amont. Par exemple, je serait ravi de découvrir un Transformer Book N100 remis au goût du jour avec un écran 11-12″ dans le même encomprement que le T100 original. Mais ça ne semble séduire personne.

@Mouffles Chantal: Ce sont de supers outils de contrôle. Surtout quand tu sait d’où tu pars et ou tu veux aller. Ce qui me pose soucis c’est de répondre à quelqu’un qui cherche un PC pour de la bureautique : « 10 000 points » à ce bench. 118e place du classement des PC testé. PArce que cela ne l’aide pas beaucoup…

@petitevieille: :smileyquirougit:

@Olivier Barthelemy: Ouais mais imagine si Chris se mettait a tester avec une coque ses smartphone, y’aurait quelqu’un pour dire que sa coque est différente… C’est difficile de tester dans des conditions particulières. Je l’ai remarque parce que je lit beaucoup de reviews de machines faites dans des pays qui ont un autre climat que le notre. Et leurs plages de fonctionnement ne sont pas les même. Par exemple, le Fanless est quasiment un on sujet chez eux parce que tu ne vis pas de la même manière dans un pays ou il fait 40-45°C une bonne partie de l’année… C’est difficile a traiter ce genre de détail.

@Pierre Lecourt: Non mais je suis d’accord avec toi sur la réel pertinence des bench, je m’en sers juste comme point de départ pour des comparaisons anciens vs nouveau procs car c’est plus simple pour trouver des ref.

Le rapport usage général/qualité/prix sera plus déterminant que de simples bench.

Pour ce qui est des tests sur du matos pro d’occasion, je me doute, après tout, cela aurait plus sa place sur le forum via les lecteurs du blog en possession de machine concernées.

PS: c’est grâce a minimachines que j’ai decouvert et fait l’achat d’un x230 il y a quelques années, toujours aussi réactif ;)

@Pierre Lecourt: J’ai un pote martiniquais.. PC ouvert et un gros ventilo dessus ^^ Apres les gens testent des ventirads !

D’un autre coté, sans coque c’est représentatif de personne. A la limite, un article intéressant serait de comparer diverses coques, vu que le throttling est un sujet interessant pour les mobile gamers (pas moi ^^). y’a pas 3 millions de types de coques non plus.

Tout a fait d’accord, les benchmarks me servent uniquement a conforter mon choix dans une minimachine et non à choisir une bête de course. Pour qui utilise un pc depuis des années sait ne pas écouter les sirènes du marketing. j’ai toujours fait du traitement photo de 1991 (facture Montgallet à l’appui) à nos jours et j’ai toujours lu ou entendu qu’avec un processeur d’ancienne génération je ne pouvais pas y arriver… Heu…. je faisais quoi avant ? Certes le poids des photos a bien changer depuis mes scans de diapo et on n’hésite plus à utiliser un nombre impressionnant de calques de nos jours (merci affinity 40% dans les bons plans)… mais delà à faire TOUJOURS table rase du passé NON !!! (ok, l’évolution des logiciels font aussi une nécessité de changer de machine)

Il y a des usages et des possibilités et non un dictat de la performance. Moi (qui ne suis pas un Gamer) je privilégie souplesse et SILENCE et je remercie Minimachines et l’ensemble des intervenants pour leurs retours et leurs conseils. Les capacités du T100 ont compté pour ma part (plus que d’obscurs chiffres) d’autant qu’un processeur seul ne fait pas une machine. Le même processeur avec différentes configurations n’aura pas toujours les mêmes résultats.

Le problème des benchmarks ce n’est pas l’outil qu’ils sont, c’est l’usage qui en est fait. Comme toujours.

Bravo pour ta proposition d’une nouvelle façon d’envisager les comparaisons de machines. Impatient je suis.

Perso je concentre mon intérêt de plus en plus sur le ration puissance/énergie que sur la puissance brute des bebetes

Oui, bon, quand on veut savoir, on mesure, c’est la base de l’ingénierie. Les chiffres, les donnés, les comparaisons. En audio domestique le marché est aux mains d’escrocs aux discours romantiques. Les mesures permettent d’objectiver et de comprendre.

Enfin, chacun son mode de fonctionnement et ça n’empêche pas minimachines d’être intéressant, il y a d’autres sites qui proposent les benchs.

@Madwill: Ce qui me fait de plus en plus peur avec les benchs c’est de voir des trucs où des processeurs très compétents sont tassés en fin de peloton parce qu’en haut il y a des bêtes de courses absolument sans aucun rapport. Des Core i9, Ryzen 9… Les puces AMD avec 3D V-Cach que sont positionnés en face de Ryzen 5 mobiles… Alors pour beaucoup de lecteurs ce n’est pas un soucis a analyser mais les emails que je reçoit en disent long sur ce que cela provoque chez les gens. Ils ont peur d’acheter un truc obsolète alors qu’ils choisissent juste un ensemble qui leur correspond bien.

Et c’est pareil pour DDR4-3200 et DDR5-5600. Pour un usage bureautique la DDR5 n’est pas indispensable.

Pareil pour les SSD NVMe haut de gamme qui semblent rendre les SSD classiques totalement inopérants…

@Olivier Barthelemy: Pas mal de contacts dans les pays à Mousson par exemple. Chez eux la notion de PC silencieux n’existe pas. Paradoxalement, dans des pays très chauds, où la clim est installée par défaut partout, c’est beaucoup plus fréquent…

@Xo7: Oui c’est une maladie marketing même si elle s’est essoufflée ces dernières années. Les puces n’ont plus des promesses de croissance de perfs aussi spectaculaires qu’avant. Elles promettent d’autres trucs comme l’IA ou un fonctionnement plus efficace. Cela permet d’être plus serein et de ne pas se faire déclasser par les applis qui ne peuvent pas compter sur une montée en puissance permanente.

Idem pour les cartes graphiques qui sont de plus en plus tournées vers des approches différentes de la perf pure. Le DLSS, le FSR ou le XeSS en sont de bons exemples.

Il n’empêche qu’au bout du compte on a des écarts tels entre les engins qu’on a tout de même l’impression d’acheter un truc dépassé quand on choisi un Alder Lake-N ou un Ryzen 5 5xxx alors que les puces sont encore tout à fait apte a remplir le cahier des charges d’un PC familial.

Comme tu le soulignes assez bien, le T100 est un bon exemple. La puce Atom embarquée a été directement cataloguée comme « inapte » par beaucoup de benchs. Alors qu’en pratique elle pouvait lancer un Photoshop pour des retouches basiques d e manière très convaincante. Ce n’était pas un outil pro mais elle couvrait à 100% les usages du grand public d’un logiciel de retouche photo. Sachant que ces 100% ne sont guère que 10% des possibilités de l’outil…

@JFN: Oui, c’est ce que j’ai voulu dire par « forger » un test. Ecrire un test après avoir lancé des benchs et faire coller le test aux résultats de ces benchs sans prendre en main véritablement l a machine à l’usage… Cela donne des résultats étranges. Comme décalés par rapport à la réalité.

@Raph: Oui et c’est un élément intéressant je pense. De plus en plus pertinent et cela va s’amplifier. Combien de personnes achètent une « bête » de course qu’ils utiliseront finalement qu’à 20% de ses capacités sans réfléchir aux conséquences de la consommation de leur PC ? Il est plus intéressant d’ajuster ses besoins tout en conservant une idée de la pérennité de la machine. Mais prendre un Core i9 ou un Ryzen 9 pour faire de la bureautique et surfer sur Youtube semble un peu hors-sol.

@bob: Je n’ai pas dit que je ne testerais pas les machines ou que je sortirais des chiffres au doigt mouillé. Je veux juste sortir de l’ornière d’une méthode qui va répéter en boucle les mêmes tests sur des machines pas prévues pour les mêmes usages. Tester CineBench sur un Intel N100 ne présente à mes yeux aucun intérêt. Qui va lancer autre chose que Sketchup pour faire de la 3D sur un MiniPC à 150e ? Idem pour les jeux, en quoi l’annonce du nombre d’image par seconde du dernier triple A à la mode va être un indicateur pertinent pour un Ryzen de 2019 ? Qui va acheter un Portable de ce type pour lancer Starfield ? Lui dire que le jeu s’affichera à 8 images par seconde sera vraiment utile ?

L’objectif n’est pas de ne pas tester mais plutôt de faire découvrir le véritable usage de chaque machine. Et on sait déjà qu’un MiniPC N95 ne sera pas taillé pour gérer le rendu vidéo d’un film Full HD de 1 heure avec un gros travail de correction colorimétrique dessus. Autant orienter le lecteur d’emblée vers la bonne direction.

Je conseille pour s’amuser l’excellent Pi

https://pi.ai/talk

Il est du niveau de ChatGPT 3.5 et en plus a du répondant et parfois du caractère. La version Inflection 2 est pour bientôt (basée sur 22000 GPU H100 de Nvidia !!!). Et il se mouille plus que ChatGPT quand il s’agit de faire un choix. On peut lui parler en français

Moi : Is a 13700k, 64go Ram, nvidia 3080, NVME 2 To and Corsair 850W a good setup for running localy Pinokio?

Pi: That’s a pretty powerful setup! Pinokio AI does have some minimum system requirements, so let’s see if you’re meeting them:

An Nvidia graphics card with at least 6GB of VRAM

A good amount of RAM (at least 16GB, but more is better)

A fast SSD drive for storing the AI models

A good CPU for handling the computational load

Based on what you’ve described, your PC seems to meet or exceed all of these requirements, so you should be in good shape to run Pinokio AI locally on your PC. The 64GB of RAM and the NVME SSD will help ensure smooth performance and fast data access, and the 3080 is more than capable of handling the graphics processing. Overall, I think you’re good to go! 👍

Et plus prosaïquement :

Moi : Between the CMK64GX4M2E3200C16 and the CP2K16G4DFRA32A which one?

Pi : The CMK64GX4M2E3200C16 and the CP2K16G4DFRA32A are both DDR4 3200MHz memory modules, but they do have some differences. The CMK64GX4M2E3200C16 is a Corsair Vengeance LPX model, which is known for its overclocking capabilities and high-performance gaming. The CP2K16G4DFRA32A is a Crucial Pro model, which is known for its reliability and affordability. Both models are solid options, but if you’re looking for higher performance and overclocking capabilities, the Corsair Vengeance LPX model might be the better choice. However, if you’re looking for a more affordable and reliable option, the Crucial Pro model could be the better fit. It really depends on your specific needs and budget.

Il y aussi l’excellent Perplexity https://www.perplexity.ai/ qui donne d’autres types de réponses avec des liens additionnels souvent très judicieux. Il existe une extension Perplexity Chrome.

Je reprends mon post :

Perso je concentre mon intérêt de plus en plus sur le ratio* puissance/énergie plutôt** que sur la puissance brute des bebetes

DSl pr les fautes de frappe :)

Si je peux me permettre de raconter mon expérience sur le sujet

En 2015, Apple a sorti un laptop ultra-portable du nom de Macbook 12″, et en 2016 j’ai acheté, via ma boite, un modèle milieu de gamme (core M5) avec un petit poussage sur les options : 16Go de RAM et 512Go de SSD

Les tests de ce modèle, et je parle de TOUS les tests sur TOUTES les plateformes, même les plus sérieuses et les plus reconnues, ont tous pointé une machine « anémique », dont les performances s’écroulaient rapidement du au thottling imposé par l’absence de ventilateur … car oui, l’appareil était totalement fanless

Or à l’usage, et pour en avoir un, j’ai constaté exactement l’inverse : une machine extrêmement réactive, capable d’avaler de très nombreux usages « lourds » qui sortaient franchement du cadre bureautique à laquelle cette machine était pourtant destinée

J’ai fait de l’After Effect et du Photoshop de haut niveau avec, et le confort de travail n’était pas, le plus souvent, très éloigné de mon iMac Pro, un desktop monstrueux (pour l’époque) avec un gros Xeon dedans, une carte graphique dédiée, de la RAM à ne plus savoir qu’en faire, et un SSD très véloce.

Alors la machine avait ses limites, mais pour les atteindre il fallait lui en balancer du bien méchant, contrairement à ce que les nombreux tests indiquaient

Alors comment expliquer cette différence « cruelle » entre des testeurs qui flinguaient l’appareil à la mitraillette, et des utilisateurs majoritairement (j’en ai lu des commentaires) ahuris de lire ça et de constater l’inverse à l’usage ?

C’est très simple, la réponse s’appelle : les benchmarks

Pour mieux comprendre la situation, il faut (rapidement) parler de comment fonctionnait les « core m » de l’époque. C’était des CPU très basse consommation, pas franchement très puissant, mais qui avaient la capacité de gérer des pics de demande de puissance en s’auto-boostant.

Ainsi, à l’usage, un core m5 comme celui de mon Macbook 12″ 2016 était capable de rivaliser sans souci avec les « gros » core i5 des Macbook Pro et autres PC à 1000/1500€ en se boostant, mais à la condition que la demande en puissance soit ponctuelle et ne dure pas dans le temps

Or à l’usage, c’est exactement ce qu’il se passe pour la majorité des besoins pro ou pas pro. Il suffit d’ouvrir le moniteur d’activité et de regarder ce qu’il se passe, la plupart du temps il y a des « pics » d’usage CPU et entre ces pics, le CPU est sous-chargé. Il se tourne les pouces.

Pour que le CPU soit sollicité à 100% sur une longue durée, il faut des usages très spécifiques : export vidéo, rendu 3D, etc. Ces usages de station de travail, fort éloignés de ceux d’un utilisateur bureautique, la cible des Macbook 12″

Et ça, les testeurs de cette machine sont totalement passé à coté

Tous, et je dis bien TOUS : MacGeneration, Mac4Ever, les Youtubers, etc la liste est longue, donc TOUS ont passé cette machine sous le crible des benchs … pour constater qu’en usage intensif la machine throttle à mort, les performances chutent, donc c’est un « veau »

On a assisté à un tsunami de conclusions de testeurs « professionnels » nous expliquant que cette machine bureautique, mon Dieu, était proprement incapable de tenir un rendu 3D de 5 heures ou un export vidéo d’un film de 30 minutes avec force plug-in denoise et autres joyeusetés nécessitant un Threadripper haut de gamme et une RTX de taré …et de la flinguer sans autre forme de procès

J’ai, pour ma part, emmené en 2019 cette machine lors d’un gros événements cinéma très connu, sur 15 jours, ainsi qu’une grosse station de travail hackintosh pour gérer la création de contenus qu’on me demandait de faire.

Au 1er jours, le hackintosh a mis à jour son bootloader, une mise à jour qu’il ne fallait pas faire, et la grosse station de travail est devenue incapable de booter, et je n’avais absolument pas le temps de tout arrêter pour m’occuper du débogage de ce boot-loader, je me suis retrouvé sans outil de travail avec une énorme pression pour enquiller des rendus qui arrivaient à la chaine.

J’ai donc allumé le Macbook 12″ et commencé à l’utiliser en backup, et finalement j’ai tout fait le taf pendant 15j sur ce petit laptop.

Certes certains rendus ont pris plus de temps avec la grosse tour (5 minutes au lieu de 2 ou 3), mais globalement, j’ai traité des centaines de photos très haute résolution, et pondu masse d’animations motion design sous After Effect sans qu’a aucun moment la machine ne pose problème

D’un coté, la presse « spécialisée » nous a expliqué à l’unisson, avec force chiffres de benchmarks, que cette machine était à peine bonne à taper du texte

De l’autre j’ai pu régulièrement l’utiliser pour des tâches plutôt dévolues à des stations de travail, et les rendus sont sortis sans trop de douleur, et globalement assez confortablement, et nombre d’utilisateurs dans les forums ne comprenaient pas les soit-disant « lenteurs » qu’ils ne constataient pas, ni les conclusions des « experts » à l’encontre totale de leur expérience d’utilisation

Merci donc Pierre pour cet article, encore une fois, plein de bon sens et d’intelligence

Effectivement 3526 points de différence entre deux processeurs ne parle qu’aux initiés dans les taches qui les concernent. L’humain perçoit la puissance de son ordi de façon plus pragmatique. Combien de secondes pour être prêt à bosser après allumage? Combien de moyenne d’autonomie dans différents scénarios (surf, vidéo, jeux) Combien de temps pour encoder une vidéo, décompresser une archive, faire tel type de calcul (il est important que tout soit fluide pour les choses répétitives, mais quand je lance un encodage une fois par semaine je vais sans doute faire un tour donc je ne me rendrai pas compte si mon ordi met 2 min de plus ou moins qu’un autre). Est ce que je peux utiliser da vinci resolve, ableton, gimp… séparément… ou en même temps… et avec des réseau sociaux et youtube sur un 2eme 3eme 4eme écran? La capacité d’évolution et de réparabilité du bazar? soudé pas soudé? etc plein d’autres cas pratiques ou il faut forcément choisir la cible de mini machines.

Perso après avoir monté une tour pc, puis trouvé qu’un portable était plus simple pour me retrouver esclave d’une machine quasi irréparable ou de façon prohibitive (mon portable actuel est sans écran ni clavier ni batterie :D et c’est donc un mini pc…! Je vais devoir le changer et vais m’essayer au mini pc pour profiter du meilleur des 2 mondes… je rêve de pouvoir l’alimenter en solaire ou et batterie pour mes déplacements et me faire un pc valise moins gros qu’un sff pour faire montage, retouche, MAO, jeux, de façon avancée mais pas en production pro intensive, et sans turbine d’avion supersonic.

Tout ça juste pour présenter un profil, mais qui est probablement très très loin d’être le profil lambda de mini machine! Mais ton approche sera forcément appréciée car elle pourra de toute façon se superposer aux benchs existants…

@AlxV: Ton histoire me rappelle les tests d’APN qui disent que les boitiers chauffent a mort et décrochent… lorsqu’on fait du 280 IPS en UltraHD pendant 20 minutes… A chaque fois je suis incrédule parce qui va filmer 20 minutes en ralenti extreme ? Quand tu fais un ralenti c’est quelques secondes max car le film que tu en tireras peut pas s’éterniser 40 ou 60 secondes dessus. Mais alors 20 minutes de ralenti d’affilée ça correspond à combien d’heures de film d’affilée si tu pars d’une base 24 ips ? C’est complètement idiot de se baser sur cet usage et de dire que l’engin chauffe.

@Subma: Le solaire c’est possible mais pas gagné, surtout en mobilité.

@bob: Je n’ai pas dit que je ne testerais pas les machines ou que je sortirais des chiffres au doigt mouillé. Je veux juste sortir de l’ornière d’une méthode qui va répéter en boucle les mêmes tests sur des machines pas prévues pour les mêmes usages. Tester CineBench sur un Intel N100 ne présente à mes yeux aucun intérêt. Qui va lancer autre chose que Sketchup pour faire de la 3D sur un MiniPC à 150e ? Idem pour les jeux, en quoi l’annonce du nombre d’image par seconde du dernier triple A à la mode va être un indicateur pertinent pour un Ryzen de 2019 ? Qui va acheter un Portable de ce type pour lancer Starfield ? Lui dire que le jeu s’affichera à 8 images par seconde sera vraiment utile ?

Je comprends pas ton point de vue mais il faut aussi que tu fasses confiance à tes lecteurs. Je m’en balance de test Cinebench. Par contre le test cpubenchmark fonctionne aussi sur de l’architecture ARM et c’est intéressant, c’est une mesure intéressante, pour comparer, pour donner une idée. Et avec plusieurs lignes qui composent le test, on peut voir où ça n’est pas terrible et où c’est confort.

En tant que développeur, j’ai besoin de mesurer. En tant que spécialiste de l’observabilité, je passe ma vie à produire des données d’analyses et de synthèses sur des milliers de serveurs. Les SLO et les SLA s’appuient sur les données générées, mesurées et calculées.

Je comprends qu »il y a les « cas d’usage », mais je suis persuadé que les lecteurs du site savent quoi demander à un N100 ou un 7840. Si c’est pas le cas on va sur un site qui va brosser le sens du poil d’utilisateurs Apple.

Vive la mesure, il n’y a que ça de vrai, le reste n’est que littérature.

@bob: « Je m’en balance de test Cinebench. Par contre le test cpubenchmark fonctionne aussi sur de l’architecture ARM et c’est intéressant, c’est une mesure intéressante, pour comparer, pour donner une idée. »

Et un autre me dira pareil pour un autre bench et un troisième pour encore un autre. Et au final si je prend cela en compte cela voudra dire que rien n’aura changé. Que les spécialistes qui peuvent trouver l’information de Cinebench, CPUBenchmark ou n’importe quel autre test partout ailleurs sur la toile auront juste un clic de moins a faire mais que les personnes lambda qui n’ont pas pour métier ni pour passion de se coltiner des grilles d’analyse tableaux seront toujours dans le flou.

« mais je suis persuadé que les lecteurs du site savent quoi demander à un N100 ou un 7840. »

Et bien non, Et à chaque mise à jour des noms des CPU c’est encore pire. Il suffit d’écouter des gens proches demander quel engin acheter aujourd’hui pour voir à quel point ils ne savent pas par quel bout prendre les éléments. Et du reste, si on me demandait de choisir un lave linge en me donnant ses watts et sa vitesse de rotation max, je serais bien incapable de faire un choix. Il me faut lire les capacités de ses programmes pour savoir quoi choisir. Si cela correspond à ma famille, à mon type de linge, si il saura laver mon pull en laine angora sans le saccager…

« on va sur un site qui va brosser le sens du poil d’utilisateurs Apple. »

Je ne vois pas le rapport ?

« Vive la mesure, il n’y a que ça de vrai, le reste n’est que littérature. »

Ah la littérature, le truc qui permet de saisir les nuances, le pourquoi du comment, l’essence même de toute civilisation, même scientifique. Vive la littérature ! Sans essayer d’en proposer oui c’est mon objectif, percer les mystères des machines avec des mots. Pas avec des chiffres.

D’abord parce que d’autres fournissent déjà ces chiffres, répétés à l’infini et dans des tableaux abscons où, comme en témoigne le message d’@AlxV, ces chiffres ne veulent souvent plus rien dire. Ensuite parce qu’il n’y a aucune plus value a faire ces tests encore une fois de plus.

Ce matin encore je lisais un papier expliquant dans son titre et son intro qu’un futur processeur serveur était à la ramasse dans un bench qui aurait fuité. Avant de conclure que c’était un prototype de la puce et qu’il n’était pas optimisé. Et que le bench ne prenait pas en compte ses nouvelles instructions. Quel intérêt que d’écrire ce papier ? Je comprend bien que le site qui publie va y trouver son compte avec un titre un peu énigmatique et accrocheur car derrière il va pouvoir vendre de la pub… Mais ce papier angle du côté « Performance Benchmark » et finit par se raccrocher aux branches de la logique en fin de page pour convenir que la mesure obtenue est faussée.

Vive la littérature.

Les chiffres, les chiffres … Passer de 5200 à 5700 sur un test ne fait qu’environ 10% de gain mais représenté sur une échelle verticale qui va de 5000 à 6000, ça impressionne ! Un artefact bien connu du marketing. Donc, bon …

Merci à Pierre de relativiser tout cela et de parler d’usage éclairé de la chose.

Pierre, ton intention générale est très bonne, mais évidemment c, n’est pas facile de savoir comment faire tout ça:

Pour ma part, je vais raconter comment je trouve ce que vaut le CPU qu’il y a sur les nouvelles machines que tu annonces ou sur les billets de bons tarifs. Comme l’époque où les noms de CPU avaient du sens est bien révolue, et que je n’ai pas que a à fiche, je rentre dans un moteur de recherche un truc comme « n100 vs n4100 » pour tester un n100 en le comparant au n4100 qui est ce qui équipe ma machine et je prie pour que ce comparatif soit sur cpuuserbenchmark car c’est le seul site ayant une note synthétique sur 3 types d’utilisation qui peut me dire utilement ce que je peux espérer du microprocesseur. Évidemment, ça ne me dit rien sur la machine à l’origine de ma requête mais a me permet de savoir si ça revêt un intérêt pour moi. Et je ne sais pas trop comment cette note arrive, mais j’ai pu constater qu’elle est assez fidèle a la réalité.

C’est ce genre d’information synthétique qui est utile. D’ailleurs, je ne m’intéresse qu’à ça sur cpuuserbenchmark.

Et enfin il faudrait préciser systématiquement si un engin est fanless pas et s’il émet un sifflement s’il est fanless (quoiqu’il me semble que cela ne se produise plus sur les machines récentes). Les possibilités d’upgrade et la prise RJ45 complètent les choses indispensables à savoir.

@Jean-Pierre: Oui ce n’est pas facile mais j’y réfléchis depuis pas mal de temps et je comprend bien ton inquiétude de lisibilité. Je saurais lire vos retours également.

Le truc, tu vois, c’est que l’info tu l’a déjà. Et moi ça ne m’amuse plus de disserter sur des benchs de puces aujourd’hui. Tu dois avoir 50 ou 60 MiniPC sur le marché actuellement sous Intel N100. Tester systématiquement ces dizaines de machines n’a aucun sens.

Ce qui serait intéressant par contre ce serait de couvrir les possibilités offerte par un MiniPC N100 « témoin » avec 8/16/32 Go de mémoire vive et en faire un outil de travail pertinent pour orienter le lecteur. A partir de cet outil on peut définir clairement à quoi et à qui sont destinés ces dizaines de machines sans passer dans la redite. Et, évidemment, pour chaque machine noter les éventuels points positifs ou négatifs spécifiques. Par exemple un MiniPC fanless qui tient – ou qui ne tient pas – la charge.

Pour le reste, l’upgrade, la connectique et l’éventuel Coil Whine, c’est l’affaire de la fiche technique et de la littérature :)

@Pierre Lecourt: Et comme on me le fait remarquer sur Mastodon, un point clé vient également du fait que les machines évoluent. Par exemple la ROG Ally a été massivement testée au début, à son lancement, mais les performances déployées aujourd’hui sont sans rapport du fait des optimisations effectuées par Asus.

@Pierre Lecourt : Un grand merci pour ton aide avec ma commande de mon T-Bao N100 16/512 sur Geekbuying.

Je l’ai reçu il y a deux jours, ça a été super rapide.

Je suis très surpris, positivement, des capacités de cette petite machine.

J’avais très peur que ça rame, et bien je ne vois presque pas de différences par rapport à mon PC secondaire, un i5 2500K.

Pour de l’utilisation courante, navigation avec pas mal d’onglets ouverts, de la bureautique et même de la retouche avec Affinity Photo, AUCUN souci !!!

Et il est très silencieux, bien plus que ma tour avec son i5…

Bref, à part le souci éventuel de l’absence de garantie et le manque de recul sur la fiabilité sur le long terme, je recommande chaudement cette petite machine !!!!

Encore merci pour me l’avoir fait connaître !

100% d’accord avec ton billet Pierre:

Les benchmark c’est la vanité. Les use cases c’est la réalité.

@Alu:

« Les benchmark c’est la vanité. Les use cases c’est la réalité. »

Là encore, je n’irai pas jusqu’à dire que c’est la vanité les benchs, mine de rien les chiffres permettent de « situer » un processeur, ou une carte graphique, mais oui, les « use cases » c’est VRAIMENT la réalité

Et pour pester sur les testeurs, j’en reviens à d’autres exemples que j’ai pu rencontrer, toujours dans l’univers Apple (désolé, je ne bosse que la dessus), comme les tests de machine plutôt « haut de gamme », des stations de travail (Dell XPS, Lenovo Xtrem, etc sur PC, et Macbook Pro chez Apple) qui donnent leur potentiel sur des logiciels et des workflow spécifiques

Sauf que les testeurs ne sont pas motion designer, modeleurs 3D, concepteurs CAD, musiciens sur des grosses prod, developpeurs sur des gros softs, j’en passe et des meilleurs, du coup leurs tests se bornaient à …. du bench, et quelques tests de montage vidéo absolument pas parlant

Bref aucun « use case » qui démontre bien les spécificités des machines, comme si un testeur de camion benne faisait la review d’un nouveau camion en allant chercher une baguette de pain.

Use case, use case, use case. Il n’y a que ça de vrai !

@AlxV: Il faut du benchmark sur les use case parce que c’est objectif et concret, la difficulté c’est de capturer les use case qui intéressent le lecteur (et le testeur). Avant l’un de mes benchmarks c’était le temps jusqu’à photoshop démarré de puis l’ordi éteint mais maintenant avec le ssd plus vraiment d’intérêt, aujourd’hui c’est plutôt le bruit et à partir de quand le ventilateur déclenche ou la chauffe sur le portable

Concernant une machine, j’apprécie les informations que je ne peux avoir ailleurs, c’est à dire les tests utilisateurs (bruit, accessibilité des composants après démontage, etc.)

Quant aux benchmarks, je me focalise sur ces trois grandeurs performance / prix / conso en comparant les CPU qui m’intéressent (actuellement j’utilise le comparateur de cpubenchmark).

« A la rigueur il serait parfois plus utile de créer un suivi des capacités de certaines puces – comme l’Intel N100 ou le Ryzen 7 5700U massivement déployés sur de nombreux MiniPC. Dans des contenus indépendants des tests, régulièrement mis à jour et augmentés de nouvelles pratiques. »

Oui, c’est une formule qui me parait équilibrée.

Excellente réflexion, mais qui ne peut pas mener à une réponse universelle.

Chacun a ses propres sensibilités par rapport à une machine, et il est impossible de répondre à toutes.

Je pense que le mieux que tu puisses faire c’est d’apporter un point de vue sur la machine: Présenter les cas d’usages pour lesquels la machine te semble favorable et ceux pour lesquels elle l’est moins.

Mais les biais resteront nombreux:

– Tes goûts

– Tes sensibilités à certaines nuisances (confort, bruit, chauffe, réflectance, définition, PWM, prix…)

– Tes points de comparaison

– Tes usages

Le travail de Notebookcheck est de très loin celui qui me parle le plus. Ils prennent en compte des critères qu’on retrouve rarement ailleurs, et qui me semblent pourtant cruciaux:

– Les nuisances sonores

– Le PWM de l’écran

– La chauffe

– Le confort

– Le comparatif à des machines du même segment

Ce qui leur manque, c’est une analyse plus fine des cas d’usage en prenant en compte de tous les facteurs. C’est finalement des prises de position assumées, subjectives mais expertes, qui puissent éclairer le lecteur sur l’intérêt réel de la machine, lui apprendre s’il paye pour des fonctions dont il n’a pas besoin ou si la machine a au contraire un excellent rapport qualité/prix pour ses usages.

Si finalement une fiche technique aguicheuse ne vient pas au détriment de l’expérience utilisateur réelle. Ou au contraire si un apparent rapport qualité/prix médiocre ne s’explique pas par des atouts moins visibles tels qu’un excellent système de refroidissement, un châssis particulièrement robuste ou une connectique plus fournie et plus moderne.

Ou encore si une machine ultra légère ne vient pas avec une expérience par ailleurs très dégradée à tous points de vue: mauvais refroidissement et donc bruit, chauffe ou perte de performances, inconfort d’usage, sensation de fragilité (même injustifiée), etc.

Enfin, ce que tu apportes déjà souvent dans tes tests et qui fait toute ta pertinence c’est le « ce qui aurait pu être », ou au contraire le « pourquoi c’est comme ça ». Les choix des constructeurs sont souvent discutables et tes points de vue sur le sujet sont toujours passionnants.

Pour ma part, je suis effaré de voir l’évolution de certains marchés:

– La disparition des netbooks… ? Je rêve d’une machine de 10″ de moins de 800g avec un clavier confortable, N100 et sous les 300-400€.

– La disparition des tablettes 7-8″, format pourtant excellent pour tout un tas de raisons ?

– La disparition du format 16:9 sur smartphone… et du coup des smartphones avec une surface utile conséquente ?

Et j’ai toujours du mal à penser que personne ne soit présent pour prendre ces parts de marché.

@uko: Je suis 100% d’accord… et c’est pour cela que je continue de dire que Minimachines est un blog. L’important pour moi c’est certes d’y exprimer mes goûts (et mes biais) mais de laisser entendre ce qui m’affecte afin que chacun puisse y trouver son angle d’appréciation.

@Pierre Lecourt : Je trouve moi aussi cette initiative très intéressante.

Je ne conteste pas plus que la plupart des lecteurs qu’une mesure de processeur, de disque, de mémoire et autre composant d’un ordinateur est utile… à ceux capables d’assembler une machine. Je n’ai pas de source pour le démontrer, mais je suis persuadé que la plus grande part du public est plutôt intéressée par les performances d’une machine complète en fonction des usages.

Personnellement, je ne sais rien tirer des performances de chaque composant. De plus, quand je vois les performances brutes des composants d’il y a dix, vingt ans et ceux de maintenant, il y a un tel écart que je me demande pourquoi une machine moderne n’a pas des temps de réponse absolument instantanés !

Mais évidemment, annoncer qu’une augmentation de 20% de performance sur des composants n’amènera au mieux qu’1% ou 2% d’amélioration dans l’usage quotidien, ce n’est pas vendeur.

Dans les récents benchmark, il faudra aussi comprendre que les compilateurs ne génèrent pas forcément le code de la même manière. Par exemple, sous mac un « for (n=0;n<strlen(str);n++)" ne calcule le strlen() qu'une fois si dans la boucle str n'est pas modifiée, alors que sous visual studio si str est une longue chaine de caractère le calcul du strlen() à chauqe itérations est sensible. Plus encore, sous xCode, j'ai trouvé qu'un "if ((bool1)&&(bool2))" discrimine par prédictions un des deux test booléens, ce que l'on peut même en évidence en par l'exécution d'un script dans les conditions qui ne génère pas une prédiction fiable, par exemple dans l'incrémentation d'un pointeur du script…