Intel a profité du Computex 2023 pour détailler les nouveautés intégrées dans son nouveau processeur Meteor Lake et en particulier le travail mené autour de son architecture de construction. Cette puce sera la première à bénéficier de la collaboration entre Intel et le fondeur TSMC. Ce sera également la première puce de la marque à intégrer un circuit spécialisé dans le calcul d’IA.

Pour Intel, mettre un pied matériel dans l’IA et son accélération est important. Nvidia est devenu une star de ce poste avec un investissement constant depuis des années autour de ses cœurs CUDA. AMD a également intégré des moteurs dédiés à cet usage et Apple en fait un cheval de bataille. Pour Intel, c’est donc à la fois un rattrapage et une entrée au bon moment. Microsoft ayant à son tour annoncé le recours à des solutions d’IA au sein de ses produits. L’Intelligence Artificielle a revêtu un certain éclat depuis l’explosion des outils créatifs et tout le monde veut profiter un peu de sa lumière.

Beaucoup considèrent les outils génératifs à base d’IA comme un nouvel âge d’or de l’informatique, tout le monde veut donc proposer les outils les plus efficaces pour en profiter. Intel a donc détaillé un peu plus la manière dont les puces Meteor Lake offriront des outils à cette évolution.

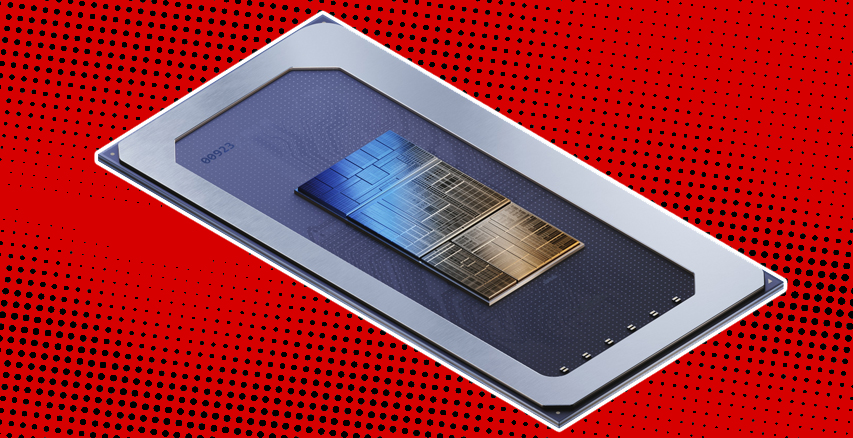

Gravées avec le process Intel 4, les puces Meteor Lake mélangeront des composants issus de ses propres usines avec celles de TSMC. Les « Chiplets », ces éléments qui seront agglomérés entre eux sur la puce de base d’Intel, mélangeront ainsi les finesses de gravure. On retrouvera ainsi quatre éléments distincts avec un CPU, un GPU, une partie SoC/VPU1, une partie GNA 2 et la gestion des entrées et sorties. Tous ces éléments agglomérés verticalement en utilisant la technologie Foveros d’Intel.

Intel a particulièrement insisté sur le VPU dont la fabrication a été confiée à TSMC avec son process N6. Dans cette nouvelle conception de ses puces, Intel peut donc varier les éléments et les agréger de manière très souple. Augmentant la part de l’un ou de l’autre au gré des besoins. Améliorant ainsi les capacités de calcul, la puissance graphique ou profitant d’une éventuelle évolution des processus de gravure sans affecter tout le design de sa puce. Une souplesse très intéressante pour adresser des puces particulièrement adaptées à certains usages.

Si on résume la puce Meteor Lake, c’est un millefeuille de compétences et de gravures. La partie CPU de Meteor Lake n’est pas confiée à TSMC mais reste sous la supervision d’Intel et de son processus Intel 4. L’interface Foveros qui fait la jonction entre le processeur et les chiplets est gravée en Intel 16. Tout le reste des composants assemblés par dessus le processeur est confié à TSMC avec des gravures légèrement différentes. Ainsi la partie graphique est en TSMC N5 et le SoC comme l’IOE sont en TSMC 6N. On imagine que l’objectif de cette conception est également de permettre à Intel de reprendre la gravure de l’ensemble des composants au fur et à mesure de sa montée en puissance en finesse de gravure.

D’un point de vue conception, le procédé est évidemment très pratique pour Intel. Le fondeur pourra faire évoluer ses puces avec beaucoup de souplesse. Besoin de plus de Cores, il sera possible d’agrandir cette partie. Un nouveau Core fait son apparition, il sera possible de l’additionner sur un design plus ancien ou de mixer deux architectures avec un Coeur performant et un Coeur Efficient comme c’est déjà le cas dans les puces Alder Lake.

Ce scénario se répète pour chaque composant. La partie graphique pourra également évoluer facilement soit en nombre d’unités soit en cache ou de génération. Idem pour la partie SoC qui pourra s’adapter aux différents besoins. Prendre en charge un format nouveau ou faire évoluer un protocole plus aisément.

L’ensemble de la puce Meteor Lake pourra profiter de la mémoire globale et ainsi redistribuer des données vers chacun des éléments assemblés. Ce qui veut dire que les différentes données pourront jongler d’un circuit à l’autre suivant les besoins et traitements. Comme c’est le cas chez AMD sur ses nouveaux Ryzen 7040 ou Apple avec ses puces Mx.

La partie VPU est au cœur de la stratégie IA d’Intel même si Meteor Lake comporte d’autres outils capables de mener à bien des tâches de ce type. Ainsi le CPU, le circuit graphique et le GNA pourront être mis à contribution suivant les tâches. La différence entre ces éléments et le VPU est liée aux différents traitements. Le CVPU sera particulièrement utile en tâche de fond. Invisible à l’utilisateur, pour tous les outils requérant une IA sans qu’on le remarque particulièrement. La partie graphique sera mise à contribution de manière plus visible, plus intensive, lorsque vous demanderez un rendu 3D ou le calcul d’une transition vidéo par exemple. Le processeur de calcul saura, quant à lui, réagir rapidement pour des besoins immédiats. Evidemment tout ce petit monde pourra travailler de concert, à condition que la partie logicielle les prenne en compte.

Intel développe des éléments qui vont dans ce sens, pour que les développeurs puissent jongler avec l’ensemble de ces composants et faire de Meteor Lake – et des générations suivantes – une boite à outil adaptée aux différents besoins de leurs programmes. L’idée étant de proposer de manière très fine l’ensemble de ces besoins pour offrir le meilleur rendement possible au long cours. Il sera peut être plu utile de faire appel au VPU pour certains calculs pour ménager l’autonomie d’un portable quand on pourra au contraire profiter du CPU pour être plus rapide une fois branché sur secteur. Un ensemble de recettes et de scénarios doivent être mis en œuvre par Intel et les développeurs pour trouver les meilleurs arrangements.

Si aujourd’hui les puces d’Intel utilisent son GNA pour effectuer des tâches surtout orientée multimédia, c’est à dire la correction d’un bruit de fond dans une vidéo conférence ou la reconnaissance vocale pour les assistants personnels, certaines de ces tâches pourraient basculer vers le VPU pour plus de performances. A terme, le fondeur pourrait donc supprimer le GNA et tout basculer vers un VPU plus puissant. Meteor Lake hérite des deux technologies dans une logique de transition.

Aujourd’hui, Meteor Lake est en fonction dans les laboratoires d’Intel. Les travaux d’optimisations sont en cours. Tant du point de vue pilotes que prise en charge des différents éléments pour les développeurs mais aussi pour proposer un rendement de fabrication efficace. Le calendrier annoncé prévoit toujours une commercialisation de ces puces en 2023.

Notes :

| 2,5€ par mois | 5€ par mois | 10€ par mois | Le montant de votre choix |

une question naive pour les spécialistes:

« Beaucoup considèrent les outils génératifs à base d’IA comme un nouvel âge d’or de l’informatique »

Je ne pense pas avoir de programme utilisant une IA installé sur mon portable. Est-ce que c’est faux et que certains de programmes utiliseraient une forme d’IA ? Si oui, lesquels?

Merci à ceux/celles qui pourraient éclairer ma lanterne.

@romain: Ben on sait pas ce que tu as comme portable ni comme OS. :)

@romain:

On parle d’IA mais en fait c’est plus simplement une utilisation massive d’algorithmes et les puces dites IA intègre matériellement le traitement de certains algorithmes pour accélérer encore leurs traitements (explication très très simplifiée).

Dans les programmes qui peuvent utiliser ce genre de composants il va y avoir les applications de traitements graphiques, les programmes de visioconférence, on va les voir arriver dans des programmes bureautiques par exemple pour des traductions, de exploitations de données, …

je ne pannais déjà rien aux CPU depuis pentium (°o°)

Alors là ça va devenir un brin difficile de choisir la bonne machine ⊂(◉‿◉)つ

merci pour vos réponses.

j’utilise un MacBook Air, à vocation scientifique (j’écris des petits scripts de machine learning mais j’ignorais pour les programmes courants). Je posais la question car les puces Apple ont apparement un design dédié à l’IA … ce qui m’a toujours interloqué.

Un sentiment que les prochaines années vont être juridiquement très interressantes sur certains OS et applications tierces.

@romain: Il y a plein d’éléments qui peuvent en tirer parti en fait. Les outils qui permettent de diminuer les bruits autour de l’interlocuteur lors d’un enregistrement, le floutage d’arrière plan ou la reconnaissance vocale d’un assistant personnel.

Après il y a les usages un peu plus pro comme les outils vidéos qui vont générer des sous titres a partir de vidéo, ou des outils qui vont gommer une zone d’image pour la remplacer par un élément cohérent. Flouter un arrière plan après avoir identifié un sujet. Il y a plein d’usages différents.

@A.S.: Qu’est ce que tu veux dire ?

merci Pierre!

Nos smartphones sont en avance de ce côté là.

@Le Breton: Oui, justement parce que l’architecture des puces ARM est un SoC avec une multitude de petits cœurs spécialisés. Il a été plus facile d’ajouter ce genre de fonctions sur les ARM que sur les puces x86. C’est aussi une des raison pourquoi AMD et Intel basculent vers ces architectures hybrides.

@Pierre Lecourt: D’un autre côté, hormis pour l’appareil photo, j’ai pas l’impression que ces capacités soient très utilisées sur smartphone, à l’inverse sur PC la demande sera sans doute plus forte.

@Le Breton: Je suis par contre surpris que l’information revienne aux architectures spécialisées pour tel ou tel calcul, dans le monde du GPU par exemple.

En 2006, on nous promettait chez les concepteurs de processeurs graphiques que les coeurs programmables (« coeurs CUDA » ou équivalent chez amd et autres) permettraient enfin la flexibilité dans le calcul.

Maintenant les cartes graphiques sont bourrés de coeurs dédiés à une fonction XXX ou à une autre fonction XXX, upscale, ray tracing, bientôt l’ia…

ça ressemble beaucoup à millefeuille, mais sans le goût et pense que ce sera fade !

@Le Breton: C’est du marketing. C’est assez malin de la part de Nvidia d’ailleurs.

Ils arrivent avec le RayTracing, c’est un non sujet pendant la première année. Ils poussent les devs a s’impliquer, des jeux sortent et cela devient alors un « must have ». Les concurrents courent pour essayer de coller aux basques de Nvidia sur le sujet. Nvidia assoit son discours en disant « on est les premiers » et montre son savoir faire.

L’année d’après ? C’est le DLSS. Rebelote. Ils sont tous seuls, la concurrence court, et ils continuent a fanfaronner.

Pour l’IA ça sera la même chose. Avec en plus une intégration qui sera plus massive et plus rapide à mon avis.

@Pierre Lecourt: Pour l’IA, je ne mettrais pas cela au futur, Nvidia travaille depuis un moment sur l’accélération de l’IA en fournissant des GPU et drivers adéquat. Ils proposent même des cartes orientées (A30 par ex) pour l’utilisation et l’entrainement de modèle d’IA (detection, classification, etc)

@Pierre-Yves P.: Le marketing est un outil grand public, il ne parle pas vraiment aux spécialistes qui utilisent l’IA pour du Compute vision. Là l’idée c’est de mettre en avant des processus de génération via IA et de pointer le doigt dessus dans des jeux ou des usages »neufs » comme la génération d’image ou la retouche.

Quand un jeu va profiter d’un entrainement de génération de dialogue sur un corpus spécifique pour proposer une expérience plus immersive, ce sera sans doute un tour de force qui sera pointé du doigt avec plus de retombées grand public que les usages industriels proposés au quotidien. Quand un jeu proposera une génération de personnages et de décors 3D via une IA on va en entendre parler pendant des mois comme une révolution même si tout cela est techniquement possible depuis des années.

Le marketing quoi…

@Pierre Lecourt: Les capacités de ces circuits dans le cadre du jeu pourraient aussi être utilisées pour obtenir des pnj au champ d’action étendu…des ia quoi.

@Le Breton: Oula, quand je vois les sorties Triple A de ces dernières années, je me dis qu’on est pas prêts a voir des IA d’action avant un moment. Si un scénario arrive déjà a tenir la route ca sera le bout du monde. Quand je vois la sortie de Gollum, c’est le jeu qui a été terminé par une IA…

Moi j’adorerais voir un jeu à la « Anno », un Rimworld, un Disco Elysium ou encore un JDR avec une vraie IA pour des évènements, des dialogues… malheureusement je ne pense pas que cela soit si proche.

@Pierre Lecourt

Qu’est ce qui différenciera demain un ordinateur individuel et un cluster ?

@Pierre Lecourt: The last of guardian et son succès montrent qu’il y a pourtant un public pour ces jeux qui ont pour élément centrale une ia palpable (au moins en apparence) en laquelle on croit.

Après c’est vrai que l’ia dans son aspect vidéoludique c’est pas juste un personnage mais aussi tout le principe de fonctionnement du monde virtuel proposé avec ses règles.