ARM développe et conçoit des architectures de SoC qui sont ensuite vendues à d’autres sociétés pour les fabriquer et les développer. ARM V9 est donc la dernière architecture en date, qui sera distribuée ensuite auprès de tous les partenaires de la marque : Samsung, Apple, Rockchip, Qualcomm, Allwinner et j’en passe. Cette architecture, comme les précédentes, aura un impact sur la société toute entière. D’abord en équipant les Smartphones haut de gamme et les tablettes, puis en réhaussant mécaniquement les attentes de toute la population sur la vitesse minimale acceptable pour une de ces machines. Rendant ainsi peu à peu obsolètes les architectures précédentes et les appareils qui en sont équipés.

ARM V9 succède à ARM V8 qui fête ses 10 années de bons et loyaux services. La nouvelle architecture promet beaucoup de choses avec un focus particulier sur des aspects pratiques en plus d’une hausse confortable de performances. Il ne faut pas attendre les premières puces avant 2022 et celles-ci devraient équiper les smartphones les plus haut de gamme pour commencer. Si vous prévoyez de faire un achat raisonnable, n’anticipez pas un investissement avant 2023 minimum.

ARM V9 va s’imposer peu à peu partout, comme les architectures précédentes ont su le faire. On le retrouvera aussi bien dans le futur au coeur de nos chères cartes de développement que dans l’automobile ou nos téléviseurs. Il faut compter sur la possibilité offerte aux développeurs, ceux qui conçoivent des puces commerciales, d’adapter très largement les puces suivant leurs besoins. La société anticipe 300 milliards de puces dans l’avenir, se basant sur les usages actuels et le fait que son écosystème ne souffre d’aucune concurrence. Autant grâce à sa flexibilité que ses compatibilités logicielles ou sa très faible consommation.

ARM V8 signait le passage au 64 bits, ARM V9 suit évidemment la même voie et assurera une rétrocompatiblité avec sa précédente architecture. Mais les partenaires et développeurs auront de nouveaux outils à prendre en compte. La nouvelle mouture s’intéresse de près à deux éléments importants. L’Intelligence Artificielle et la sécurité.

L’IA est au coeur de beaucoup d’applications désormais. De la biométrie en passant par la retouche d’image ou certains usages récréatifs, les constructeurs comme les développeurs ont bien compris le positif qu’il y avait à tirer d’une solution considérée comme quasi « magique » par le grand public. Voir un smartphone capable de discerner le premier plan du second, détourer automatiquement le visage d’un portrait et flouter le fond pour ajouter un effet de profondeur avant de le basculer en couleur… Cela a un effet impressionnant sur les utilisateurs. Découvrir un logiciel qui vous vieillira ou transformera votre visage en celui d’un personnage de dessin animé, toutes ces applications sont la pointe d’un iceberg d’usages à venir. Les logiciels de reconnaissance vocale, les applications permettant en tâche de fond de gommer le bruit ambiant dans vos conversations, la reconnaissance faciale, tout cela est pris en charge par des IA et ce sont des applications pratiques que veut prendre en charge ARM V9.

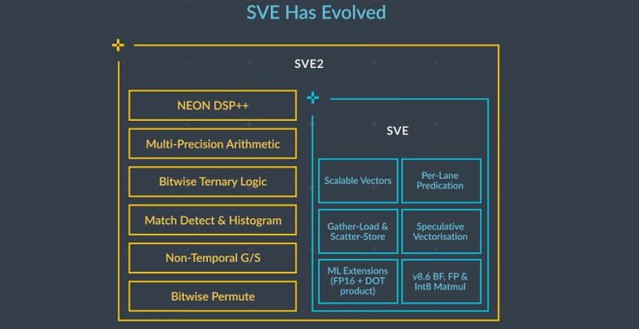

Pour améliorer ses capacités, ARM passe à la seconde version de son jeu d’instruction Scalable Vector Extension développé en partenariat avec le Japonais Fujitsu. SVE2 améliorera les capacités d’apprentissage et de traitement. Cette nouvelle version sera également utilisable par plus d’outils. Ouvrant des perspectives d’usages plus vastes. On parle de ce qui est à la mode : 5G, Réalité virtuelle ou augmentée, traitement d’images… ARM maitrisant toute sa chaine, il anticipe un futur qui prendra en compte l’ensemble des éléments nécessaires et assurera un dialogue. Votre IA portative pourra dialoguer finement et de manière robuste avec les circuits intégrés à votre puce : Des NPU pour le calcul des différentes fonctions, aux GPU Mali pour leur rendu à l’écran.

Autre point mis en avant par ARM V9, la sécurité. Les fuites de données et autres intrusions sont aujourd’hui fréquentes et de véritables groupes organisés se servent de failles pour détourner au quotidien des sommes ou des informations de manière illégale. Assurer un bon niveau de sécurité aux utilisateurs n’est plus une option, c’est une obligation et ARM en a pris conscience depuis un moment.

La CCA ou Confidential Compute Architecture est la réponse d’ARM à cette problématique. Cette solution protège les données comme le code en cours d’utilisation sur vos machines. Les calculs à réaliser sont réalisés à part, dans un environnement différent et protégé. De telle sorte que si une instruction malicieuse essayait d’altérer votre application ou de détourner des données, elle trouverait porte close.

Cette nouvelle approche propose un nouveau concept intéressant, les Realms ou Royaumes. Il s’agit de sortes de bac à sable que peuvent investir les applications pour faire leur travail. Dedans, elles bâtiront les châteaux dont elles ont besoin avec le sable en provenance de vos données. Mais aucun grain de sable ne pourra s’en échapper et aucun château ne pourra s’intégrer ensuite dans vos applications.

Les performances sont évidemment revues à la hausse. D’un point de vue calcul, ARM parle d’un gain de 30% sur les deux prochaines générations. Même si ce chiffre est évidemment très difficile à valider compte tenu de la grande souplesse d’intégration des solutions ARM. Comme il est possible d’intégrer un SoC avec 8 coeurs ultraperformants dès ARM V8, une solution plus classique en ARM V9 ne sera pas forcément plus rapide.

Le concepteur indique cependant travailler à des éléments généraux qui auront un impact fort sur les performances globales de ses SoC. Il est ainsi question de solutions permettant de faire évoluer significativement la fréquence, le cache et la bande passante d’un côté et réduire la latence de la mémoire de l’autre. Des améliorations qui permettront à ARM de proposer plusieurs générations de puces autour de cette nouvelle architecture.

Les GPU Mali seront également mis à jour avec la prise en compte du Ray Tracing brièvement évoquée. Difficile de ne pas voir cette mention comme un rappel de ce qui se joue en ce moment entre Nvidia et ARM. Le premier ayant l’intention de racheter le second et étant prêt à débourser pas moins de 40 milliards de dollars pour y parvenir. Un rachat qui n’est pas du goût de tout le monde et qui est actuellement passé à la loupe par les autorités de concurrence.

| 2,5€ par mois | 5€ par mois | 10€ par mois | Le montant de votre choix |

Ce que je vais dire est un peu hors sujet, et j’ai bien compris que la plupart des visiteurs de ce blog, auteur inclus, ne partagent pas le concept cité, mais quand je lis » le positif qu’il y avait a tirer d’une solution considérée comme quasi “magique” par le grand public », J’ai des frissons dans le dos rien qu’à l’évocation d’une telle horreur

Et quoi après, violer les lois d’Asimov, et pondre des technologies autoporteuses capable de faire évoluer la science par et pour elles mêmes tandis que l’homme pourra se consacrer à sa vrai finalité: une vie de Jouissance et d’hédonisme, son cerveau enfin débrassé de tout ce savoir inutile ?….

(on aurait l’air fin, en civilisation de poètes, de lettrés et d’artistes hyperémotifs vivant au milieu d’artfacts leur étant totalement inconnus mais s’employant à les servir)

Plus sérieusement, j’ai beau en utiliser sporadiquement, j’ai un vrai problème avec l’aspect boîte noire des IAs.

Utiliser pour un traitement un algorithme construit par itérations successives dans un truc qui est incapable de le formaliser a quelque chose de terriblement gênant

@Bastien B.: Je pense que l’un n’empêche pas l’autre et qu’au contraire il faut des gens à la fois artistes, rêveurs et poètes qui comprennent la technologie pour se sentir protégés .ce sont les seuls vrais garde fous face à l’emballement technologique. Les seuls lanceurs d’alertes, les seuls a se pencher sur une question technique pour voir au delà de leur résultat. Il n’empêche que pour beaucoup de monde les technologies employées restent bien plus mystérieuses que tout ce que nous avons connu auparavant. Expliquer le moteur à vapeur à un homme de l’antiquité ne me parait pas impossible parce que l’expérience visuelle permet de comprendre le fonctionnement mécanique des choses.

Expliquer à mes contemporains comment fonctionne une IA pour détecter et gommer le son environnant est ma fois bien plus complexe.

Sinon, je te rassure, on ne finira pas lettrés ou artistes. A priori l’humanité finira par retourner gratter la terre pour faire pousser de quoi manger plus rapidement que prévu.

@Pierre Lecourt: je n’ai pas de problème avec les artistes, chacun sa voie, mais je regrette l’époque ou l’on pensait que pour bénéficier d’une technologie il fallait être prêt à se retrousser un peu les manches, et ou l’on incitait pas à des fins purement mercantile- les gens à se décharger de cette maîtrise pour profiter de l’expérience utilisateurs

Il y a d’autres domaines ou c’est encore compris, comme, puisque tu en parles, l’agriculture: tout le monde sait qu’il faut bien plus qu’un lopin de terre, d’une paire de bottes et de l’envie de profiter du grand air pour devenir exploitant agricole: se former à la botanique, à une exploitation rationnelle et durable des sols, des investissements très lourds… Même les bobo néoruraux comprennent très vite que c’est bien plus fastidieux que « dis Siri, fais pousser ces plans de tomate sur mon balcon pendant que je kiffe le soleil »

Il faut quand même se mettre en tête ce qu’apporte la « technologie magique »

– l’utilisation et donc la production massive d’octacores avec des GPUS hyper véloces pour poster sur instagram, snapchatter et regarder netflix dans le métro, le denier ne servant pas à grand chose, à part faciliter le taf des pickpocket. terres rares bien employées ….

– l’incapacité à ouvrir son appartement quand le sevreur de votre serrure connectée myfox est en rade

et j’en passe…

et ton exemple de l’IA est très juste: tu ne peux expliquer ce qu’a fait ton iA qu’en la clonant, & en répétant la phase d’apprentissage avec cette foi une sonde sur chaque neurone. Tu passes in fine d’un paradigme de contrôle à minima potentiel (même si tu ne maîtrise pas l’algo, il est connu), à un paradigme de confiance

Hello, vu que l’architecture est repensée, je serais intéressé de savoir si l’aspect sécurité de l’ARMv9 prend en compte des dispositions hardware face à Meltdown, Spectre et leurs variants. ARM possède des CPU vulnérables actuellement, notamment après les Cortex A53 si je ne dis pas d’erreur.

@Bastien B.: sans parler de futur, moi ce qui me gêne actuellement dans l’IA à même le hardware, c’est la possibilité de télémétrie dans une boite noire, d’ailleurs, Nvidia en fait si je ne m’abuse. Et comme dit Pierre, les SoC ARM sont des produits pouvant devenir quasi-incontournables.

@Pierre Lecourt:

« Expliquer à mes contemporains comment fonctionne une IA pour détecter et gommer le son environnant est ma fois bien plus complexe »

Je confirme la difficulté de la tâche à ouvrir la boite pour en faire comprendre les enjeux liés à l’utilisation de l’IA … j’interviens auprès de collégiens et lycéens pour leur faire découvrir les métier d’ingénieurs. Au passage j’essaye de leur faire prendre conscience de l’importance des sciences et des technologies dans leur vie quotidienne. J’essaye de le faire à travers leur smartphone (au moins 18 prix Nobel/Abel dans ce petit objet) et ses usages. Ce qui ne cesse de m’étonner c’est le manque de curiosité pour comprendre l’usage de ces outils technologiques. J’essaye de les sensibilier à certains effets (per ex. les phénomène de bulles d’infos liés aux algos de recommandation)

@Bastien B.: Les IA ne sont pas autant des boites noires qu’on le dit, et encore moins aussi magiques qu’on le dit. Pour travailler dedans je peux vous assurer qu’on est loin du soulevement des machines…

Il y a des problèmes qu’on peut résoudre facilement de manière logique, d’autre qu’il convient de résoudre de manière probabiliste. Les IA (en tout cas celles qui font peur) ce sont des outils pour résoudre des problèmes probabilistes.

Par exemple on peut tout à fait faire de la reconnaisance d’image avec une approche logique : on détecte des petits motifs, qu’on regroupe en ensemble de motifs, qu’on regroupe en ensemble de motifs… Et ensuite on va comparer a chaque niveau d’ensemble de motif avec une référence, et on va pondérer en fonction de nombre de sous-motifs correspondant. Au final ce sont des probabilités de détection. Sauf que c’est hyper relou de faire un catalogue de motif, de définir des coeficients pour chaque motif associé à chaque objet, d’ajouter des coefficients supplémentaires de partout pour gérer certains cas limite, du coup on a des outils pour faire ça et ce sont ce qu’on appelle des IA. Elles ne font ni plus ni moins qu’ajuster des coefficients. On pourrait le faire à la main, ca serait long et fastidieux.

Dire que l’IA va détruire l’humanité c’est comme dire que la métaprogrammation va détruire l’humanité. Au final ça reste des outils de programmation, ça fait gagner du temps.

C’est extrêmement long et compliqué de faire une IA qui fonctionne bien, même pour un problème trivial. Le pire c’est que toutes les IA qui traitent des données qui ne sont pas parfaitement normalisées (du son, des images) doivent être régulièrement réentrainées parceque la réalité évolue de façon imperceptible pour nous mais que les IA ne savent pas gérer. Dans ces domaines une IA entrainée à un instant T et qui arrive à 95% de succès sur un problème donné va voir son taux de succès décroire petit à petit, irrémédiablement. Quand on sait la galère que c’est de faire un entrainement pour une IA on comprend vite que l’IA qu’on installe et qui reste au top pour l’éternité c’est de la fiction.

Et là je parle d’IA mais en fait ça veut tout et rien dire. Il y a tout un tas d’algorithmes qui rentrent dans la catégorie « IA » et qui n’ont rien à voir les uns avec les autres. Une véritable panoplie dans laquelle il faut habilement piocher pour résoudre un problème donné. Bien loin de « l’IA » unique au statut de divinité omnipotente.

Vos inquiétudes d’être dépassé par la technologie, c’est l’univers de Warhammer 40k.

Un homme féodal et une église qui prie pour entretenir des technologies qu’on ne sait plus ni produire ni comprendre. Mais qui servent le pouvoir en place.

D’un autre côté, qui ici est capable d’extraire un quelconque minerai d’une colline ? Nous sommes déjà utilisateurs de technologie magique en utilisant un métal, un polymère, l’électricité. Un vêtement tissé…

On peut comprendre les principes de fonctionnement, mais on n’a aucun savoir faire.

Pour recentrer sur le sujet, je suis opposé aux « ia’. Un outil rend plus facile une action humaine. Un automatisme répète une tâche. Une ia réalise une tâche à ma place. Je n’en voit aucun bénéfice. En s’affranchissant de tout, on s’éloigne de l’Homme.

@Axt: il ne s’agit pas de peur, plutôt d’un agacement froid. Je n’ai certainement pas pratiqué à haut niveau, tout juste qq dizaine de neurones, pré gavés par rétropropagation, et j’ai bien compris cette nature probabiliste.

Ca peut convenir pour certaines tâches, mais le problème c’est qu’on nous en vend pour tout, y compris dans des domaines ou on applique traditionnellement des algo déterministes. C’est encore gérable avec des réseaux prégavés, puisque leur réponse à un même stimulus va être invariante. C’est plus emmerdant pour les systèmes autoapprenants, par nature non déterministes au niveau macroscopique, à moins de connaître leur historique

@pierre

« ou certains suages récréatifs »

je pense usages

@Arpenteur: Arf ;) , Arf arf…puisque tu es dans la métaphore 40K, ni l’image de l’adeptus Mechanicus & affiliés (ou même l’impérium en général) (quête de restauration d’une technologie perdue dévoyée en obscurantisme techno religieux interdisant tout progrès) ni l’approche particulière (usage parcimonieux et raisonnée, conservation d’une abse tech propre) de certains mondes (Galvia, Nocturne, la plupart des mondes du coeur d’ultramar) et surtout pas les tau, ne donnent la bonne métaphore

Si je voulais exagérer un peu, je dirais que la bonne est à chercher dans une nouvelle assez ancienne d’un des premier recueils de Black Library appelée « les contes du tortionnaire » et il s’agit des eldars avant chûte, devenus des glandeurs hédonistes finis pendant que des technologies auxquels ils ne pompaient plus rien leur facilitaient l’existance (ceux ayant survécu étant en fait des descendans de colons des marche sde leur empire, ne vivant pas dans cette décadence)

@Bastien B.: « Tu passes in fine d’un paradigme de contrôle à minima potentiel (même si tu ne maîtrise pas l’algo, il est connu), à un paradigme de confiance »

Dans quel cas est-ce un problème ? (C’est une vraie question, hein ?) Même avec un algorithme déterministe au niveau macroscopique, tu es dans un paradigme de confiance dans un cas commercial. Parce que cet algorithme, tu n’y auras pas accès. Lorsque le programme (ou la librairie sous-jacente) est open source, le contrôle est effectivement potentiel. Mais dans le cas de gros programmes, cette potentialité ne sera sans doute jamais exploitée, ne serait-ce qu’à cause de l’effort demandé. Alors en quoi est-ce rassurant ?

Je ne trouve pas gênant que des gens se reposent sans plus y penser sur une « IA » passéiste et finalement assez peu efficace. De toute façon, ils ne savent pas plus comment fonctionne un ascenseur, une porte automatique ou leur voiture. (Moi qui ne veux pas particulièrement d’IA non plus d’ailleurs.) Et c’était la même chose il y a 50 ans.

Tant qu’il y a le choix, tout va encore, non ?

@Kikimoo:

Alors je vais faire ma mauvaise foi en te parlant du droit à l’interopérabilité qui garantit l’accès aux algos…

Plus sérieusement j’ai de manière générale un problème avec la technologie « béquille » onctueuse et transparente qui vous cajole et vous murmure à l’oreille « je vais tout vous rendre facile », dont les IA en tant qu’ingrédient magique « L’IA, ajouter de l’IA, etc… » Ne sont qu’un avatar

Par exemple dans une concession, dés qu’un vendeur vient me vanter pour une voiture la fluidité des lignes, mes réponses sont en général (et pourtant je ne suis oas du tout mécano)

« Cylindrée? Puissance? Autonomie? Coûts de maintenance? Sortez moi la cache moteur deux minutes, je veux voir le routage des durites. Ou est l’oobd? Est il bavard? » ….

A titre personnel, même si je pense que la « relation de confiance » est un mal nécessaire, ne serait ce que pour un accès démocratique à la techno, elle ne doit jamais être la finalité, ne serait ce que parce que ça va contre la logique de l’effort (de maîtrise)

@Bastien B.: Je commencerai par un retour de mauvaise foi : l’interopérabilité d’une machine à laver capable de se configurer en fonction du poids du linge et de la dureté de l’eau ?

Sinon, je suis d’accord avec toi sur le reste. Je suis moi aussi mal à l’aise avec certains arguments de vente. Les béquilles, je préfère m’en passer quand je le peux et les utilise quand je ne sais pas faire autrement ou quand cela ajoute un garde fou. Mais le jeu du confort « aveugle » ne date pas de la période « tout IA » que nous vivons. Le domaine de l’automobile que tu cites est bourré depuis des décennies de ces technologies qui transforme tout modèle en véhicule pour assisté.

C’est pourquoi j’aime les Raspberry Pi et Microbit. Les OS alternatifs, les imprimantes 3D qui marchent presque. Comme j’aimais les smartphone au temps où ils étaient immatures. (Je suis un dinosaure.)

Mais si l’aide à outrance dessert l’autonomie et la responsabilité, en priver ceux qui la veulent est tout aussi déresponsabilisant (puisqu’ils ne l’ont pas choisi). Ce que je constate pour ma part est que les gens autour de moi comprennent bien les tenants et aboutissants d’un ou deux domaines et se repose sur la confiance pour le reste… et c’est déjà pas mal.

Je crois que c’est Jean-Marc Jancovici qui disait en substance : le monde a toujours été complexe et nous ne pouvons pas tout maîtriser ni tout comprendre. L’enjeu devient alors de choisir soigneusement à qui nous pouvons faire confiance dans les domaines qui nous échappent.

C’est pourquoi j’estime que le plus important est d’avoir le choix. À chacun de se ranger dans la catégorie des gens autonomes ou assistés pour chaque domaine de leur vie… sous leur propre responsabilité.