Autant je n’ai jamais cru en la Razer Edge Pro, la tablette à poignées a destination des joueurs PC de la marque, autant ce nouveau Razer Blade ne me laisse pas indifférent. Si ce n’était son tarif, on débute à 1799$, je crois que je pourrais être tenté. Il faut dire que l’engin est séduisant sur le papier pour toute personne qui a déjà lancé une triple session de travail image-video-son et un jeu gourmand dans la même journée.

Etre à l’aise en « mobilité » avec un engin capable d’encaisser réellement ce type de travail de création c’est au minimum avoir mal aux épaules avec un portable lourd et encombrant. La proposition de ce Razer Blade est donc très tentante : 1.87 Kg pour un engin 14″ de 1.68 cm d’épaisseur avec une autonomie annoncée de 6 heures… C’est plutôt alléchant.

Le materiel embarqué est tout neuf, en fait il n’est pas encore sorti : Les pré-commandes débuteront le 3 Juin, date à laquelle le processeur Intel Haswell de quatrième génération devrait être disponible officiellement.

On ne connait donc pas encore la puce qui équipera cet engin à 1800$, probablement un modèle alliant une jolie performance et une dépense d’énergie mesurée. Cette information sera dévoilée lors du Computex.

La partie graphique ne sera pas laissée uniquement à Intel qui, malgré ses annonces d’efforts fait avec sa gamme HD4600 intégrée aux processeurs Haswell, ne fait pas encore le poids pour assurer de bons et loyaux services à un engin dédié au jeu. Razer a donc embarqué une puce Nvidia GTX 765M, un processeur robuste, associé à 2 Go de mémoire GDDR5 dédiée qui permettra d’afficher correctement sur l »écran 14″ 1600 x 900 pixels de la machine. La puce Nvidia sera employée lorsque le besoin s’en fera sentir via la technologie Optimus de Nvidia.

8 Go de mémoire vive DDR3 et un SSD de 128 Go minimum (il pourra évoluer vers 512 Go en option) voilà qui explique également le prix de cette machine de jeu. D’autres éléments ont été mis en avant comme l’emploi d’une puce Wifi performante Qualcomm Killer en 802.11 a/b/g/n et Bluetooth 4.0.

La connectique se compose de 3 ports USB 3.0, une sortie HDMI 1.4a, un port jack combinant casque et micro. L’ergonomie a été pensée pour le jeu avec un clavier adapté et des gestions de raccourcis propres aux machines de la marque. Le Razer BLADE dispose également d’un son Dolby Theater V4 et d’une paire d’enceintes stéréo. Un microphone numérique et une webcam 1.3 mégapixel sont également présents.

On ne sait pas grand chose sur la batterie si ce n’est qu’elle est Lithium Polymer et délivre du 70 Wh. Pas d’info non plus sur la technologie employée pour la dalle de l’écran.

La machine, son processeur et sa carte graphique représentent un bel aboutissement en terme de compacité et d’efficacité : Sur le papier, bien que les 6 heures d’autonomie annoncées ne soient probablement pas comptabilisées en mode jeu ou en travail graphique intensif, le Razer Blade offre de belles possibilités. La compatibilité CUDA et OpenCL de la carte graphique associée à un processeur performant permettront des travaux d’édition vidéo lourds comme un vrai travail de retouche d’image ou de création audio. Dans le même temps l’offre devrait pouvoir satisfaire des joueurs exigeants à la recherche d’une solution réellement mobile. Razer assure que même son alimentation est compacte et colle au 34.5 cm de large pour 23.5 cm de profondeur de son 14″.

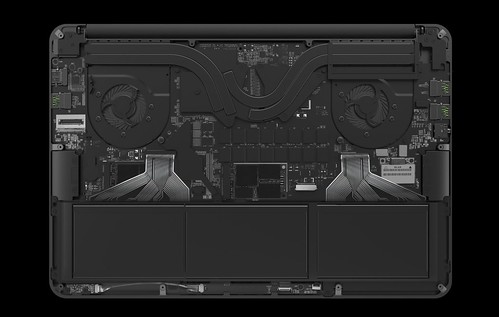

Enfin, le Razer Blade est censé rester « discret » et convenablement refroidi par un système de dissipation sur mesure. Si cela se confirme et si les performances sont bonnes, je pense que ce type d’engin pourrait trouver un public lassé des solutions actuellement mise en avant pour les joueurs. Reste que si Razer est le premier à dégainer sur ce marché de la machine compacte à destination des joueurs, les autres acteurs du marché ne devraient pas tarder a proposer leurs propres solutions : Asus, MSI et Alienware ont du également réfléchir à des engins plus fins pour ce public particulier.

Source : Razer

| 2,5€ par mois | 5€ par mois | 10€ par mois | Le montant de votre choix |

Whaou need

512 go pierre ptite coquille

En effet, une belle machine et très polyvalente. Ça laisse rêveur !

Reste que c’est vraiment un produit de luxe, dans lequel la mobilité se paye le prix fort.

Ce n’est pas tout à fait le même usage, mais mon 17″ ROG avec son Core I7 pas ULV, ses 2X750MO de HDD (dont l’un remplacé par un SSD), ses 16GO de RAM et sa Geforce GTX 670MX (3GO de RAM) payé 1300€ l’année dernière sera toujours plus confortable et performant tout en restant transportable, pour 500€ de moins.

En contrepartie il pèse le double, a l’autonomie d’une moule pas fraiche et n’est de toutes façons pas vraiment exploitable dans les transports.

Un usage à bien réfléchir donc, probablement à réserver aux grands voyageurs, aux professionnels qui ont besoin de puissance graphique en déplacement et aux plus fortunés des gamers.

tres belle machine,à tous niveaux

Intéressant Pierre. Perso j’attends le 14nm pour le Intel et le 20nm pour le GPU pour ce genre de machine. Fin 2014.

Très belle machine effectivement.

Pas sûr qu’une version Azerty voit le jour en revanche.

Le tarif est certes élevé, d’autant que je ne connais pas la « valeur » de la carte graphique annoncée, mais ce n’est pas si aberrant quand on voit le prix d’un ultrabook « classique » ou d’un macbook.

Ships to US and Canada only

sur la précommande…

Dommage

Quelqu’un aurait une idée du titre de la bande son utilisée ? <3

J'ai essayé de shazamé mais pas de résultat :(

On dirait un MBP peint en noir…

ça serait quand même vachement bien si les constructeurs essayaient de développer un système de carte graphique externe pour brancher une carte de PC de bureau sur le portable.

Vraiment sympa. Pour mon travail j’ai un pc portable puissant mais super lourd, j’avoue que je le troquerais volontiers contre celui-ci. Par contre il va falloir attendre que ce type de solution se démocratise parce que je ne me vois pas mettre plus de 1.000€ dans un pc portable.

A ma grande surprise, j’apprends que la GTX 765M avec ses 2GO de GDDR serait plus performant que la GTX 670MX. Bien que son architecture la prédestine à être inférieure, sa fréquence plus élevée fait la différence:

http://www.notebookcheck.net/In-Review-Nvidia-GeForce-GTX-780M-GTX-770M-GTX-765M.93277.0.html

Très impressionnant, reste à voir la consommation réelle de ce modèle.

le même en 12’5 (car 14′ reste trop gros pour moi) et je suis aux anges !

et puis en Ci5+GPU plus light biensur…

mais j’adore le design, et oui un vrai petit mbp black, mais il ne ressort que mieux ! :)

… par contre il faudrait attendre les soldes car là c’est juste pas possible … :D

Il est trop beau !!! Le meme en 13 pouces et si ils se sentent obligés ben ils mettent une gt 740m / 730m et un atom new gen (ou un apu new gen quand ils sortiront tous !)

Superbe

Sympa en effet, mais mettre des touches fleches si petites pour un portable de gameur, n’est ce pas une Hérésie/Connerie ??

@CerfVolant: non ils utilisent plutôt ZQSD

Magnifique mais dommage pour la resolution, quand ils arrivent a cote a mettre du full hd sur du 13 pouce.

Je vais refroidir l’enthousiasme ambiant avec le surlignage de deux petits mots de l’article de Pierre : « Optimus Nvidia ». Cette épouvantable cache misère logiciel est le gage de multiples ennuis à l’usage au niveau des graphismes.

J’ai eu un netbook de chez alienware avec cette technologie, je n’ai pas tenu une semaine avant de le revendre.

Pour mémoire Optimus est la réponse à Intel qui a introduit une carte graphique dans tous ses nouveaux processeurs, rendant inutile l’intégration d’une autre carte. Du coup nvidia prise à la gorge à bricolé ce truc qui est sensé switcher de la carte intégrée à sa propre carte, dès qu’on passe en affichage directX. Oui mais voila depuis Windows 7 on est tout le temps en directX. Du coup la surcouche logicielle est sensée inventorier les logiciels de jeu et démarrer la bonne carte au bon moment.

Enfin razor avait planifié un clavier oled ou tft totalement reconfigurable ou réassignable, qui semble-t-il est passé à la trappe.

Bref, c’est comme une très jolie fille avec un furoncle sur la fesse.

@Dadoo: J’ai un Samsung avec cette techno Nvidia Optimus = aucun soucis. La surcouche logicielle établit certes un profil par défaut pour chaque application à lancer, mais il est possible de modifier ce choix manuellement et très simplement (un simple clic droit sur une appli permet de choisir).

@Dadoo: Faudrait que tu ré-essaye sur une machine récente à l’occasion :) Le furoncle s’est ptet transformé en joli grain de beauté :)

mmm, j’ai déjà donné.

En fait sur la technologie optimus j’estime qu’il y a tromperie, en faisant passer pour un avantage une obligation matérielle propriétaire destinée à prendre des parts de marché par intel sur nvidia.

Le fait que leur guéguerre aboutisse à cette absurdité carrément sur nos machines est inadmissible. Je suis contre l’importation de conflits situés à l’étranger sur le territoire national :)

Les deux gpu ayant désormais des exigences en énergie considérables, on ne peut même pas dire qu’on économise la batterie.

La seule solution serait de pouvoir désactiver dans le bios une des deux cartes et encore il faut apprécier trimbaler dans sa machine du matériel désactivé ou bridé, ce qui ma foi est une spécialité de chez intel depuis le tout début de la gamme x86.

@Dadoo: On peut désactiver la carte Intel.

@Dadoo: A l’usage, je peux te garantir que les 2 gpu ne consomment pas la même chose, notamment par le fait que si on fait tourner la Nvidia, c’est qu’on a besoin de ressources graphique là où la HD4000 est trop limitée, et là… cela consomme sévère sur la batterie (et au passage on entend bien le ventilo aussi). Par contre, pour un usage « standard » du PC, la HD4000 est moins sollicitée, et surtout moins gourmande, du coup la batterie ne se vide pas à grand V et le ventilo est presque inaudible.

A titre d’exemple, en usage « standard » (mixe surf, bureautique, vidéo) mon Samsung se balade sur batterie dans les 5H. Dès que je passe en mode jeu, l’autonomie chute à environ 3H, mais d’un autre coté, je balance mes jeux en « full tout » et c’est parfaitement fluide (chose que ne me permet pas la HD4000).

L’ajout d’un GPU complémentaire à celui d’Intel, c’est aussi que le premier a sa propre ram dédié là où celle intégré par Intel se partage la mémoire dédié normalement au processeur. Pour le coup, si j’utilise la HD4000 sur un jeu, elle me bouffe le maximum de ram possible et du coup la mémoire restant dispo pour le processeur est moindre.

Donc, pour ma part, et alors que je découvre cet Optimus truc much, je trouve que c’est plutôt une bonne solution ; Après peut-être que quand tu en avais l’expérience ce n’était peut-être pas au point, mais là il semble que ce soit assez probant (enfin pour le moment).

Quand j’ai réagit sur ce billet je voulais juste prévenir les futurs acheteurs d’un système sous optimus qu’ils allaient vers des problèmes.

Je voulais aussi dénoncer la malhonnêteté marketing qui fait passer cela pour un avantage, alors que clairement c’est un cache misère initié par nvidia à cause d’Intel.

Bien entendu en jeu la nvidia va consommer plus mais en mode bureautique elle fera jeu égal ou mieux avec la 4000 embarquée, j’ai consulté notebook check à ce sujet. Et comme on me le fait remarquer à propos, elle a sa propre mémoire dédiée donc elle n’empruntera pas les ressources de la machine.

Conclusion, la hd4000 ne sert bien à rien, on ne peut simplement pas la séparer du processeur car elle y est intégrée.

Après chacun fait ce qu’il veut, à lui le bonheur d’un linux sous ce système, ou encore une future mise à jour Windows etc.

J’ai encore eu à faire avec des machines sous optimus depuis la préhistoire (l’alienware c’était il y a un an et demi)et ca s’est terminé par une désactivation de la carte nvidia.

Evidemment il est de notoriété publique que sa propre expérience ne sert jamais aux autres ; pourquoi je m’entête moi ?

@Dadoo: « Evidemment il est de notoriété publique que sa propre expérience ne sert jamais aux autres ; pourquoi je m’entête moi ? »

Au contraire, l’expérience de chacun est bénéfique aux autres, la tienne tout autant que la mienne, ou que n’importe quelles autres ;-) Continue de t’entêter ;) Les contradictions des uns ou des autres enrichissent le débat. C’est d’ailleurs ce qui fait l’intérêt de MiniMachines, on peut se contredire sans s’invectiver, dans la bonne humeur et la tolérance. Le débat est toujours intéressant quand chaque partie apporte sa pierre.

Je ne conteste pas ton « Je voulais aussi dénoncer la malhonnêteté marketing qui fait passer cela pour un avantage, alors que clairement c’est un cache misère initié par nvidia à cause d’Intel. », bien au contraire je le partage. Tu as également probablement raison en cas d’usage de ce « couple infernal Intel/Nvidia » sous Linux, il y a trop longtemps que j’ai lâché ce système pour me prononcer.

Le système Optimus existe, inévitablement il y aura des « Pour » et des « Contre ». Cela dépend donc des usages de chacun ;-)

^_^

@Dadoo:

Je ne comprends pas ta position, et ne suis pas convaincu que tu aies bien compris le fonctionnement de la technologie Optimus.

Pour commencer, les processeurs graphiques intégrés aux solutions Intel datent du début des années 2000. Leur présence n’a jamais posé de problèmes à Nvidia, dont les cartes bien plus puissantes étaient déjà embarquées en surplus sur les machines intel. Il suffisait de désactiver la puce Intel dans le BIOS et d’utiliser la Nvidia à la place, de la même manière que si aucune puce Intel n’avait été prévue.

Par la suite, les constructeurs ont de plus en plus travaillé sur des solutions d’optimisation de la gestion d’énergie des machines. C’est dans cette optique que se sont développés les processeurs mobiles et cartes graphiques mobiles, plus économes en énergie et en dissipation thermique. Jusqu’à l’arrivée des particulièrement autonomes Atoms chez Intel, que Nvidia a suivi avec sa gamme Ion.

Reste que les cartes Nvidia représentaient un handicap d’autonomie pour les machines sur lesquelles elles étaient embarquées. Plus puissantes, elles consommaient aussi plus d’énergie.

C’est ce constat qui a poussé certaines marques (Sony en tête pour ses ultraportables) à proposer un switch physique sur leurs machines permettant d’activer et désactiver la puce Nvidia en fonction des besoins de l’utilisateur.

Une idée plutôt bien pensée qu’Nvidia a décidé d’intégrer à ses solutions avec une fonction logicielle « intelligente » pour effectuer le switch sans intervention de l’utilisateur. Une solution qui permet de bénéficier du meilleur des mondes dans les deux situations: Usage bureautique ? La carte Nvidia n’est pas en service, l’autonomie est optimale. Besoin de puissance graphique ? Optimus détecte ce besoin et active la puissance carte Nvidia.

Dans la pratique, ce fonctionnement s’accompagne de certaines contraintes: Le logiciel tourne en tâche de fond. Il peut planter ou être mal configuré, et ne pas activer la carte Nvidia chaque fois que ça serait nécessaire. Mais la solution a bien évolué avec le temps, et ce genre de problèmes se font de plus en plus rares. En outre, comme l’indique Mxte29fr il est possible de configurer le fonctionnement d’Optimus de manière plus personnalisée.

Dés lors, je ne comprends pas ton « Je voulais aussi dénoncer la malhonnêteté marketing qui fait passer cela pour un avantage, alors que clairement c’est un cache misère initié par nvidia à cause d’Intel ».

J’ai peut-être manqué quelque-chose dans tes explications: ce ne sont pas les dysfonctionnements du système que tu sembles pointer, mais son fonctionnement.

Pourtant, ce fonctionnement n’a rien d’un cache misère ? Il permet effectivement de bénéficier d’une autonomie accrue en usage bureautique sur une machine capables de tâches vidéo plus lourdes en cas de besoin.

« Bien entendu en jeu la nvidia va consommer plus mais en mode bureautique elle fera jeu égal ou mieux avec la 4000 embarquée, j’ai consulté notebook check à ce sujet. »

Pour résumer si je comprends bien tes propos, tu reproches à Nvidia d’avoir fait d’énormes progrès sur la consommation de ses puces en mode bureautique et de continuer à proposer Optimus. Une telle situation me surprendrait beaucoup: Nvidia vend des solutions graphiques, pas Optimus qui n’est qu’un outil qui permet d’optimiser l’usage de ces solutions. A mon avis, la marque se ferait un plaisir de faire savoir que sa propre puce est meilleure sur tous les fronts que la solution Intel.

Je veux bien tes sources, j’ai cherché en long en large et en travers sur notebook check et je n’ai rien vu sur le sujet. Les seules informations pertinentes que j’y ai trouvé pour le moment sont les suivantes:

HD 4600: 22nm 3D Tri-Gate, 20 cores @ 400 – 1350 MHz // Conso estimée 37 à 47W **il s’agit de la consommation de l’ensemble processeur quadcore + solution graphique**

Source: http://www.notebookcheck.net/Intel-HD-Graphics-4600.86106.0.html

GTX 765M: 28nm, 768 cores @ 850 MHz // Conso estimée 50 à 75W **pour la solution graphique seule**

Source: http://www.notebookcheck.net/NVIDIA-GeForce-GTX-765M.92907.0.html

Je ne comprends pas bien comment une solution mieux intégrée de 20 cores gravés en 22nm et tournant à 400 MHZ pourrait consommer plus en mode bureautique qu’une autre de 768 cores gravés en 28nm et tournant à 850 MHZ. Si tu as un article sur le sujet, ça m’intéresse au plus haut point.

« Conclusion, la HD4000 ne sert bien à rien, on ne peut simplement pas la séparer du processeur car elle y est intégrée. »

En fait, le fait qu’elle soit intégrée est plutôt un atout. L’ensemble processeur + solution graphique se partages les ressources disponibles en fonction de la manière dont elle est sollicitée. Si la partie graphique est désactivée, le processeur se montrera plus véloce et/ou plus économe en énergie.

Alors c’est sur qu’Optimus n’est pas parfait. Il n’est pas compatible avec Linux, ce qui est un élément important à prendre en compte pour les linuxiens lors de l’achat de la machine. Il n’est pas 100% fiable dans sa reconnaissance des applications gourmandes en puissance, mais les options de configuration permettent de résoudre la plupart des problèmes.

La solution reste plutôt intéressante, et les feedbacks des testeurs sont globalement positifs, même avant que son fonctionnement soit optimisé:

http://www.notebookcheck.net/Nvidia-Optimus-Review.25467.0.html

http://www.laptopspirit.fr/test-de-la-technologie-nvidia-optimus-un-choix-judicieux

http://www.01net.com/editorial/512758/nvidia-optimus-pour-des-pc-portables-autonomes-et-performants/

Ce que je disais, a quoi bon m’entêter, apparemment tu as compris mieux que moi car tu as fait des recherches sur des sites qui reprennent mot pour mot les plaquettes des conf de presse de Nvidia.

J’ai lu ton post, il y a trop de choses à discuter et je ne le ferais pas.

Mon objectif est d’introduire le doute, pas de donner des leçons ni de convaincre. Par la suite certaines personnes vont saisir le message, d’autres vont reproduire l’information qu’ils ont lue ici ou là.

Ce serait nier la réalité de la guerre qui oppose intel à nvidia et dont optimus n’est qu’un artifice qui permet à nvidia de continuer à vendre. A ton avis si la hd5000 ou 6000 à venir fait presque aussi bien que nvidia, que va devenir optimus ? Voilà, fait toi du bien, doute ! ^_^

@Dadoo:

Ben… Nvidia se fout d’Optimus ? C’est un outil pour optimiser l’usage de ses produits.

Les puces graphiques d’Intel montent en puissance, c’est certain. Mais ils ne pourront jamais rivaliser avec des fonctions graphiques intégrées face à une carte dédiée comme celles proposées par Nvidia avec ses Gforce. A moins peut-être de créer une nouvelle gamme deux fois plus chère et qui consommerait deux fois plus d’énergie, mais je n’ai rien vu dans ce sens pour le moment.

Ce qu’Intel concurrence surtout, ce sont les solutions AMD qui proposent eux aussi des GPU intégrés au processeur et pour le moment à des tarifs inférieurs pour une puissance graphique supérieure.

Mais ce qui m’intéresse surtout dans ton post, ce sont tes sources concernant la consommation des puces Nvidia en bureautique. Parce-que si elles consomment effectivement moins que les modèles Intel, alors effectivement la techno Optimus devient complètement obsolète: Il suffirait d’utiliser exclusivement la carte Nvidia pour obtenir une solution plus cohérente.

Je ne suis pas un expert en conception de processeurs, j’établis mes raisonnements sur les données à ma disposition. Il est possible que tu disposes d’informations qui m’échappent qui justifient une position aussi catégorique de ta part. Je suis là pour apprendre, et j’aimerais comprendre. Je t’en prie, partage ta science avec nous.

PS: Note que j’ai tout de même commencé par la même référence que toi pour les tests, à savoir Notebookcheck. Pourquoi les discréditer dans ta réponse, alors que tu semblais leur faire confiance dans le message précédent ? Surtout qu’à la lecture du test, tout laisse à penser qu’ils basent leur jugement uniquement sur leurs observations.

@fred: J’ai eu la même réaction !

Pour info, il intègre un i7-4702HQ qui est un quad core avec HT, nickel pour bosser. Bref, à part la résolution de l’écran, ça semble être un quasi sans faute !

@Moumoule:

Sa résolution me semble parfaite au contraire: un très bon compromis entre finesse d’affichage et gourmandise en puissance graphique, qui devrait permettre de faire tourner les jeux les plus récents en résolution native sans sacrifier trop de paramètres visuels.

Il ne faut pas oublier que c’est avant tout une machine étudiée pour les gamers,

@uko: Tout à fait d’accord avec toi !

Mon problème c’est que je cherche un portable de cette trempe mais avec une dalle full hd quitte à avoir des problèmes de performances graphiques dans les jeux récents. C’est surtout pour combiner le jeu et le travail en fait.

vraiment ras le bol de cette merde d’hdmi, ON VEUT DU DISPLAY PORT pour nos écran 1440P !