Mise à jour : La mini caméra JeVois-A33 est désormais disponible à l’achat directement auprès du site du concepteur. A 49.99$ pièce cela peut être une solution intéressante pour vos développements.

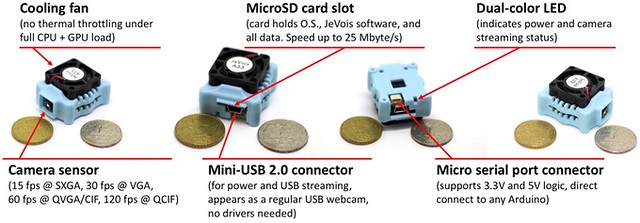

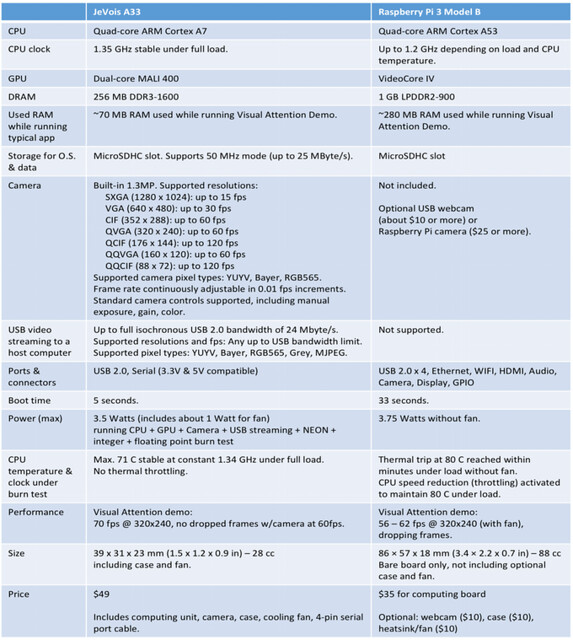

Billet d’origine du 3 Janvier 2017 : JeVois c’est une mini caméra et un SoC quadruple coeur assemblés dans un format minuscule de 39 mm sur 31 et 23 mm d’épaisseur. Son prix officiel est de 49$ et ce petit objet est capable d’ajouter une vraie vision à tout type de projet.

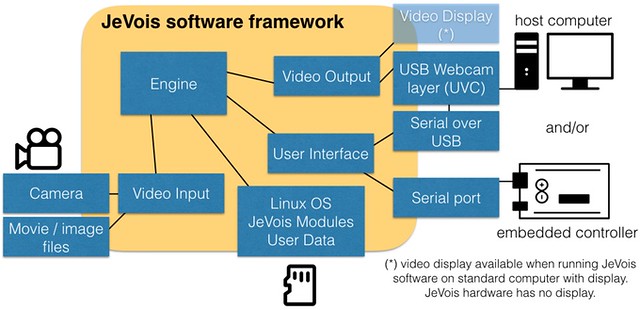

Quand je parle de vision, je ne parle pas uniquement d’image. Je parle de lecture et de compréhension d’un environnement. Le capteur de la JeVois porte très bien son nom et il peut tout à fait capturer et transmettre des images de manière classique mais surtout, et c’est bien plus intéressant, il peut analyser l’espace qui l’entoure pour transmettre des informations plus précises avec un rafraîchissement tout à fait étonnant.

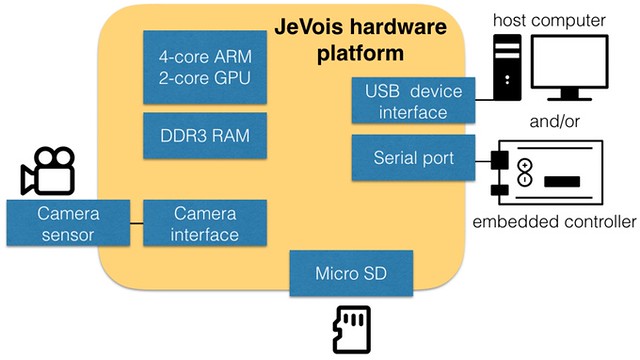

L’objet à beau être minuscule, il propose un capteur vidéo, un soC quadruple coeur Cortex-A7 associé à un chipset Mali 400 double coeur, 256 Mo de mémoire DDR3 et stocke son système sur une carte MicroSDHC. Le gros atout de la solution vient du développement d’un système Linux ultra léger et rapide capable de prendre en charge de manière très optimisée les instructions du SoC pour interpréter à une vitesse hallucinante les données en provenance de l’oeil du système.

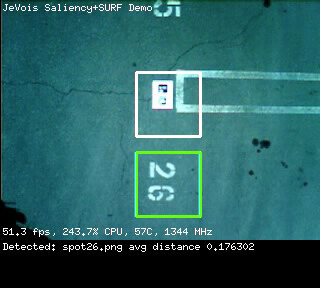

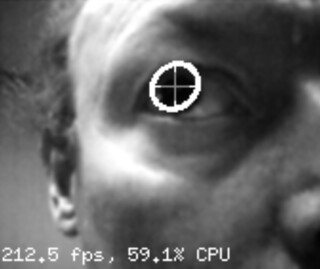

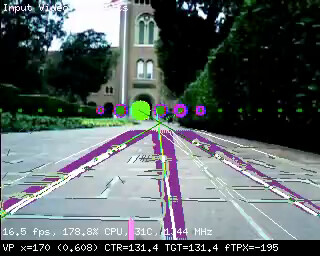

Codes vus par un drone ou un robot équipés de JeVois

EyeTracking et détection de lignes directrices en mouvement.

Il est ainsi possible de détecter des mouvements, des QR Codes et autres symboles mais également des visages, des nombres ou des éléments déjà appris… à 120 images par seconde ! Soit le maximum rendu possible par la caméra embarquée. Une détection de mouvement d’oeil se fera ainsi à 120 images par seconde par la caméra pendant que le processeur détectera, quant à lui, à un rythme encore plus soutenu de 200 analyses par seconde.

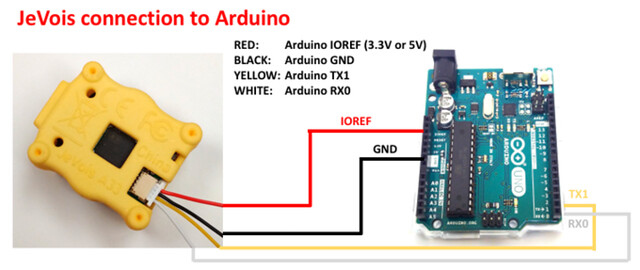

Une interface simple pour connecter une arduino

A quoi cela sert t-il ? A rajouter un sens et de l’intelligence à des circuits déjà en place ou à concevoir des objets ou des applications qui en tireront parti. JeVois est totalement documenté et Open source. Vous pouvez donc trouver des solutions déjà développées ou concevoir les vôtres. Vous pouvez également améliorer le système embarqué même si d’énormes optimisations semblent déjà avoir été faites .

JeVois démarre en 3 secondes et affiche déjà des compatibilité Arduino, Windows, MacOS X, Android, iOS et Linux. Vous pouvez aussi bien ajouter JeVois à un smartphone pour concevoir une application que le combiner à une carte Arduino ou Raspberry Pi. Vous pouvez même développer vos propres circuits pour la rendre compatible avec un drone ou un projet existant. La documentation déjà disponible en ligne est impressionnante et montre le sérieux de l’équipe de développement.

Pour bien comprendre le potentiel de l’objet, je vous invite sincèrement à regarder la vidéo de présentation jusqu’au bout (même si vous détestez les vidéos), on y découvre une très parlante série d’exemples des possibilités de la solution. Et la vitesse de traitement proposée ainsi que la robustesse de la détection est proprement étonnante.

| 2,5€ par mois | 5€ par mois | 10€ par mois | Le montant de votre choix |

Le petit ventilo au dessus fait quand même pas mal peur.

Je suis né trop tôt… :-(

J’aurais adoré travailler sur ce type d’applications.

Il y a beaucoup à faire encore, mais cela avance à grands pas. Bravo!

@Cid: Ce n’est pas une webcam ! Sur certains passage de la vidéo on voit que la qualitée « visuelle » est volontairement dégradée pour gagner en vitesse de rafraîchissement. L’idée n’est pas de voir le monde en détails et en couleurs à 2 images par seconde mais de l’appréhender clairement suffisamment à plus de 60. Quand tu vois le modèle réduit de voiture qui doit monter à 35-40 Kmh, lui ajouter une vision parfaite en 2 images secondes couplée à un contrôle auto, c’est le plantage assuré. Monter à 60 images par seconde avec analyse et le véhicule peut prendre des décisions : Freiner, tourner, ralentir…

@jorge-c: Il est jamais trop tard !

@brazomyna: Bah, sur une application sédentaire ça doit pouvoir se fanless-iser, sur un drone ou un véhicule électrique… ce n’est pas très important !

Ok c’est miniature (sans compter la batterie…) et rapide mais le capteur est vraiment de faible résolution. On sait qu’un Kinect d’il y a 7 ans ne sait pas différencier les doigts avec un capteur similaire (mais plus lent et avec le traitement de la grosse xbox derrière). Bon c’est un premier jet, à suivre.

(J’ai l’araignée verte de Silverlit qu’on voit dans la video :) J’en fais rien et ça sert à rien, les gosses ont joué 5 minutes et basta… Si quelqu’un la veut pour bricoler…)

@jorge-c :

Vous savez même si vous êtes actuellement dans un hospice ( terme poli pour désigner » un mouroir » ) , vous pouvez toujours essayer de vous inscrire à des fablab de votre commune pour vous initier .

Ca vous fera un peu de sortie pour vous et pour votre infirmier .

mouais à voir en réalité ça me rappelle la plainte vinyle suspendue ou bien les lunettes de réalité augmentée…dubitatif je suis

@niakola: La différence c’est qu’ici le développeur derrière le projet n’est pas vraiment un rigolo hein, c’est un scientifique reconnu :

http://ilab.usc.edu/itti/

Ce projet m’avait tapé dans l’oeil moi aussi (mouarf), le potentiel est incroyable pour tous les bidouilleurs qui peuvent ajouter des fonctionnalités inaccessibles sans de nombreuses années de dev dédiées à ce domaine de recherche sans se prendre la tête. Et la rapidité est inouïe par rapport à ce qui existait auparavant.

Si vous cherchez une bonne qualité vidéo, étant donné le faible coût de la solution, celle-ci peut très bien être utilisée comme un pointeur autonome clef en main pour diriger une solution HD stéréoscopique ensuite par exemple, à destination de restitution humaine ou de traitements plus complets et plus lents sur un deuxième étage de process.

@Bernique bleue: Je crois que c’est exactement cela le point clé. On rajoute un oeil à un projet en un tournemain. Pas une caméra, un oeil; un truc autonome que le projet quel qu’il soit pourra gérer de manière autonome pour prendre des décisions (éviter un obstacle, lire des instructions, adapter une trajectoire) et non pas une restitution vidéo pour qu’un humain prenne la décision à sa palce (souvent bien trop tard pour un drone).

On peut très bien alors imaginer des solutions DIY capables de aire aussi bien que les solutions les plus avancées : Drones d’invetaires, detection de mouvemetns d’yeux, solutions de détection de formes… etc.

Je lui aurais plutot adjoint un petit module à effet peltier,

avec un petit radiateur Aluminium !

C’est tellement plus mignon…

Très belle trouvaille Pierre. J’étais passé a côté la première fois mais il va falloir que je regarde ça de plus près.

Merci Pierre. Est-ce que quelqu’un sait quel est le moteur de reconnaissance d’image dans le bouzin ? Ha ! Trouvé !

Je travaille actuellement avec Python et je fais de la reconnaissance d’image avec la bibliothèque OpenCV : visiblement (humour) ce truc utilise aussi OpenCV.

Ce doit être possible de faire la même chose avec une Orange Pi et un capteur quelconque (pour moins cher), mais bon, là c’est déjà tout « assemblé ».

OpenCV ça fonctionne vraiment et les résultats peuvent paraître stupéfiants au grand public, alors que c’est disponible en open source et déjà utilisé par exemple dans des solutions telles que Sikuli : vous pouvez facilement essayer chez vous !

Un indicateur de limite de vitesse SVP !!!

@Starlord @pierre

La aussi on est sur de la capture openCv l’auteur parle de eyeTracking mais le flux d’images n’est pas suffisant a mon avis pour y connecter un clavier virtuel comme avec le logiciel ACAT pour l’astrophysicien Hawking. j’attends une deuxieme version. Cela m’a l’air D’etre prometteur.

Le concept n’est pas nouveau (ces caméras sont appelées « smart cameras » depuis nombre d’années), et se retrouve le plus souvent dans des caméras industrielles à plusieurs centaines ou plusieurs milliers d’euros.

Ici le tarif est très bas, et permet de penser à des applications personnelles ou éducatives. Cela se rapproche de l’esprit de la Rpi originelle, fournir un moyen peu coûteux de se former à certaines technologies.

Un point cependant : le processeur intégré doit sert au pré-traitement et donc réduit la quantité de données qui « sortent » de la caméra (on envoi un résultat de traitement, l’image originelle est souvent inutile), dans ce cas il est dommage d’avoir fait l’impasse sur un connecteur Ethernet ou le wifi g qui auraient surement été suffisants dans beaucoup de situations, permis l’utilisation aisée de plusieurs caméras en même temps et pourtant éloignées de la machine centrale (PC? Rpi, …), à un tarif je pense assez contenu

Dans tous les cas c’est un concept intéressant et inspiré, si le produit est bien suivi, je leur souhaite du succès

Pour info et avant de se précipiter, les vitesses officielles du capteur CMOS reprises du site officiel :

Camera sensor: 1.3MP camera with

SXGA (1280 x 1024) up to 15 fps (frames/second)

VGA (640 x 480) up to 30 fps

CIF (352 x 288) up to 60 fps

QVGA (320 x 240) up to 60 fps

QCIF (176 x 144) up to 120 fps

QQVGA (160 x 120) up to 60 fps

QQCIF (88 x 72) up to 120 fps

Donc 120fps oui, mais en tout petit !

@KrazyMe: Oui, mais ce n’est pas le sujet ! Voir ma réponse de Janvier ici.

Pour simplifier, les algorithmes de traitement de vision informatique basés sur des informations 2D ont besoin de 2 éléments fondamentaux :

– une colorimétrie stable sur un laps de temps suffisant (en noir et blanc ou couleur), dépendante principalement des conditions de lumière, cette partie est difficile à gérer à 100% par la partie capteur elle-même et donc souvent corrigée par des algorithmes complexes

– une résolution suffisante pour détecter les changements de couleur/luminosité et ainsi détecter des objets dans l’image; dans le cas d’une image floue ou avec une résolution trop faible les objets peuvent se mélanger car les bords ne sont pas assez flagrants pour une décision fiable

S’il y a en plus du mouvement, la vitesse devient elle aussi fondamentale car elle va permettre d’effectuer des comparaisons à des moments différents et ainsi aider à détecter les objets d’une image à l’autre et également suivre les mouvements de ces objets (en effet si une balle passe d’un bout à l’autre de la capture d’une image à l’autre il est quasiment impossible de considérer qu’il s’agit du même objet dans un environnement naturel)

Elle réduit en plus le temps de réaction comme Pierre l’a déjà fait remarqué

Ainsi le choix de la résolution et de la vitesse dépend donc de la finalité du système, par example :

– pour détecter un déplacement dans une pièce dont l’éclairage est relativement constant alors une résolution relativement faible et une vitesse importante (>= 30fps) est à privilégier,

– par contre s’il faut identifier et qualifier la raison du déplacement (humain, animal, balle), la résolution devient primordiale

Exemple complémentaire : dans les commentaires j’ai vu une ou 2 références à de la détection de mouvement d’yeux. Comme les gens n’aiment pas trop avoir une caméra à quelques centimètres de leur oeil, il est nécessaire de reculer la caméra, d’avoir un angle de vue relativement grand (car les gens bougent et tremblent même lorsqu’ils sont statiques), et nécessite donc une résolution assez élevée. En plus puisque l’oeil bouge rapidement, la vitesse est elle aussi nécessaire…

Je ne juge pas le produit en lui-même qui me semble excellent à première vue du fait de ses possibilités par rapport à son tarif.

Je pointe juste quelques limitations inhérentes aux choix d’origine qui à mon avis se basaient tout d’abord sur la fourniture d’une solution fonctionnelle mais en même temps peu couteuse, ce qui nécessite de toute évidence des compromis (un peu comme ceux effectués avec la première Rpi avec un processeur lent, pas de wifi, de l’USB non standard, etc…, on connait maintenant son succès)

A voir donc comme une solution d’apprentissage capable de toute évidence de permettre d’ajouter la fonctionnalité « vision » à de nombreux projets à moindre coût avec des limitations elles aussi évidentes

Bonne soirée à tous